Depuis la publication de 2006, d’Astier and al., J. Am. Chem. Soc., la communauté scientifique attendait la révolution du séquençage 3ème génération que constituait la géniale idée d’Oxford Nanopore : à savoir l’alliance des nanotechnologies, du génie génétique le tout à des fins de séquençage (et plus si affinité). Ainsi, un pore d’alpha-hémolysine (d’environ 1 nanomètre) ou la porine A de Mycobacterium smegmatis ou bien encore du graphène ont été investigués pour devenir le pore idéal dans lequel, après clivage par une exonucléase des liaisons phosphodiester, les bases azotées dont l’enchaînement constitue le séquençage passe afin d’être analysées (par analysées on entend lues, la lecture étant basée sur la différence de conductance électrique liée à la nature chimique des bases azotées). Le pari, pour Oxford Nanopore réside dans le fait de trouver un mode de détection suffisamment sensible pour analyser puis par puis un signal généré par le passage d’une base au travers de pores (autrement appelés trous). La résolution de la technologie constituait un défit, sa faiblesse provenait (espérons que ce verbe se conjugue aujourd’hui au passé) de la rapidité de passage des bases à travers le pore (1 à 5 µs / base)…

Depuis la publication de 2006, d’Astier and al., J. Am. Chem. Soc., la communauté scientifique attendait la révolution du séquençage 3ème génération que constituait la géniale idée d’Oxford Nanopore : à savoir l’alliance des nanotechnologies, du génie génétique le tout à des fins de séquençage (et plus si affinité). Ainsi, un pore d’alpha-hémolysine (d’environ 1 nanomètre) ou la porine A de Mycobacterium smegmatis ou bien encore du graphène ont été investigués pour devenir le pore idéal dans lequel, après clivage par une exonucléase des liaisons phosphodiester, les bases azotées dont l’enchaînement constitue le séquençage passe afin d’être analysées (par analysées on entend lues, la lecture étant basée sur la différence de conductance électrique liée à la nature chimique des bases azotées). Le pari, pour Oxford Nanopore réside dans le fait de trouver un mode de détection suffisamment sensible pour analyser puis par puis un signal généré par le passage d’une base au travers de pores (autrement appelés trous). La résolution de la technologie constituait un défit, sa faiblesse provenait (espérons que ce verbe se conjugue aujourd’hui au passé) de la rapidité de passage des bases à travers le pore (1 à 5 µs / base)…

Une attente à émouvoir un James Dewey Watson, plusieurs publications en guise de démonstration de la faisabilité d’un tel séquençage, des appels de fonds ayant abouti à l’intégration d’Illumina au niveau du capital d’Oxford Nanopore (investissement en deux fois d’abord de 28 millions $ puis de 41 millions) ont maintenu en haleine les scientifiques avides de séquençage 3ème génération.

Oxford Nanopore est l’un des seuls acteurs européens, dans le monde du séquençage haut-débit où l’hégémonie californienne est écrasante… Alors que les Californiens (PacBio, Life, Illumina) communiquent à grand renfort d’annonces choc, Oxford Nanopore garde une part de mystère (aucune spécification réellement disponible à ce jour), nourrissant notre curiosité avec quelques publications scientifiques et quelques animations dont certaines vous sont présentées ci-dessous.

http://vimeo.com/18630569

Cette première animation reprend les différentes modalités de séquençage

http://vimeo.com/20289048

Avec la vidéo ci-dessus et celle ci-après, Oxford Nanopore réinvente le magnétoscope VHS à visée séquençage haut-débit…

http://vimeo.com/19288315

Finalement, le message à peine subliminal de ce court article : Oxford Nanopore est une société à surveiller de près… de plus en plus près.

Note : si les liens vers les vidéos ne fonctionnent pas essayer toujours en suivant celui-ci…

Dernier né de la gamme des séquenceurs de paillasse, le « Ion Proton Sequencer » (149.000 $) est le premier de sa catégorie à permettre le séquençage en quelques heures du génome humain et à faible coût (1.000 $). A l’instar du PGM Ion Torrent, cette nouvelle plateforme est basée sur la technologie des semi-conducteurs (et la détection de la libération d’ions H+ suite à la polymérisation de dNTP).

La puce « Ion Proton ™ I »,disponible mi-2012, aura une capacité de séquençage 1000 fois supérieure au premier format de puce 314 du PGM Ion torrent soit 10 Gb (davantage orientée pour le séquençage d’exome humain). Le second format (puce « Ion Proton ™ II ») , disponible environ six mois plus tard aura une capacité de 100 Gb (Séquençage Génome humain).

Compte tenu de l’apparente similarité entre les deux plateformes de chez Life technologies, l’évolution réside essentiellement dans l’architecture de la puce avec une augmentation du nombre de puits ( 165 millions de puits pour la puce « Ion Proton ™ I » et 660 millions pour la puce « Ion Proton ™ II » soit respectivement 100 et 1000 fois plus que la puce 314 du PGM ), l’une des bases de la capacité de séquençage (en complément de la longueur des reads générés).

L’exome humain, l’ensemble des exons ou encore l’ensemble de ce qui, encodé sous forme d’ADN, peut être traduit en protéines représente environ 1,2% genome humain, 50 Mb et inclus 85 % des mutations référencées.

L’exome humain, l’ensemble des exons ou encore l’ensemble de ce qui, encodé sous forme d’ADN, peut être traduit en protéines représente environ 1,2% genome humain, 50 Mb et inclus 85 % des mutations référencées.

Emilie Lalonde et al., montre l’efficacité du séquençage d’exomes dans un article paru dans Human Mutation de 2010. La démonstration est faite au niveau de la découverte rapide des mutations associées au syndrome de Fowler, impliqué dans la prolifération anarchique des vaisseaux du cerveau qui empêche son développement. Etudiant les exons de deux patients sans lien de parenté cette équipe de Montréal a démontré l’efficacité de la capture d’exons (SureSelect, Agilent) suivi d’un séquençage haut-débit sur plateforme Illumina GAIIx (en moyenne pour les 2 expériences ont été générés 70 millions reads de 76 pb, environ 5 Gbases de séquences brutes).

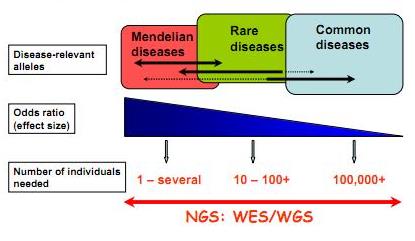

Techniquement le séquençage d’exons est relativement simple : il implique une capture par hybridation spécifique (NimbleGen, SureSelect de Agilent sont les plus employés), une purification de ces exons ou parties d’exons capturés et le séquençage haut-débit de ceux-ci… L’article de Majewski et al., disponible ici (J. Med. Genet. 2011) cerne avec brio le formidable potentiel de ces nouvelles études, avec son « qu’est ce que le séquençage d’exons peut faire pour vous ? ». Il est assez aisé de comprendre que le séquençage des régions codantes est plus accessible au niveau budget et souvent suffisant pour répondre à beaucoup de questions de cliniciens travaillant à la recherche des causalités de maladies rares. Le schéma ci-dessous, tiré de Leslie G Biesecker, Nature Genetics 42, 13–14 (2010), synthétise la procédure permettant d’aboutir rapidement à la notion de « gènes candidats » (ou plutôt de mutations causales). Les mutations témoins sont accessibles sur les bases de données mondiales dbSNP ou bien encore par l’intermédiaire du projet 1000 Génomes… dont nous avons parlé dans de précédents articles.

L’article montre à quel point l’investigation visant à la découverte des causalités d’une maladie rare, par exemple, a été totalement bouleversée. Ces technologies couplant capture d’exons et séquençage des régions codantes capturées ont d’ores et déjà montré la preuve de leur efficacité. L’article nous rappelle que le génome humain réalisé en 2001 a coûté plus de 2,7 milliards USD, qu’en 2008 un séquençage humain complet coûtait 1,5 millions de USD et qu’aujourd’hui ce même séquençage approche les 10 000 USD…

Feuille de route pour l'utilisation du séquençage haut-débit appliqué à l'identification des variations génomiques à l'origine de maladies "génétiques"

Ainsi que le montre Majewski et al. par le schéma ci-dessus plus la maladie que l’on cherche à élucider (si l’on peut s’exprimer ainsi) est la résultante d’une mutation qui a un effet fort, moins la cohorte à séquencer sera importante. En d’autres termes, pour ce qui concerne les maladies multi-factorielles (Alzheimer par exemple), le nombre d’individus dont les exons sont à séquencer sont importants… pour ce type de problématique les GWAS (Genome Wide Association Studies) par l’intermédiaire de scan de régions polymorphes anonymes sur la base de supports tels que les puces Illumina (puces permettant de scanner jusqu’à 4,3 millions de SNPs humains) restent compétitives et d’une puissance comparable. Dans le cas des maladies complexes d’autres stratégies sont développées telles qu’un premier crible sur une grande quantité de cas/témoins sur la base de puce haute densité de SNPs et un focus-séquencing des régions génomiques montrant une association potentielle avec le phénotype étudié…

Le séquençage haut-débit devenant de plus en plus accessible financièrement et par les méthodologies (pipeline d’analyses) de plus en plus disponibles permet d’envisager de nouvelles approches dans la découverte de cibles thérapeutiques potentielles. Ceci étant, l’accessibilité à des quantités de génomes de plus en plus disponibles (sans réel contrôle des organismes d’état) n’est pas sans soulever des problèmes d’éthique profonds et quelque peu négligé dans le débat scientifique actuel.

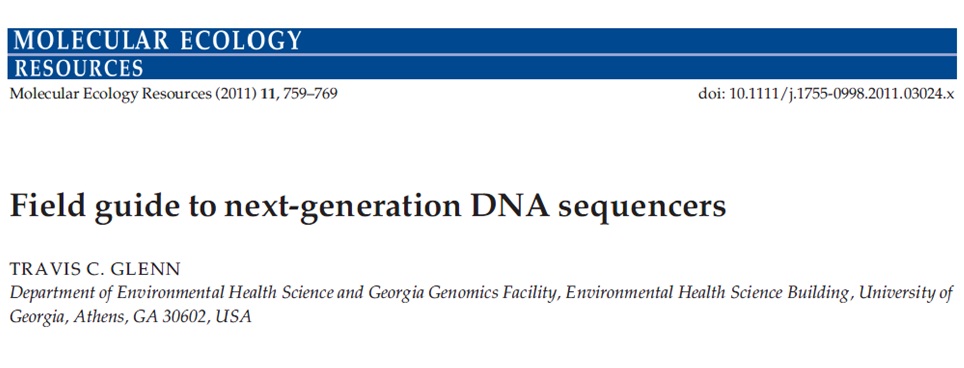

Pour continuer dans notre tour d’horizon technologique des différentes méthodes de séquençage voici une revue faisant le point sur les différentes plateformes (plutôt dans le gros calibre). Certes, cette revue date de presque deux ans et écarte d’emblée les séquenceurs de paillasse, néanmoins les schémas, plutôt bien faits, permettent d’entrevoir les subtilités des diverses modalités de séquençage. En outre, cette revue propose une base comparative argumentée permettant de se faire une opinion éclairée des capacités des diverses plateformes (comme d’habitude vous avez accès à la publication en cliquant sur l’image ci-dessous)… bonne lecture.

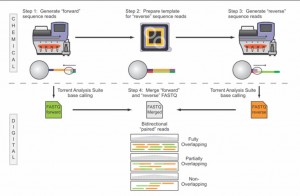

Voici pour continuer sur les développements qui ont lieu sur la plateforme de séquençage de Ion Torrent, le PGM, une nouvelle note d’application qui ouvre de nouvelles perspectives dans le champ du séquençage haut-débit : le fait de pouvoir très bientôt séquencer des fragments de 400 bases dans les deux sens. Ainsi, le PGM de Ion Torrent sera la seule technologie capable de fournir sur des reads plutôt longs un séquençage paired end (sachant que le kit et protocole associé « mate paire » est d’ores et déjà disponible). Evidemment, ce développement vient contrecarrer une critique qui peut être portée sur cette plateforme de séquençage : sa « justesse » de séquençage sur séquences brutes générées à Q20 (une erreur générée pour 100 bases séquencées, qui dépasse en général Q50 sur séquence consensus, soit 1 erreur pour 100 000 bases), comparable cependant au taux d’erreur d’un 454 de chez Roche.

La note d’application, plutôt enthousiasmante, est très didactique (notamment pour évoquer les subtilités des différences entre séquençage piared end et mate pair) laisse entrevoir de grandes perspectives… seul bémol, le kit paired end ne serait disponible que dans le premier trimestre de 2012.

Le terme « Nouvelle génération de séquençage à haut-débit » ( ou « Next generation sequencing » ) regroupe l’ensemble des technologies ou plateformes de séquençage développées depuis 2005 par quelques sociétés de biotechnologies.

L’objectif de cet article est de proposer de manière synthétique, un tour d’horizon des différents principes et caractéristiques de ces nouveaux outils et ainsi fournir quelques orientations et solutions techniques en réponses à des questions biologiques.

La position actuelle dans laquelle nous nous trouvons, entre la commercialisation de certains séquenceurs et ceux en cours de développement, est caractéristique d’une période charnière dissociant les technologies à haut débit dites de 2ème génération qui requièrent une étape d’amplification des molécules d’ADN en amont du décodage, de celles dites de 3ème génération permettant le décryptage direct d’une seule molécule d’ADN. Cette dernière catégorie fera à elle seule l’objet d’un prochain article.

Le marché des séquenceurs de 2éme génération est couvert par 3 grand groupes que sont Roche, Illumina et Life Technologies ayant respectivement proposés de manière successive, leur première plateforme à savoir le 454, le Genome Analyser et enfin le SOLiD. Depuis, le marché s’est étoffé proposant un panel de technologies au principe et caractéristiques propres telles qu’elles sont mentionnées ci dessous. A noter que parmi ce panel, le PGM, Ion torrent est le seul a connaitre une évolution constante en terme de capacités de séquençage (10Mb – reads de 100b – Juin 2011 / 100Mb – reads de 100b – Sept 2011 / 100Mb – reads 200b – Nov 2011 / 1Gb – Jan 2012 )

Chaque plateforme possède ses avantages et inconvénients et nombreuses sont celles configurées pour répondre à de nombreuses approches « omics », dans certaines limites. Il s’agira de faire un choix technologique selon les champs d’applications souhaités.

De manière générale, le type d’organisme étudié prédéterminera la technologie à employer. La notion de profondeur est récurrente à chaque application et dans l’objectif d’un reséquençage, le choix de la plateforme peut être identifié, de manière simplifiée, sur la base d’un calcul rapide ( P = N / L où P: Profondeur, N: Nombre des nucléotides totaux des reads, L: Taille du génome étudié).

Concernant les séquenceurs de 2ème génération, le séquençage de novo est une application mentionnée chez de nombreux fournisseurs (cf le tableau ci-dessous). Toutefois, l’association de deux technologies générant à la fois des reads longs (type 454, Roche) et une profondeur conséquente (type GAIIx, Illumina) palliant aux problèmes liés aux homopolymères et erreurs de séquençage, est préconisée (Au cours de l’article à venir sur les séquenceurs de 3ème génération, nous aborderons les plateformes davantage configurées pour cette application).

Ce paramètre de profondeur sera également à prendre en considération pour les champs d’applications incluant la notion d’analyse quantitative (RNAseq, ChIPseq, …). Si la profondeur permet d’atténuer les erreurs de séquençage, il reste néanmoins préférable de s’orienter vers des technologies à Q30 minimum (1 erreur sur 1000) pour la détection de SNPs.

Selon les technologies évoquées ci-dessus, les caractéristiques et champs d’applications ont évolués. Aussi, je vous propose de retrouver l’ensemble de ces informations actualisées en cliquant sur ce lien.

L’ensemble des informations sont détaillées dans l’article mentionné ci-dessous:

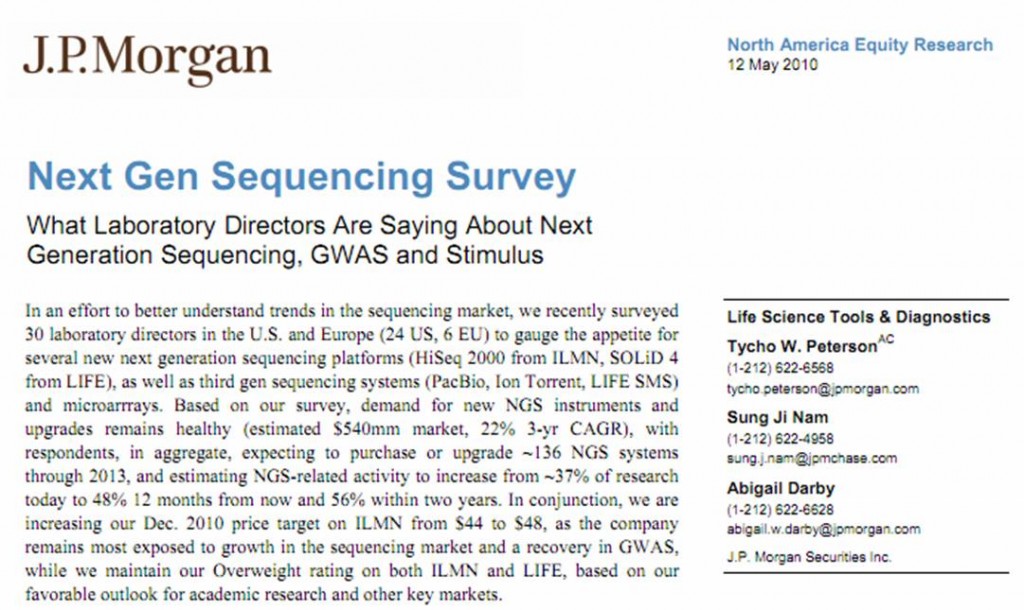

Voici un excellent rapport (toujours d’actualité) réalisé par J.P. Morgan, une holding leader dans la banque d’investissement. Ce rapport traite de la part prise par les différentes applications NGS, il compare les différents séquenceurs haut-débit… cette enquête a été réalisée en interrogeant 30 laboratoires (dont 24 Américains), 50 % de ces laboratoires sont publics. ..

Ce rapport permet d’entrevoir ce que seront les prochaines demandes de financements des laboratoires d’une part, d’autre part, il permet d’entrevoir les possibilités offertes par ce type de technologies encore très consommatrices de fonds et de temps humain. Les technologies disponibles sont de plus en plus diverses… Pour beaucoup de laboratoires il s’agira d’effectuer le choix technologique le plus adapté à leur champ d’application. Avec un petit étonnement, on apprend que l’application la plus développée au sein des laboratoires, concerne l’expression de gènes (mRNA expression profiling)… le séquençage de novo n’arrivant qu’en 7ème place des applications les plus développées.

(le rapport est disponible en cliquant sur l’image ci-dessus)

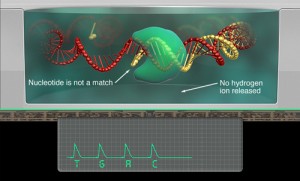

Pour donner suite aux demandes assez nombreuses de détails concernant le principe de fonctionnement du séquençage multiparallélisé PGM (Ion Torrent / Life Technologies).

Sur le lien suivant vous trouverez une vidéo de principe de la technologie Ion Torrent (Life). En supplément, la publication de juillet 2011 de Rothberg et al. dans Nature (pour quelques informations supplémentaires). Il est à noter pour les connaisseurs que Jonathan Rothberg est l’un des fondateurs de la la société 454 Life Sciences (ayant donné naissance au séquenceur haut-débit le plus utilisé dans un passé proche, utilisant le principe du pyroséquençage), technologie vendue à Roche et le créateur de la société Ion Torrent avant que celle-ci ne soit rachetée 350 millions de dollars par Life Technologies.

pour but, à travers la mutualisation de ressources informatiques des acteurs du projet, de proposer l’utilisation d’applications bioinformatiques déployées sur grille de calcul au plus grand nombre.

pour but, à travers la mutualisation de ressources informatiques des acteurs du projet, de proposer l’utilisation d’applications bioinformatiques déployées sur grille de calcul au plus grand nombre.

L’étude de Fan et al publiée en 2008 et que nous avions évoquée au travers d’un article précédent, décrivait l’étude de faisabilité d’un diagnostic prénatal non invasif à partir de cellules d’origine fœtale provenant d’une simple prise de sang maternel.

L’étude de Fan et al publiée en 2008 et que nous avions évoquée au travers d’un article précédent, décrivait l’étude de faisabilité d’un diagnostic prénatal non invasif à partir de cellules d’origine fœtale provenant d’une simple prise de sang maternel.

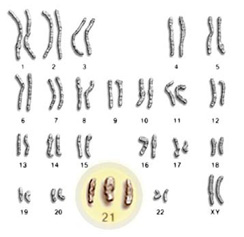

Ces travaux ont fait l’objet de controverses et même si la détection de la trisomie 21 est rendue possible , cela ne l’ était déjà plus pour les trisomies 18 ou 13, par exemple. En cause, la méthode d’analyse employée : l’ensemble des séquences sont alignées par rapport à un génome de référence et l’aneuploïdie foetale est détectée par une surreprésentation du chromosome correspondant, au sein du jeu de données. La sensibilité et l’efficacité de la méthode sont ici directement liées à la profondeur de séquençage. Cette approche ne permet pas de prendre en compte les biais aléatoires ou systématiques liés aux techniques de séquençage, facteurs primordiaux pour cette application.

Dernièrement, les entreprises Sequenom et Verinata Health ont publié des travaux (Sehnert et al.,2011) portant sur le dépistage d’aneuploïdies via le séquençage à haut débit, à partir de cellules d’origine fœtale issues d’une prise de sang maternel : 100% des cas de trisomies 21, 18 et autres anomalies ont été décelés ( soit 27 caryotypes anormaux parmi 48 patients ).

Cette efficacité repose sur une optimisation de l’analyse bioinformatique et notamment sur une considération pour les variations intra et inter-run qui se situent bien souvent à la frontière avec les faibles modifications de la distribution des séquences entre un cas sain et un cas d’aneuploïdie. L’algorithme développé utilise des valeurs de chromosome normalisées établies sur la base d’un ensemble de données de séquençages provenant d’échantillons parmi lesquels certains sont connus comme ayant un caryotype anormal.

En podcast de « clinical chemistry », le Dr. Richard P. Rava, co-auteur de l’article proposé précédemment, revient sur des points de détails et explications concernant le développement de l’algorithme optimisé pour les détections d’aneuploïdies.

Qui sommes nous?

Christophe Audebert [@]

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

Renaud Blervaque [@]

Biologiste moléculaire, chargé d'études génomiques.

Biologiste moléculaire, chargé d'études génomiques.

Gaël Even [@]

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Catégories

- Analyse de données (14)

- Automatisation (5)

- Bioinformatique (27)

- Biologie (56)

- biologie transverse (35)

- Biotechnologie (30)

- Chronique littéraire (8)

- Comparatif (6)

- Diagnostic (8)

- Economie (17)

- Epidemiologie (2)

- Evénement (17)

- Formation (3)

- Gestion de projet (5)

- Grille de calcul (1)

- Intégration (5)

- Logiciels (8)

- Médecine (14)

- politique de la recherche (17)

- Recherche (21)

- Séquençage (70)

- Séquenceur (39)

- Uncategorized (25)

- Workflow (4)

Accès rapide aux articles

- Covid-19 : zoom sur les vaccins

- Comment l’ADN pourrait être le stockage de données du futur

- COVID-19 : la data visualisation au service de la science

- COVID-19 : des explications et un point d’étape au 20 février 2020

- Pour mettre du vin dans son eau

- Des petits trous, toujours des petits trous…

- Qui serait candidat ?

- Un robot pour analyser vos données…

- Monde de dingue(s)

- L’art et la manière de développer une qPCR

- Un MOOC Coursera sur le WGS bactérien

- Chercheurs & enseignants-chercheurs, l’art du multitâche.

- Un jeu de données métagénomiques

- Facteur d’impact

- Microbiote & smart city : juxtaposition de tendances

Accès mensuels

- février 2021 (1)

- décembre 2020 (1)

- février 2020 (2)

- septembre 2019 (1)

- avril 2018 (2)

- décembre 2017 (1)

- novembre 2017 (2)

- juillet 2017 (2)

- juin 2017 (5)

- mai 2017 (4)

- avril 2017 (3)

- mars 2017 (1)

- janvier 2017 (2)

- décembre 2016 (3)

- novembre 2016 (4)

- octobre 2016 (2)

- septembre 2016 (2)

- août 2016 (3)

- juillet 2016 (2)

- juin 2016 (4)

- mai 2016 (3)

- mars 2016 (1)

- novembre 2015 (2)

- avril 2015 (1)

- novembre 2014 (1)

- septembre 2014 (1)

- juillet 2014 (1)

- juin 2014 (1)

- mai 2014 (1)

- avril 2014 (1)

- mars 2014 (1)

- février 2014 (3)

- janvier 2014 (1)

- décembre 2013 (5)

- novembre 2013 (2)

- octobre 2013 (2)

- septembre 2013 (1)

- juillet 2013 (2)

- juin 2013 (2)

- mai 2013 (4)

- avril 2013 (2)

- mars 2013 (1)

- février 2013 (3)

- janvier 2013 (2)

- décembre 2012 (2)

- novembre 2012 (2)

- octobre 2012 (2)

- septembre 2012 (2)

- août 2012 (1)

- juillet 2012 (3)

- juin 2012 (5)

- mai 2012 (5)

- avril 2012 (6)

- mars 2012 (6)

- février 2012 (8)

- janvier 2012 (6)

- décembre 2011 (5)

- novembre 2011 (6)

- octobre 2011 (6)

- septembre 2011 (7)

- août 2011 (5)

- juillet 2011 (8)

Pages