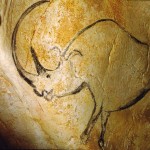

La paléogénétique, la science qui permet de remonter le temps, a trouvé sous la forme de séquenceurs haut-débit, sa DeLorean… en route vers l’Ardèche, dans l’antre de la grotte Chauvet. La grotte Chauvet, inventée en 1994, comporte 420 représentations d’animaux d’une incroyable diversité technique. C’est en partie les déductions menées à partir de l’étude de cette grotte, que l’on a remis en cause l’idée d’un art (pariétal) évoluant lentement et de manière linéaire. L’art peut être vu comme une suite d’apogées et de déclins, un concept s’opposant à l’idée d’un art co-évoluant avec le progrès technique et la diffusion du savoir-faire et des connaissances.

La paléogénétique, la science qui permet de remonter le temps, a trouvé sous la forme de séquenceurs haut-débit, sa DeLorean… en route vers l’Ardèche, dans l’antre de la grotte Chauvet. La grotte Chauvet, inventée en 1994, comporte 420 représentations d’animaux d’une incroyable diversité technique. C’est en partie les déductions menées à partir de l’étude de cette grotte, que l’on a remis en cause l’idée d’un art (pariétal) évoluant lentement et de manière linéaire. L’art peut être vu comme une suite d’apogées et de déclins, un concept s’opposant à l’idée d’un art co-évoluant avec le progrès technique et la diffusion du savoir-faire et des connaissances.

Les œuvres de la grotte Chauvet démontrent q’au début du Paléolithique supérieur, des artistes étaient capables d’une abstraction intellectuelle (une certaine conceptualisation) pour préparer la paroi calcaire et penser le dessin, tout en maitrisant des techniques complexes (estompes,perspective…). L’observation des traces humaines, à la grotte Chauvet comme dans beaucoup de lieux montrant une activité préhistorique, est accompagnée d’analyses de mesures physico-chimiques. Ainsi, avec d’autres méthodes, la datation radiométrique au carbone 14 a été employée pour permettre une estimation de l’âge absolu d’un échantillon organique… la grotte ardéchoise aurait hébergé les artistes du paléolithique autour de 31 000 ans avant notre ère. Assez nouvellement les techniques de génomique trouvent un champ d’application au niveau de la l’histoire des populations et viennent compléter les autres types d’observations pour nous reconstituer ce que le temps a détruit ou transformé.

Le carbone 14 génomique pourrait (en quelque sorte) être constitué par l’ADN mitochondrial. L’ADNmt est ici pris comme témoin (plus ou moins stable) des espèces disparues et sert de base aux études phylogénétiques, loin de Jurassic Park mais néanmoins enthousiasmant… mais est ce vraiment aussi simple ?

En effet, de par sa stabilité présumée au fil de l’évolution, l’ADNmt est devenu une cible de choix pour l’étude de la diversité des populations : a priori, les gènes déterminant la fonction respiratoire de la cellule sont moins la cible d’adaptations fréquentes à des changements environnementaux que, par exemple, ceux de l’immunité, situés, eux, dans l’ADN nucléaire. Je vous conseille vivement, à ce sujet, la lecture de l’article suivant, remettant en cause ce paradigme (cf. CNRS – le journal – mars 2007).

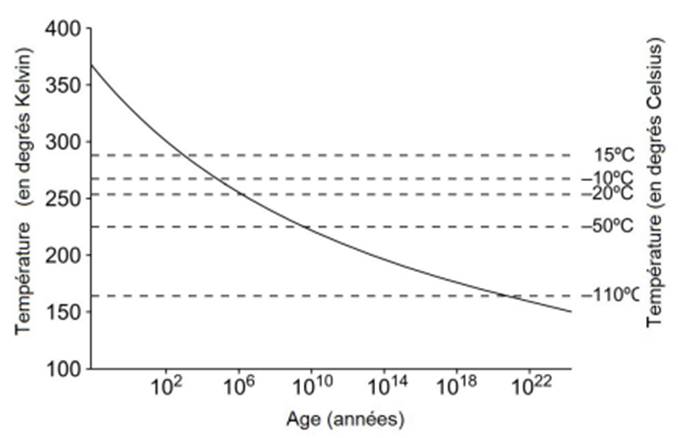

Mais revenons à l’utilisation du séquençage haut-débit pour remonter le temps. Le temps a fait son œuvre quant à la première étape de la préparation de la librairie, la fragmentation. « Dans les régions tempérées, ce sont les échantillons provenant de grottes qui sont souvent les mieux conservés (cf. figure ci-dessous). Dans les grottes, la température reste très stable, autour d’une valeur comprise entre 10 et 15°C. De plus, les grottes se creusent dans des environnements karstiques, riches en calcium et de pH neutre ou basique, qui sont des conditions propices à la conservation de la matière organique et de l’ADN en particulier. » – Extrait de la thèse de Céline Bon (CEA – page 50 – 25 juin 2012).

Temps de survie d’un ADN de taille supérieure à 100 pb

Le séquençage haut-débit devient réellement d’un grand intérêt dans l’étude du métagénome des coprolithes et des ossements retrouvés dans ces grottes. La capture d’écran ci-dessous vous mènera en cliquant dessus, sur une partie du site du CEA où une vidéo simple et efficace, reprend les propos de Jean-Marc Elalouf. Ce dernier aborde l’exceptionnelle conservation des ossements qui a permis aux biologistes d’en analyser l’ADN et ainsi de faire de nouvelles avancées sur l’étude des espèces éteintes et la phylogénie des ours des cavernes.

Pour rien vous cacher, il s’agit ici d’un article avec un petit goût d’auto-promotion. En effet, les 3 membres de Biorigami participent aussi activement à une plateforme d’expertise nouvellement créée, cette entité a pour ambition la réalisation de quelques prestations, principalement en génomique haut-débit, mais aussi la participation à des projets nécessitant conseils, expertises et analyses… pour répondre au mieux aux questions biologiques posées. Enchaînons en citant les pages actualités du site internet de Gènes Diffusion : « cette alliance entre les deux structures (ndlr : Gènes Diffusion et l’Institut Pasteur de Lille) a pris le nom de PEGASE (Plateforme d’Expertises Génomiques Appliquées aux Sciences Expérimentales). Elle permet de mutualiser les moyens de la branche R&D génomique de Gènes Diffusion et du laboratoire TAG (Transcriptomic analysis and Applied Genomics) de l’Institut Pasteur de Lille.

La création de cette unité devrait permettre le développement de nouvelles activités, collaborations scientifiques et prestations, dès les prochains mois

Issue de la collaboration entre Gènes Diffusion et l’Institut Pasteur de Lille, PEGASE (Plateforme d’Expertises Génomiques Appliquées aux Sciences Expérimentales) vient de lancer son site web. Cette présence sur le web permettra à la nouvelle structure de faire l’interface avec les différents acteurs de la génomique.

Par ailleurs, le site permettra également de faire partager à la communauté scientifique les différentes expertises en biologie moléculaire et bio-informatique issues des travaux de recherche de l’unité. »

Vous pourrez obtenir plus de précision concernant cette nouvelle plateforme en suivant le lien suivant : www.pegase-biosciences.com.

Pour les plus joueurs d’entre vous, un concours est lancé pour fêter cette naissance, le projet exécutable sur puce 318 de Ion Torrent, sera réalisé par nos soins, gratuitement… pour plus de précisions, nous vous invitons à suivre le lien suivant : concours PEGASE.

Il est douloureusement fatigant de se rendre compte de l’absence de mémoire Humaine! Cette amnésie collective provoque les mêmes écueils, les mêmes cercueils. « L’Histoire est un éternel recommencement » cette sentence attribuée à Thucydide a beau être un cliché des sujets de philosophie, une partie de la Hongrie a voté pour l’extrême droite (troisième force politique du pays, troisième force politique de notre pays aussi, à en croire les résultats du premier tour de l’élection présidentielle) -cette même extrême droite hongroise se sert de test génétique humain en guise de néo-certificat d’aryanité. C’est ce que relate l’article de Charlotte Chabas du Monde (15 juin 2012) – à lire le test de « pureté génétique » qui choque la Hongrie. Des sociétés privées surfent sur la mode du test génétique, devenu désormais largement accessible pour qui veut (peut) débourser quelques centaines d’euros ou de dollars pour connaître ses origines ethniques (test de 23andme) pour le moins pire ou pour s’assurer, comme c’est le cas ici, de sa non appartenance à un groupe ethnique rejeté par une politique clairement xénophobe et antisémite. Ce certificat hongrois qui émeut une majorité de la classe politique de Budapest est exploité à des fins nauséabondes par sa franche la plus extrême. Un test dont le résultat annonce « Aucune trace génétique d’ancêtres juifs ou roms » peut faire frémir n’importe quel démocrate.

L’Histoire se répète donc, et au gré de l’avancée des connaissances et des technologies, des hommes éditent des certificats d’aryanités phylogénétiques ou encore (à l’inverse) marquent d’une étoile jaune génomique des personnes pour lesquels l’Humain n’est que le fruit de son hérédité biologique. La science raciste qui a justifié par le passé la colonisation, les pogroms, refait surface (avait elle seulement disparu) et on ne peut s’empêcher, en tant que scientifique biologiste, d’exhumer quelques tristes mots de James Watson (co-élaborateur du modèle en double hélice de l’ADN). Le scientifique alors âgé de 79 ans a déclaré dans les colonnes du Sunday Times qu’il était «fondamentalement triste au sujet du devenir de l’Afrique» parce «toute nos politiques sociales sont fondées sur le fait que leur intelligence (celles des Africains, ndlr) est identique aux nôtres (occidentaux, ndlr) alors que tous les tests ne le disent pas vraiment». La science et l’accès à la connaissance n’éloigne pas nécessairement les idées les plus abjectes, à chaque humain sa morale, à chaque scientifique son éthique… mais les partisans de la science avec conscience, celle censée élevée l’âme ne peuvent que s’indigner.

D’un 23andMe, présentant de manière positive l’accès démocratisé à la connaissance de ses origines par le biais d’études GWS (Genome Wide Scan), à un prestataire hongrois cynique s’abritant derrière des notions d’éthique pour diffuser des résultats de tests génétiques de « pureté raciale », l’accès à ce type d’informations peut être sujet à interrogations quant à leurs utilisations (personnelle ou politique). La diffusion de tels tests ouvre une boîte de Pandore; ces tests génétiques (interdits sur notre territoire national) offrent une arme aux pires propagandistes et une information sujette à interprétation et pouvant être manipulée pour le pire rarement pour le meilleur… l’Histoire est un éternel recommencement.

La paléontologie, la science des fossiles et des traces de vie du passé, use de méthodes de biologie moléculaire de pointe qui pallient les effets du temps qui passe…

Afin d’introduire ce premier article traitant de paléogénomique, les moyens de la biologie moléculaire au service de la paléontologie, une vidéo amuse-bouche (Auteur(s) : Eva-Maria Geigl, Réalisation : Samia Serri, Production : Université Paris Diderot, Durée : 17 minutes 40 secondes) est disponible en usant du fameux clic gauche sur la capture d’image ci-dessous. Cette vidéo vaut surtout pour l’accent mis sur les précautions indispensables pour l’étude d’un échantillon précieux fossilisé… et dont l’ADN, peu abondant, peut être fragmenté. En outre, des mesures simples mais draconiennes permettent de limiter les sources de contaminations, quand l’ADN moderne peut polluer l’ADN fossile. Le port de sur-chausses, de masque et les changements de blouses, le non croisement des échantillons avant et après amplification sont autant de précautions mises en avant dans cette vidéo… une occasion de visiter virtuellement les laboratoire de l’Institut Jacques Monod.

L’une des problématiques liées à l’étude de l’ADN « fossile » réside dans sa faible quantité disponible. Plusieurs méthodes de biologie moléculaire ont été envisagées pour amplifier ce matériel génétique afin d’en permettre l’expertise. Une publication dans BMC Genomics de 2006, Assessment of whole genome amplification-induced bias throughhigh-throughput, massively parallel whole genome sequencing, relate la comparaison de 3 méthodes d’amplifications pan-génomiques (méthodes WGA pour Wide Genome Amplification) d’ADN qui pourra devenir ensuite la matrice suffisante d’un séquençage haut-débit.

– la PEP-PCR (Primer Extension Preamplification-PCR) : cette technique fait intervenir des amorces aléatoires aux conditions d’appariement à basse température (low melting temperature) qui initieront la PCR

référence : Zhang, L. et al. (1992) Whole genome amplification from a single cell: Implications for genetic analysis. Proc. Natl. Acad. Sci. USA 89, 5847

– la DOP-PCR (Degenerate Oligonucleotide Primed-PCR) : cette technique, quant à elle, fait intervenir des amorces semi-dégénérées (de type : CGACTCGAGNNNNNNATGTGG) qui ont une température d’hybridation supérieure à celles utilisées dans la PEP-PCR

référence : Telenius, H. et al. (1992) Degenerate oligonucleotide-primed PCR: general amplification of target DNA by a single degenerate primer. Genomics 13, 718.

L’utilisation d’une Taq PCR limite la taille des fragments néo-synthétisés qui ne dépassent guère 3 kb. En outre, ces deux techniques, à l’instar de ce qui peut être démontré dans la publication de BMC Genomics 2006 (mentionnée ci-dessus), induisent des erreurs de séquences accompagnées de nombreux biais d’amplification (certaines régions ne sont pas amplifiées au profit de régions qui deviennent, de fait, sur-représentées).

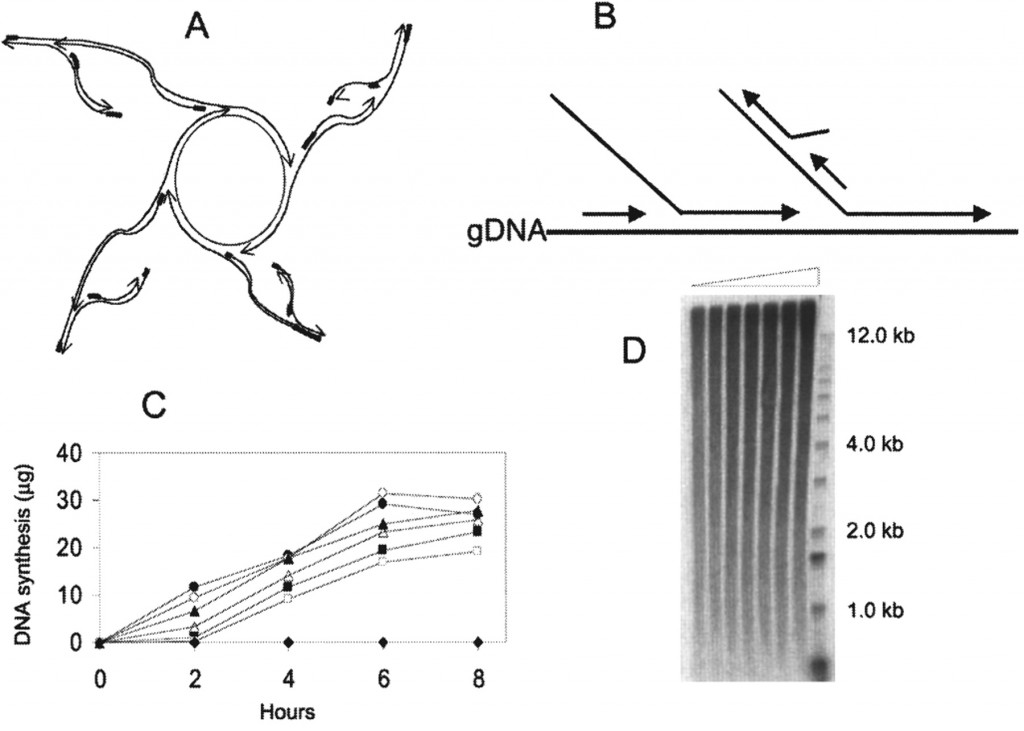

– la MDA (Multiple Displacement Amplification) : cette amplification iso-thermique fait intervenir des amorces aléatoires de type hexamères et une enzyme, la phi29. Le type d’amplification générée est schématisées sur la figure ci-dessous. L’enzyme surfe à partir du brin néo-synthétisé, déplace un brin complémentaire pour continuer sa synthèse. Ainsi, les brins générés par cette technique peuvent atteindre 100 kb. En outre, la phi29 possède une activité 3′ -> 5′ de relecture (proofreading) lui conférant un taux d’erreur 100 fois moindre que ceux constatés pour des Taq polymérases classiquement utilisées dans les techniques de PEP- ou DOP-PCR

source : Cold Spring Harb Protoc 2011.2011: pdb.prot5552 (la légende originale de la figure est disponible en cliquant sur celle-ci)

Ces techniques d’amplification pangénomique ont rendu possible l’étude d’ADN anciens et peu abondants et tout naturellement elles ont trouvé leur place dans la boîte à outils moléculaires des paléogénéticiens. Cependant, la révolution des séquençages haut-débit (dont nous avons abordé le sujet à plusieurs reprises) laisse entrevoir un nouveau champ des possibles pour l’étude des ADN fossiles. Au fond, des technologies telles que celle développée par Helicos Biosciences, trouvent ici un réel champ d’application à l’instar de ce que développe la publication True single-molecule DNA sequencing of a pleistocene horse bone de Genome Research, 2011- nulle nécessité d’amplifier la matrice de départ. Cette publication compare des technologies de séquençage de 2ème et 3ème générations (GaIIx et Helicos) appliquées au séquençage de l’ADN isolé à partir d’un os de cheval pleistocène conservé dans permafrost. Le séquençage « single molecule« , une chance pour la paléogénomique !

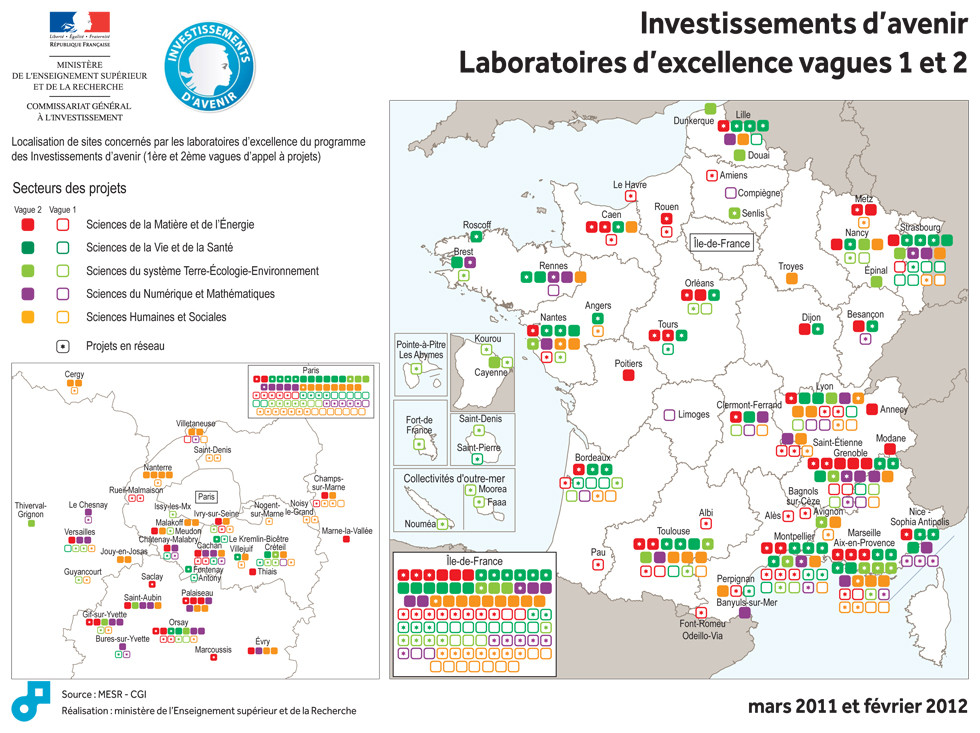

Laurent Wauquiez, ministre de l’Enseignement supérieur et de la Recherche, et Jean-Luc Tavernier, Commissaire général adjoint à l’Investissement, ont annoncé la liste des 71 lauréats de la deuxième vague de l’appel à projets « LABoratoires d’EXcellence« -fameux LABEX- doté d’une enveloppe de 1 milliard d’euros. La gestion du contenu de cette enveloppe a été confiée à l’Agence Nationale de la Recherche.

Laurent Wauquiez, ministre de l’Enseignement supérieur et de la Recherche, et Jean-Luc Tavernier, Commissaire général adjoint à l’Investissement, ont annoncé la liste des 71 lauréats de la deuxième vague de l’appel à projets « LABoratoires d’EXcellence« -fameux LABEX- doté d’une enveloppe de 1 milliard d’euros. La gestion du contenu de cette enveloppe a été confiée à l’Agence Nationale de la Recherche.

Voici un extrait du site : investissement-avenir.gouvernement.fr qui revient sur le bilan des dotations suite à cette deuxième vague du concours de l’excellence au service de la science… ou l’inverse… on ne sait plus trop :

« L’appel à projets a pour objectif d’attribuer aux laboratoires sélectionnés des moyens significatifs leur permettant d’accroître leur visibilité internationale, de faire jeu égal avec leurs homologues étrangers, d’attirer des chercheurs et des enseignants-chercheurs de renommée internationale et de construire une politique intégrée de recherche, de formation et de valorisation de très haut niveau.

195 projets ont été reçus pour cet appel et 71 ont été retenus (soit l’ensemble des projets classés A+ à A5 par un jury international, présidé par le Professeur Jean Claude Latombe, Professeur à l’université de Stanford).

Ces 71 laboratoires seront financés jusqu’en 2020 pour un montant de 534,5 M€, sachant que certains de ces laboratoires se trouveront financés dans le cadre des 8 Initiatives d’excellence désormais reconnues.

Les lauréats recevront dans les toutes prochaines semaines un acompte de 10% afin que les équipes sélectionnées puissent lancer leur projet dans les meilleurs délais.

Avec les lauréats de la première vague, ce sont donc 171 laboratoires d’excellence qui auront été sélectionnés pour un financement sur une période suffisamment longue pour leur permettre de déployer une stratégie scientifique de grande ampleur.

L’ensemble des domaines de recherche est représenté au terme de ces deux appels à projets : 14,5% en sciences du numérique et des mathématiques, 24% en sciences humaines et sociales, 20 % dans le domaine de la matière et de l’énergie, 14,6% dans le domaine des sciences de la terre et de l’environnement, 26,9% dans le secteur de la biologie-santé. »

Vous pourrez trouver le communiqué de presse comportant la liste des projets retenus accompagnée d’un court descriptif incluant les retombées économico-scientifico-sociales attendues (retour sur investissement) –> ici. Il vous suffit ou presque de regarder la carte présentée ci-dessus pour connaître les régions (ou villes universitaires) sur- ou sous-bénéficiants des investissements d’avenir… Lille devance légèrement Clermont-Ferrant et est supplantée par Strasbourg…

LABEX ou l’excellence… à tous les plats (nous avions abordé ce sujet précédemment). Une excellente lettre provenant de l’excellent blog d’Olivier Bouba-Olga, « un économiste qui suit et commente l’actualité » est disponible ici. Je vous invite chaleureusement à prendre connaissance de cette missive titrée : « l’excellence des Universités : oui, mais quelle excellence ?! ». Quelques « concepts » accompagnant la notion subjective d’excellence y sont passés en revue : de la notion de masse critique à la loi de Lotka.

Lotka a été le premier à réaliser, en 1926, une étude sur la distribution des auteurs scientifiques, arrivant à la conclusion que la relation auteurs-articles est inversement proportionnelle au carré d’articles publiés (une distribution hyperbolique)… cette constatation serait la résultante de ce que l’on nomme (en sociologie) « l’effet Saint Mathieu » qui peut être énoncé ainsi : le succès engendre encore plus de succès (ou la richesse réelle ou symbolique plus de richesse réelle ou symbolique)… Ainsi, ici transposé, le « concours » LABEX concentre des fonds très importants sur des têtes d’affiche… Quand l’état adosse sa politique d’investissements -d’avenir- sur la scientométrie, l’instrument de mesure fausse la mesure… en science on appelle cela l’effet de l’instrument…

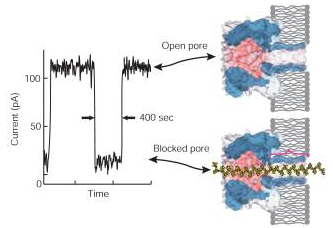

Le représentant européen des séquenceurs haut-débit de troisième génération, Oxford Nanopore va communiquer à l’AGBT… dans quelques jours. La société en profitera pour annoncer la commercialisation de ses premières machines permettant de séquencer en 24 heures un génome humain pour moins de 1000 $ (soit le même prix qu’un génome humain séquencé par un Ion Proton en 2 heures sur une plateforme de deuxième génération).

Le représentant européen des séquenceurs haut-débit de troisième génération, Oxford Nanopore va communiquer à l’AGBT… dans quelques jours. La société en profitera pour annoncer la commercialisation de ses premières machines permettant de séquencer en 24 heures un génome humain pour moins de 1000 $ (soit le même prix qu’un génome humain séquencé par un Ion Proton en 2 heures sur une plateforme de deuxième génération).

Oxford Nanopore souhaite commercialiser sa machine (en direct) avant la fin 2012. Un réelle course a lieu, puisqu’à cette échéance sera commercialisé le Ion Proton. Nous assisterons donc avant fin 2012 a un chevauchement technologique où 2ème et 3ème générations de séquenceurs risquent de se télescoper… les scientifiques en cours d’élaboration de dossiers de demandes de financements devront (vite) choisir leur camp… : partir sur une technologie qui a d’ores-et-déjà fait ses preuves (Ion Proton) donc de 2ème génération ou une technologie de 3ème génération totalement innovante… mais dont on ne possède pas de retour indépendant sur la qualité des données générées. La « guerre » technologique est lancée entre le transfuge de Solexa (technologie des séquenceurs Illumina), John Milton, le responsable scientifique d’Oxford Nanopore et la biotech’ rock-star Jonathan Rothberg, responsable scientifique de Ion Torrent chez Life Technologies.

La société suisse Roche tente de phagocyter la société californienne mastodonte, Illumina. Roche est prête à sortir un minimum de 5,7 milliards de USD de ses coffres suisses pour lancer une OPA inamicale – offre lancée le 24 janvier 2012 – sur la société leader de la biologie haut-débit. Illumina a été approchée par la société Roche afin de trouver un « terrain » d’entente, sans succès. Roche propose une offre valorisant l’action de 43 % par rapport à la valeur des cours des 3 derniers mois.

« Ensemble, les capacités de la division Diagnostics de Roche et d’Illumina, l’un des principaux fournisseurs de systèmes intégrés pour le séquençage de l’ADN, renforceront la position de Roche dans les secteurs Séquençage et Puces à ADN caractérisés par une demande croissante de solutions génétiques/génomiques », explique Roche, qui souligne qu’il « n’a pas ménagé ses efforts en vue de parvenir à une transaction négociée avec Illumina », mais que celle-ci « n’a pas voulu s’engager dans une discussion de fond ».

En temps de crise, les actionnaires ont bien souvent besoin de liquidité – valorisée qui plus est – il ne fait nul doute que cette OPA arrivera à ses fins… il ne s’agit pas nécessairement pour les scientifiques d’une excellente nouvelle, tant la concentration aux mains de peu se ressent par le moins de développement et des coûts croissants à supporter au niveau des laboratoires… Nous assistons à la création, au niveau des sociétés de biotechnologie, d’un monde bipolaire : Life vs Roche !

Le communiqué de presse de Roche concernant cette OPA est disponible ici.

De retour sur les chemins de traverses pour aborder un sujet qui est finalement assez peu développé dans le monde scientifique latin : la fraude (le puritanisme anglo-saxon oblige à s’intéresser de près à tout manquement à la morale…scientifique). Evidemment il semble utile de définir les contours de ce qui est considéré comme une fraude scientifique. Le chercheur dans le champ scientifique est en quête de vérité en vue de permettre une accumulation de savoir fiable disponible pour l’ensemble de la communauté humaine. Tout manquement (volontaire ?) à l’obligation de loyauté face à la vérité scientifique peut être considéré comme frauduleux. Ainsi, ces fraudes majeures peuvent être classées en trois grandes catégories :

De retour sur les chemins de traverses pour aborder un sujet qui est finalement assez peu développé dans le monde scientifique latin : la fraude (le puritanisme anglo-saxon oblige à s’intéresser de près à tout manquement à la morale…scientifique). Evidemment il semble utile de définir les contours de ce qui est considéré comme une fraude scientifique. Le chercheur dans le champ scientifique est en quête de vérité en vue de permettre une accumulation de savoir fiable disponible pour l’ensemble de la communauté humaine. Tout manquement (volontaire ?) à l’obligation de loyauté face à la vérité scientifique peut être considéré comme frauduleux. Ainsi, ces fraudes majeures peuvent être classées en trois grandes catégories :

– la fabrication de données

– la falsification de données

– le plagiat

Ces catégories constituent la zone « noire », avec une prévalence certainement faible, un grand nombre de faits peuvent quant à eux, être plus difficiles à classifier et caractériser, c’est ce que l’on classe dans la zone « grise ». A titre d’exemples, les publications « salami », les co-signatures honorifiques, les soumissions multiples semblent quant à eux des actes beaucoup plus fréquents.

Il existe assez peu d’études descriptives et analytiques sur la thématique de la fraude scientifique. Martinson et al. (Nature, 2005) est une des rares études interrogeant un nombre significatif de chercheurs (distinguant les jeunes chercheurs des chercheurs confirmés). Avec cette publication que nous vous laissons le soin de lire, se trouve légèrement étendue la notion de fraude scientifique. Ainsi tombe sous la qualification de comportement frauduleux, les faits et actes suivants :

– la falsification de données

– l’ignorance des principaux aspects liés à la vie humaine (définition un peu floue)

– la non divulgation des conséquences liées à la recherche privée en lien avec un produit commercial(isable)

– les éventuelles connivences entre étudiants, sujets de recherche ou client

– l’utilisation d’idées qui ne sont pas de soi sans en avoir obtenu la permission ou sans nommer la paternité de celles-ci

– l’utilisation non autorisée d’informations confidentielles dans le cadre de ses propres recherches

– omettre de présenter des données qui contredisent ses propres recherches antérieures

– contourner certains aspects mineurs des exigences liées à l’homme comme sujet d’étude

– la surabondance d’utilisation de données erronées ou d’interprétations douteuses de données

– la modification de la conception, de la méthodologie ou des résultats d’une étude en réponse à la pression provenant d’une source de financement

– éditer les mêmes données ou les mêmes résultats dans deux ou plusieurs publications

– la rétention d’informations (particulièrement concernant l’aspect méthodologique d’une publication)

– omettre les observations ou les points de données paraissant de prime abord fallacieux (cela simplifie la démonstration finalement)

– la tenue inadéquate des dossiers relatifs aux projets de recherche (le cahier de laboratoire comme « un excellent atout juridique pour prouver une antériorité voire être une très bonne base pour la rédaction d’un brevet »)

Avant Martinson, Larivée et Baruffaldi (1993) et Swazey (1993) ont décrit, étudié et calculé des prévalences de cas de fraudes scientifiques. Larivée après avoir étudié 1000 articles de cinq grands domaines scientifiques (sciences de la terre, sciences pures, sciences humaines,sciences de la vie et sciences de la santé) détecte 230 cas de fraudes (rien que ça).

Il est temps d’aborder brièvement les raisons pour lesquelles le cherche se corrompt en flirtant avec la fraude : pression, compétitivité, besoin de performance (finalement les mêmes raisons qui poussent un cycliste à prendre des substances améliorant ses performances).

Quelques articles font état de l’exception française concernant la fraude scientifique. Souvent, dans notre pays ce problème donne lieu à des bafouilles peu audibles, peu étayées… un exemple de cet état de fait peut être porté par le document sonore d’une intervention d’Alain Prochiantz au Collège de France (autant demander à un cyclisme de faire une conférence sur le dopage).

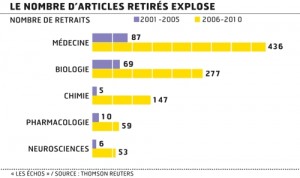

Les exemples de fraudes scientifiques sont malgré tout à la fois légions, les exemples de collusions aussi. Quelques articles aux graphes repris de multiples fois (l’un des plus utilisé est présenté ci-contre) tendent à démontrer que le nombre d’article retirés explose sans réellement chercher à comprendre si ceux-ci sont retirés du fait de l’efficacité de la censure des comités de lecture ou si les chercheurs fraudeurs amateurs sont de plus nombreux à éprouver le système…

Les études où les conclusions sont dictées par l’inclination d’un chercheur pour son financier sont très fréquentes dans la littérature et certainement sur-représentées sur internet (nous pouvons exhumer l’article de Nature de 1988, Human basophil degranulation triggered by very dilute antiserum against IgE (abusivement associée à « la mémoire de l’eau » cet article d’un chercheur financé par Boiron, crédite en partie le modèle de dilution pratiquée en homéopathie).

Les chartes d’éthique telles que celle de l’Institut Pasteur à Paris constituent un garde-fou nécessaire mais insuffisant. En effet, ce type de chartes sont incitatives rarement coercitives. Finalement, face à la possibilité de tricher avec la vérité, le chercheur est face à sa conscience.

La fraude scientifique peut avoir des conséquences directes, en effet, la réputation des chercheurs porteurs d’un projet est en lien direct pour les bailleurs de fonds (particulièrement pour ce qui concerne les fonds publics) avec la qualité de leur propre recherche. Le plus grave sont les conséquences de la fraude sur la science elle-même, l’exemple cité par Serge Larivée est relativement saisissant : « la fraude peut en outre affecter le travail d’autres chercheurs qui auraient construit tout un corpus de connaissances à partir de données frauduleuses. Le cas relativement récent de Gupta est à cet égard exemplaire. Avec 124 autres chercheurs, ce paléontologue de l’Université de Chandigarh, au Penjab, a publié de 1969 à 1988 près de 450 articles sur l’étude des fossiles de l’Himalaya, dont 300 sont soit truffés d’anomalies et d’invraisemblances, soit de pures fictions. Certains soutiennent que cette fraude porte peu à conséquence dans la mesure où la plupart des géologues spécialistes de l’Himalaya ne tenaient plus compte des publications de Gupta depuis belle lurette. Par contre, les chercheurs qui avaient intégré de bonne foi les «découvertes» de Gupta dans leur corpus de connaissances ont été lourdement escroqués puisqu’ils sont maintenant en possession de données inutilisables. » Bien évidemment, une autre conséquence de ce type de fraudes, trouvant échos à raison dans les médias, ont des conséquence sur la santé humaine. Imaginons (toute ressemblance avec un épisode faisant intervenir un médicament du laboratoire Servier est fortuite) que des scientifiques soient amenés à cautionner frauduleusement un médicament en masquant la toxicité d’une molécule… imaginons que des études sur l’incidence des ondes émanant de téléphones sur la santé humaine soient financées par un fabriquant de téléphones portables (à ce jour une dizaine d’études de ce type sont recensées)… le conflit d’intérêt étant bien entendu au cœur de nombreuses fraudes de grande ampleur.

Le scientifique face à ce type de choix : négocier sa carrière ou atteindre la vérité (ce pourquoi il fait ce métier) peut se corrompre en oubliant que l’on ne négocie pas avec la vérité qui a une exigence de sincérité. L’exigence prime sur l’excellence !

HEALTH MAP : WHO is watching you !

( -L’OMS vous regarde !-)

Encore une application liée à Google Map.

Grossièrement, à l’aide de :

contributions « volontaires » (par l’intermédiaire d’une application sur smart phone : Outbreak Near Me – « épidémie près de chez moi », cf. capture d’écran ci-contre) vous pouvez ainsi « dénoncer » votre voisin qui a la grippe (à vous la charge du diagnostic…), et le cas sera (peut-être) référencé, associé à une date et une géolocalisation puis reporté sur la planisphère) – simple efficace un tantinet intrusif.

en scrutant de manière automatisée à large échelle le contenu des réseaux sociaux, les flux de nouvelles locales, les dépêches, les flux d’informations informelles (SMS, Twitter…), et en appliquant une « analyse sémantique » automatisée du contenu. Cet outil est capable, en se référant à un dictionnaire des localités et des maladies, d’attribuer un cas relaté d’une maladie donnée à une géolocalisation que l’on souhaite la plus précise possible. Un outil basé sur le principe de détection sémantique contextuelle (cf. bibliographie en accès gratuit dans PubMed)

L’objectif ? Suivre en temps proche l’évolution d’une pandémie, observer avec un temps d’avance l’arrivée de la grippe saisonnière par exemple… avec plus de 2300 lieux, 1100 « maladies » dans le dictionnaire de référence… la vigie automatisée a du travail !

Le projet peut paraître séduisant. Il constitue un fantastique système de surveillance (un de plus, dirons les septiques) pour l’OMS. Même si l’information est bruitée (suite à un mauvais diagnostic, une information journalistique n’est pas une information scientifique) ou comporte des erreurs dans le couple d’attribution maladie / lieu, l’outil a misé sur la vélocité dans son aptitude à remonter de l’information que l’on souhaite la plus pertinente possible. Il est en perpétuelle amélioration. Sur Health Map, vous pouvez suivre jour après jour, tels des boutons de varicelles, des spots en relation avec votre agent infectieux favori s’illuminent sur la carte mondiale. Outre l’outil (une application de la fouille de texte, encore une) le site internet est très ergonomique et utile notamment pour sa section : « The Disease Daily« . Une critique possible : le continent africain fait les frais de son manque de couverture par les systèmes d’informations et de communication, la Chine semble, quant elle, assez épargnée par les pandémies… l’outil sémantique intègre t’il le cantonais ou le mandarin… ? A vous de juger.

Le projet peut paraître séduisant. Il constitue un fantastique système de surveillance (un de plus, dirons les septiques) pour l’OMS. Même si l’information est bruitée (suite à un mauvais diagnostic, une information journalistique n’est pas une information scientifique) ou comporte des erreurs dans le couple d’attribution maladie / lieu, l’outil a misé sur la vélocité dans son aptitude à remonter de l’information que l’on souhaite la plus pertinente possible. Il est en perpétuelle amélioration. Sur Health Map, vous pouvez suivre jour après jour, tels des boutons de varicelles, des spots en relation avec votre agent infectieux favori s’illuminent sur la carte mondiale. Outre l’outil (une application de la fouille de texte, encore une) le site internet est très ergonomique et utile notamment pour sa section : « The Disease Daily« . Une critique possible : le continent africain fait les frais de son manque de couverture par les systèmes d’informations et de communication, la Chine semble, quant elle, assez épargnée par les pandémies… l’outil sémantique intègre t’il le cantonais ou le mandarin… ? A vous de juger.

Partenaires, collaborateurs & supports du projet : GOOGLE.ORG, NATIONAL INSTITUTES OF HEALTH RESEARCH / NATIONAL LIBRARY OF MEDICINECENTERS FOR DISEASE CONTROL AND PREVENTION, CANADIAN INSTITUTES OF HEALTH RESEARCHINTER, NATIONAL SOCIETY FOR INFECTIOUS DISEASES / PROMEDHEALTH AND HUMAN SERVICES, FLU.GOV, INTERNATIONAL SOCIETY FOR DISEASE SURVEILLANCE, INTERNATIONAL SOCIETY FOR TRAVEL MEDICINEGEOSENTINE, NEW ENGLAND JOURNAL OF MEDICINE, WILDLIFE CONSERVATION SOCIETY

Le contenu scientifique a bien souvent besoin d’être traduit et la démarche du chercheur nécessite d’être expliquée (nous ne sommes pas très loin des notions d’éthique). La vulgarisation peut parfois être un outil permettant d’éveiller l’opinion qui, de ce fait peut s’en faire une, ou à rebrousse poil, elle peut être une méthode visant à la rassurer. Nous pouvons lire et relire les méthodes employées par Edward Bernays pour transformer le citoyen en consommateur.

Le contenu scientifique a bien souvent besoin d’être traduit et la démarche du chercheur nécessite d’être expliquée (nous ne sommes pas très loin des notions d’éthique). La vulgarisation peut parfois être un outil permettant d’éveiller l’opinion qui, de ce fait peut s’en faire une, ou à rebrousse poil, elle peut être une méthode visant à la rassurer. Nous pouvons lire et relire les méthodes employées par Edward Bernays pour transformer le citoyen en consommateur.

La biotechnologie alimente les peurs par ce qu’elle peut engendrer dans un laboratoire et qui échapperait au contrôle citoyen dès lors que l’invention devient produit, par exemple. Cet article est l’occasion d’écouter un exemple de vulgarisation scientifique : l’émission de Là-bas si j’y suis (excellente émission du service public, sur France Inter), du vendredi 15 décembre 2006, » Leçon de choses : Les OGM « .

Dans cette émission Christian Vélot explique avec un magnifique esprit de synthèse ce que sont les OGM, dans son Laboratoire de recherche en Génétique Moléculaire, à Orsay. Christian Vélot est un lanceur d’alerte, un exemple de libre chercheur, libre penseur qui a réussi à faire sortir la science de son laboratoire pour l’amener dans le champ du débat… une nécessité absolue surtout s’agissant des applications biotechnologiques. L’intervention de Christian Vélot, dans l’émission de Daniel Mermet est un modèle du genre, en effet bien que techniquement imparfaite, elle incite l’auditeur à prendre du recul et à aller se documenter sur le sujet en le dépassionnant, en évitant l’ornière des sempiternels poncifs. De la connaissance naît la curiosité qui enrichit l’argumentation, essence de toute opinion et l’accès à ces arguments est la voie vers la décision et donc vers… la démocratie.

Qui sommes nous?

Christophe Audebert [@]

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

Renaud Blervaque [@]

Biologiste moléculaire, chargé d'études génomiques.

Biologiste moléculaire, chargé d'études génomiques.

Gaël Even [@]

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Catégories

- Analyse de données (14)

- Automatisation (5)

- Bioinformatique (27)

- Biologie (56)

- biologie transverse (35)

- Biotechnologie (30)

- Chronique littéraire (8)

- Comparatif (6)

- Diagnostic (8)

- Economie (17)

- Epidemiologie (2)

- Evénement (17)

- Formation (3)

- Gestion de projet (5)

- Grille de calcul (1)

- Intégration (5)

- Logiciels (8)

- Médecine (14)

- politique de la recherche (17)

- Recherche (21)

- Séquençage (70)

- Séquenceur (39)

- Uncategorized (25)

- Workflow (4)

Accès rapide aux articles

- Covid-19 : zoom sur les vaccins

- Comment l’ADN pourrait être le stockage de données du futur

- COVID-19 : la data visualisation au service de la science

- COVID-19 : des explications et un point d’étape au 20 février 2020

- Pour mettre du vin dans son eau

- Des petits trous, toujours des petits trous…

- Qui serait candidat ?

- Un robot pour analyser vos données…

- Monde de dingue(s)

- L’art et la manière de développer une qPCR

- Un MOOC Coursera sur le WGS bactérien

- Chercheurs & enseignants-chercheurs, l’art du multitâche.

- Un jeu de données métagénomiques

- Facteur d’impact

- Microbiote & smart city : juxtaposition de tendances

Accès mensuels

- février 2021 (1)

- décembre 2020 (1)

- février 2020 (2)

- septembre 2019 (1)

- avril 2018 (2)

- décembre 2017 (1)

- novembre 2017 (2)

- juillet 2017 (2)

- juin 2017 (5)

- mai 2017 (4)

- avril 2017 (3)

- mars 2017 (1)

- janvier 2017 (2)

- décembre 2016 (3)

- novembre 2016 (4)

- octobre 2016 (2)

- septembre 2016 (2)

- août 2016 (3)

- juillet 2016 (2)

- juin 2016 (4)

- mai 2016 (3)

- mars 2016 (1)

- novembre 2015 (2)

- avril 2015 (1)

- novembre 2014 (1)

- septembre 2014 (1)

- juillet 2014 (1)

- juin 2014 (1)

- mai 2014 (1)

- avril 2014 (1)

- mars 2014 (1)

- février 2014 (3)

- janvier 2014 (1)

- décembre 2013 (5)

- novembre 2013 (2)

- octobre 2013 (2)

- septembre 2013 (1)

- juillet 2013 (2)

- juin 2013 (2)

- mai 2013 (4)

- avril 2013 (2)

- mars 2013 (1)

- février 2013 (3)

- janvier 2013 (2)

- décembre 2012 (2)

- novembre 2012 (2)

- octobre 2012 (2)

- septembre 2012 (2)

- août 2012 (1)

- juillet 2012 (3)

- juin 2012 (5)

- mai 2012 (5)

- avril 2012 (6)

- mars 2012 (6)

- février 2012 (8)

- janvier 2012 (6)

- décembre 2011 (5)

- novembre 2011 (6)

- octobre 2011 (6)

- septembre 2011 (7)

- août 2011 (5)

- juillet 2011 (8)

Pages