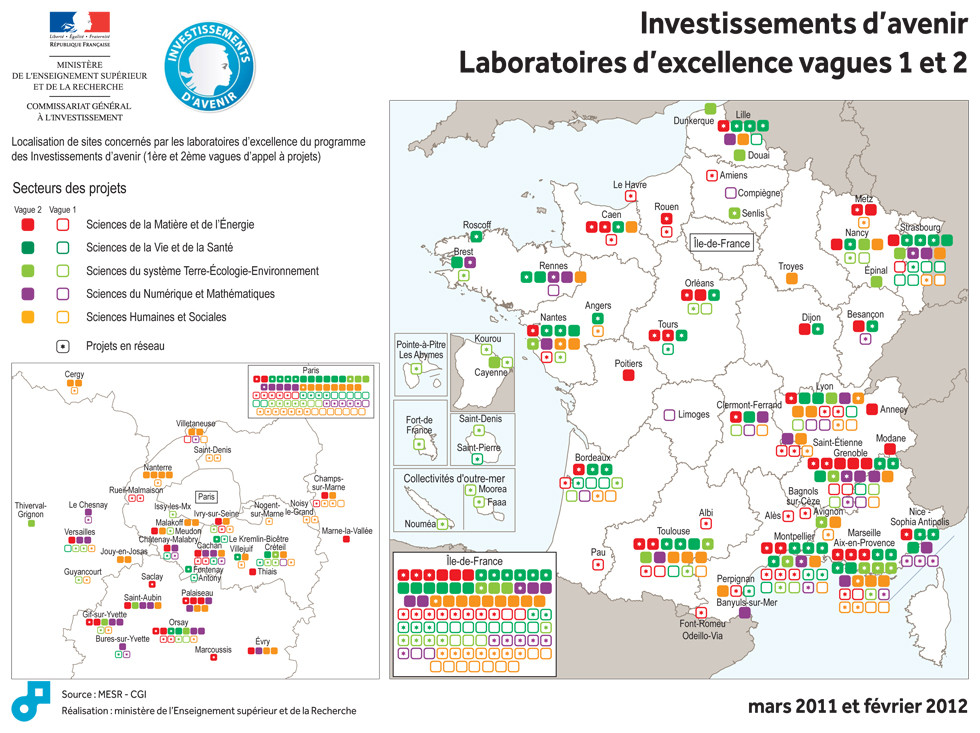

Laurent Wauquiez, ministre de l’Enseignement supérieur et de la Recherche, et Jean-Luc Tavernier, Commissaire général adjoint à l’Investissement, ont annoncé la liste des 71 lauréats de la deuxième vague de l’appel à projets « LABoratoires d’EXcellence« -fameux LABEX- doté d’une enveloppe de 1 milliard d’euros. La gestion du contenu de cette enveloppe a été confiée à l’Agence Nationale de la Recherche.

Laurent Wauquiez, ministre de l’Enseignement supérieur et de la Recherche, et Jean-Luc Tavernier, Commissaire général adjoint à l’Investissement, ont annoncé la liste des 71 lauréats de la deuxième vague de l’appel à projets « LABoratoires d’EXcellence« -fameux LABEX- doté d’une enveloppe de 1 milliard d’euros. La gestion du contenu de cette enveloppe a été confiée à l’Agence Nationale de la Recherche.

Voici un extrait du site : investissement-avenir.gouvernement.fr qui revient sur le bilan des dotations suite à cette deuxième vague du concours de l’excellence au service de la science… ou l’inverse… on ne sait plus trop :

« L’appel à projets a pour objectif d’attribuer aux laboratoires sélectionnés des moyens significatifs leur permettant d’accroître leur visibilité internationale, de faire jeu égal avec leurs homologues étrangers, d’attirer des chercheurs et des enseignants-chercheurs de renommée internationale et de construire une politique intégrée de recherche, de formation et de valorisation de très haut niveau.

195 projets ont été reçus pour cet appel et 71 ont été retenus (soit l’ensemble des projets classés A+ à A5 par un jury international, présidé par le Professeur Jean Claude Latombe, Professeur à l’université de Stanford).

Ces 71 laboratoires seront financés jusqu’en 2020 pour un montant de 534,5 M€, sachant que certains de ces laboratoires se trouveront financés dans le cadre des 8 Initiatives d’excellence désormais reconnues.

Les lauréats recevront dans les toutes prochaines semaines un acompte de 10% afin que les équipes sélectionnées puissent lancer leur projet dans les meilleurs délais.

Avec les lauréats de la première vague, ce sont donc 171 laboratoires d’excellence qui auront été sélectionnés pour un financement sur une période suffisamment longue pour leur permettre de déployer une stratégie scientifique de grande ampleur.

L’ensemble des domaines de recherche est représenté au terme de ces deux appels à projets : 14,5% en sciences du numérique et des mathématiques, 24% en sciences humaines et sociales, 20 % dans le domaine de la matière et de l’énergie, 14,6% dans le domaine des sciences de la terre et de l’environnement, 26,9% dans le secteur de la biologie-santé. »

Vous pourrez trouver le communiqué de presse comportant la liste des projets retenus accompagnée d’un court descriptif incluant les retombées économico-scientifico-sociales attendues (retour sur investissement) –> ici. Il vous suffit ou presque de regarder la carte présentée ci-dessus pour connaître les régions (ou villes universitaires) sur- ou sous-bénéficiants des investissements d’avenir… Lille devance légèrement Clermont-Ferrant et est supplantée par Strasbourg…

LABEX ou l’excellence… à tous les plats (nous avions abordé ce sujet précédemment). Une excellente lettre provenant de l’excellent blog d’Olivier Bouba-Olga, « un économiste qui suit et commente l’actualité » est disponible ici. Je vous invite chaleureusement à prendre connaissance de cette missive titrée : « l’excellence des Universités : oui, mais quelle excellence ?! ». Quelques « concepts » accompagnant la notion subjective d’excellence y sont passés en revue : de la notion de masse critique à la loi de Lotka.

Lotka a été le premier à réaliser, en 1926, une étude sur la distribution des auteurs scientifiques, arrivant à la conclusion que la relation auteurs-articles est inversement proportionnelle au carré d’articles publiés (une distribution hyperbolique)… cette constatation serait la résultante de ce que l’on nomme (en sociologie) « l’effet Saint Mathieu » qui peut être énoncé ainsi : le succès engendre encore plus de succès (ou la richesse réelle ou symbolique plus de richesse réelle ou symbolique)… Ainsi, ici transposé, le « concours » LABEX concentre des fonds très importants sur des têtes d’affiche… Quand l’état adosse sa politique d’investissements -d’avenir- sur la scientométrie, l’instrument de mesure fausse la mesure… en science on appelle cela l’effet de l’instrument…

Sequenom est une autre société californienne de biotechnologie (cotée au NASDAQ) basée à San Diego. Cette société développe des outils d’analyse génomique avec deux principales divisions:

Sequenom est une autre société californienne de biotechnologie (cotée au NASDAQ) basée à San Diego. Cette société développe des outils d’analyse génomique avec deux principales divisions:

– l’une d’elles développant des systèmes d’analyse génétique (type MassARRAY)

– l’autre se concentrant sur la recherche et développement de réactifs transférables sur la plateforme technologique développée par la première division.

Depuis 2008, Sequenom développe des outils analytiques de paillasse, les systèmes ‘MassARRAY’, appareillage compact permettant une mesure directe de la masse des acides nucléiques, offrant une précision inégalée quant à leur nature et leur quantification. Ce système, sur la base d’un spectromètre de masse, multi-MALDI-TOF MS, trouve des applications pour le génotypage, l’ analyse de la méthylation et l’expression génique. Sequenom continue d’affiner ces applications et de développer plusieurs nouvelles applications pour l’analyse de CNV (Copy Number Variation) par exemple.

Cette technologie est chahutée par les séquenceurs haut-débits de paillasse et autres systèmes permettant de génotyper une grande quantité d’échantillons tels que les systèmes proposés par Fluidigm. Le système MassARRAY bénéficie d’une sensibilité hors pair, les kits diagnostiques développés sur leur plateforme permettent à Sequenom de faire perdurer leur technologie. Les kits diagnostiques prénataux comme le MaternitT21 offre une alternative à l’amniocentèse pour diagnostiquer les trisomies 21, (en février 2012, Sequenom a lancé le MaterniT21 PLUS, permettant de diagnostiquer les trisomies 21, 18 et 13) de manière non invasive ciblant l‘ADN fœtal circulant dans le système sanguin maternel. Après des suspicions quant à un délit d’initié potentiel, des cadres de Sequenom sont surveillés par la SEC (Securities and Exchange Commission), de plus le développement des kits diagnostiques prénataux a connu des difficultés en 2010. En effet, la société a été condamnée à verser 14 millions de USD pour régler un recours (en « class-action ») : des actionnaires se sont retournés sur la société considérant que le développement du kit diagnostique de la trisomie 21 avait été plus que mal géré (notamment au niveau des essais cliniques).

La technologie MassARRAY est encore très employée pour le passage de cohortes suite à des études d’associations génétiques (les puces haute-densité sont employées dans un premier temps, suivi du passage des loci candidats sur une plateforme plus souple, telle que le MassARRAY, permettant d’interroger les mutations putativement associées au phénotype étudié). Un document en lien ici, reprend les principales caractéristiques de la plateforme de génotypage.

Bien que la plateforme MassARRAY trouve vite ses limites, la société Sequenom s’emploie à développer des solutions diagnostiques qui retardent l’obsolescence de leur technologie. La société a connu des soubresauts économico-judiciaires dont elle a su se relever, elle tente d’accélérer la diffusion de plusieurs de ces kits diagnostiques avant que sa technologie ne soit dépassée par la concurrence.

Le représentant européen des séquenceurs haut-débit de troisième génération, Oxford Nanopore va communiquer à l’AGBT… dans quelques jours. La société en profitera pour annoncer la commercialisation de ses premières machines permettant de séquencer en 24 heures un génome humain pour moins de 1000 $ (soit le même prix qu’un génome humain séquencé par un Ion Proton en 2 heures sur une plateforme de deuxième génération).

Le représentant européen des séquenceurs haut-débit de troisième génération, Oxford Nanopore va communiquer à l’AGBT… dans quelques jours. La société en profitera pour annoncer la commercialisation de ses premières machines permettant de séquencer en 24 heures un génome humain pour moins de 1000 $ (soit le même prix qu’un génome humain séquencé par un Ion Proton en 2 heures sur une plateforme de deuxième génération).

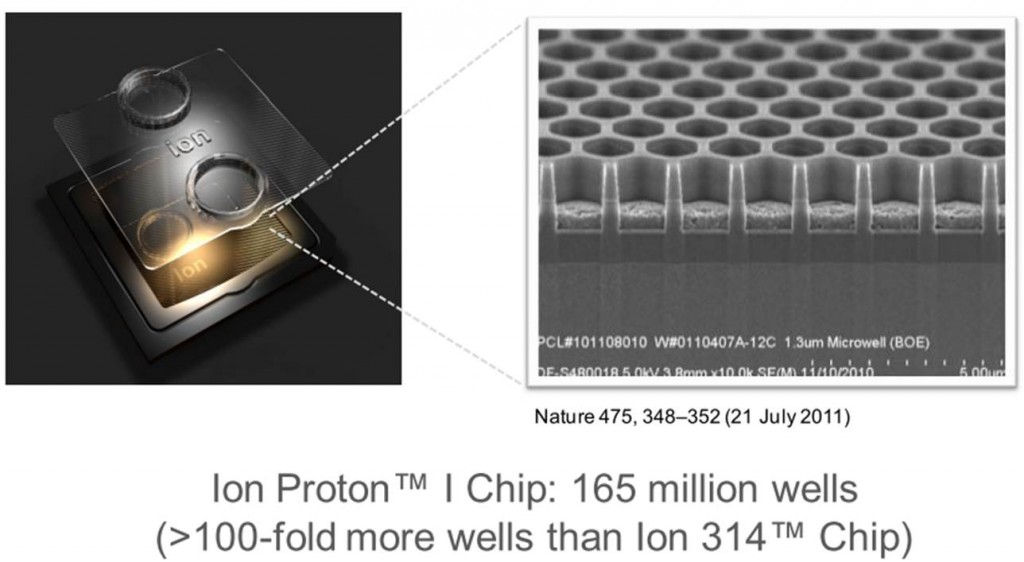

Oxford Nanopore souhaite commercialiser sa machine (en direct) avant la fin 2012. Un réelle course a lieu, puisqu’à cette échéance sera commercialisé le Ion Proton. Nous assisterons donc avant fin 2012 a un chevauchement technologique où 2ème et 3ème générations de séquenceurs risquent de se télescoper… les scientifiques en cours d’élaboration de dossiers de demandes de financements devront (vite) choisir leur camp… : partir sur une technologie qui a d’ores-et-déjà fait ses preuves (Ion Proton) donc de 2ème génération ou une technologie de 3ème génération totalement innovante… mais dont on ne possède pas de retour indépendant sur la qualité des données générées. La « guerre » technologique est lancée entre le transfuge de Solexa (technologie des séquenceurs Illumina), John Milton, le responsable scientifique d’Oxford Nanopore et la biotech’ rock-star Jonathan Rothberg, responsable scientifique de Ion Torrent chez Life Technologies.

A Davos en Suisse (dans la patrie de Roche) au forum économique mondial, Jonathan Rothberg présente son séquenceur Ion Proton, une évolution de son PGM de Life Technologies. La dépêche AFP (mise en forme par 20minutes est disponible en cliquant sur l’image ci-dessous) est dithyrambique replaçant la machine de Life Technologies dans le contexte et le champ d’application de la médecine personnalisée… jouant au passage du violon de l’affect. Le Ion Proton, fort de la démonstration menée par son petit frère le PGM depuis un an (200 machines PGM en Europe !) s’appuie sur l’efficience du séquençage à l’aide de semi-conducteurs.

Il parait évident que la médecine personnalisée aura un futur au sein des pays développés… mais il ne faut pas oublier qu’il s’agit d’un futur que l’on augurait aux puces à ADN, il y a plus de 10 ans, sans réelle démocratisation au sein des cliniques. Avant toute chose, permettre de séquencer l’équivalent d’un génome humain ou de 2 exomes humains pour la somme soutenable de 1000 $ (en 2 heures) laisse entrevoir une accélération des recherches biomédicales mais aussi de toutes les autres ! Cet outil qui torpille un MiSeq (Illumina) sorti trop tard, diffusera dans les laboratoires… il remporte, malgré ses défauts d’ores et déjà connus, la bataille du séquençage 2ème génération. Le prochain pari (plus aléatoire) porterait plutôt sur le séquençage 3ème génération dont la promesse est une lecture d’une molécule d’ADN ou d’ARN (non amplifiée artificiellement) dans son « état » originel (méthylé ou non par exemple). La 3ème génération unifie génomique et épigénétique.

Le Ion Proton devrait être livrable à partir d’octobre 2012, quelques chanceux pourront malgré tout réaliser des runs dès le milieu de l’année (il faut en acheter un minimum de 4 pour être un parmi ces privilégiés).

Un Ion Proton devrait avoir un coût proche de 140 k€ auxquels il vous faudra ajouter 65 k€ de serveur informatique.

Chaque année depuis 13 ans, l’AGBT (Advances in Genome Biology and Technology) rassemble les fournisseurs de technologies de pointe, quelques « maîtres » en la matière venant dispenser des cours du soir (sorte de « master-class ») et beaucoup de scientifiques essentiellement Nord-Américains. En effet, cette grande messe de la biologie haut-débit a lieu à Marco Island, île de Floride, lieu de villégiature pour retraités liftés percevant leurs fonds de pension sous forme de rente viagère.

Chaque année depuis 13 ans, l’AGBT (Advances in Genome Biology and Technology) rassemble les fournisseurs de technologies de pointe, quelques « maîtres » en la matière venant dispenser des cours du soir (sorte de « master-class ») et beaucoup de scientifiques essentiellement Nord-Américains. En effet, cette grande messe de la biologie haut-débit a lieu à Marco Island, île de Floride, lieu de villégiature pour retraités liftés percevant leurs fonds de pension sous forme de rente viagère.

La Côte Est américaine accueille les grandes entreprises de biotechnologies de la côte opposée pour démontrer que la Californie avec des sociétés telles que Illumina, Life technologies, Roche, Pacific Biosciences, Agilent… reste le meilleur fournisseur de technologies de pointes pour les gros centres de recherches situés sur la Côté Est (NIH, MIT-Broad Institute, Yale…). La Côte Est héberge les deux tiers des séquenceurs haut débit nord-américains. Depuis quatre ans, il faut bien le dire l’AGBT consacre le séquençage haut-débit, technologie qui vampirise la plupart des présentations (n’oublions pas que la jeune société PacBio sponsor principal, vend des séquenceurs…) et sessions « workshop »… au détriment de technologies plus « anciennes » (les puces à ADN par exemple). On le sait, ce type de rassemblements adoube la nouveauté et consacre ce que, parfois, hâtivement, on nomme : innovation.

Bien que ces rassemblements endogames sont critiquables, ils constituent une tribune pour les principaux axes de développements des technologies appliquées au vivant. L’AGBT est un tremplin dont se servent un grand nombre de firmes californiennes pour annoncer des lancements de machines à générer de la séquence. Cet évènement très américanocentré n’a pas de réel pendant européen, malgré les différentes formes prises par des rassemblements tels que le « carrefour des biotechnologies » remplacé par l’Eurobio-event. L’Eurobio-event sorte de biennale biotech’ où l’on trouve rassemblés beaucoup de vendeurs de robotiques, de pipettes… beaucoup de conférences traitant du business, de l’investissement dans les biotechnologies plus que des biotechnologies en tant que technologies. Assez peu de science dans Eurobio-event, beaucoup de business.

L’AGBT oscille quant à elle, entre un monde de scientifiques avide de nouvelles méthodes visant à l’exploitation rationnelle des flots de données issues de la biologie haut-débit (ce que représente l’illustration ci-dessus) et un monde de vendeurs de solutions appliquées à la recherche en biologie – quand les uns partagent un même « problème » et réfléchissent à une solution optimale pour sortir du sens biologique d’un amas de données, les autres vendent les générateurs de « problèmes » en misant sur la communauté scientifique mondiale pour apporter la réponse aux nouveaux problèmes générés. Il s’agit de trier l’information émanant de ce type de rassemblements en n’oubliant pas que cette vitrine – telle que peut l’être l’AGBT ou tout autre évènement de cette ampleur – peut parfois être un mirage scientifique plus qu’un virage technologique…

L’AGBT cette année 2012 aura lieu du 15 au 18 février sur l’île Marco Island : http://agbt.org/about.html, on y parlera de la technologie de Pacific Biosciences (des retours sur expériences sont prévus, avec leur 15 % de taux d’erreur de séquençage, il s’agit de LA déception technologique de l’année, mais PacBio est aussi LE sponsor principal de la réunion, quel suspens !), on y parlera aussi du futur Ion Proton…

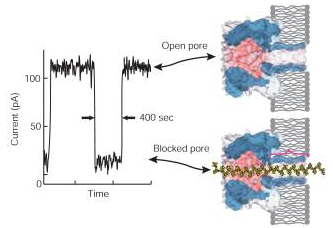

Depuis la publication de 2006, d’Astier and al., J. Am. Chem. Soc., la communauté scientifique attendait la révolution du séquençage 3ème génération que constituait la géniale idée d’Oxford Nanopore : à savoir l’alliance des nanotechnologies, du génie génétique le tout à des fins de séquençage (et plus si affinité). Ainsi, un pore d’alpha-hémolysine (d’environ 1 nanomètre) ou la porine A de Mycobacterium smegmatis ou bien encore du graphène ont été investigués pour devenir le pore idéal dans lequel, après clivage par une exonucléase des liaisons phosphodiester, les bases azotées dont l’enchaînement constitue le séquençage passe afin d’être analysées (par analysées on entend lues, la lecture étant basée sur la différence de conductance électrique liée à la nature chimique des bases azotées). Le pari, pour Oxford Nanopore réside dans le fait de trouver un mode de détection suffisamment sensible pour analyser puis par puis un signal généré par le passage d’une base au travers de pores (autrement appelés trous). La résolution de la technologie constituait un défit, sa faiblesse provenait (espérons que ce verbe se conjugue aujourd’hui au passé) de la rapidité de passage des bases à travers le pore (1 à 5 µs / base)…

Depuis la publication de 2006, d’Astier and al., J. Am. Chem. Soc., la communauté scientifique attendait la révolution du séquençage 3ème génération que constituait la géniale idée d’Oxford Nanopore : à savoir l’alliance des nanotechnologies, du génie génétique le tout à des fins de séquençage (et plus si affinité). Ainsi, un pore d’alpha-hémolysine (d’environ 1 nanomètre) ou la porine A de Mycobacterium smegmatis ou bien encore du graphène ont été investigués pour devenir le pore idéal dans lequel, après clivage par une exonucléase des liaisons phosphodiester, les bases azotées dont l’enchaînement constitue le séquençage passe afin d’être analysées (par analysées on entend lues, la lecture étant basée sur la différence de conductance électrique liée à la nature chimique des bases azotées). Le pari, pour Oxford Nanopore réside dans le fait de trouver un mode de détection suffisamment sensible pour analyser puis par puis un signal généré par le passage d’une base au travers de pores (autrement appelés trous). La résolution de la technologie constituait un défit, sa faiblesse provenait (espérons que ce verbe se conjugue aujourd’hui au passé) de la rapidité de passage des bases à travers le pore (1 à 5 µs / base)…

Une attente à émouvoir un James Dewey Watson, plusieurs publications en guise de démonstration de la faisabilité d’un tel séquençage, des appels de fonds ayant abouti à l’intégration d’Illumina au niveau du capital d’Oxford Nanopore (investissement en deux fois d’abord de 28 millions $ puis de 41 millions) ont maintenu en haleine les scientifiques avides de séquençage 3ème génération.

Oxford Nanopore est l’un des seuls acteurs européens, dans le monde du séquençage haut-débit où l’hégémonie californienne est écrasante… Alors que les Californiens (PacBio, Life, Illumina) communiquent à grand renfort d’annonces choc, Oxford Nanopore garde une part de mystère (aucune spécification réellement disponible à ce jour), nourrissant notre curiosité avec quelques publications scientifiques et quelques animations dont certaines vous sont présentées ci-dessous.

http://vimeo.com/18630569

Cette première animation reprend les différentes modalités de séquençage

http://vimeo.com/20289048

Avec la vidéo ci-dessus et celle ci-après, Oxford Nanopore réinvente le magnétoscope VHS à visée séquençage haut-débit…

http://vimeo.com/19288315

Finalement, le message à peine subliminal de ce court article : Oxford Nanopore est une société à surveiller de près… de plus en plus près.

Note : si les liens vers les vidéos ne fonctionnent pas essayer toujours en suivant celui-ci…

L’exome humain, l’ensemble des exons ou encore l’ensemble de ce qui, encodé sous forme d’ADN, peut être traduit en protéines représente environ 1,2% genome humain, 50 Mb et inclus 85 % des mutations référencées.

L’exome humain, l’ensemble des exons ou encore l’ensemble de ce qui, encodé sous forme d’ADN, peut être traduit en protéines représente environ 1,2% genome humain, 50 Mb et inclus 85 % des mutations référencées.

Emilie Lalonde et al., montre l’efficacité du séquençage d’exomes dans un article paru dans Human Mutation de 2010. La démonstration est faite au niveau de la découverte rapide des mutations associées au syndrome de Fowler, impliqué dans la prolifération anarchique des vaisseaux du cerveau qui empêche son développement. Etudiant les exons de deux patients sans lien de parenté cette équipe de Montréal a démontré l’efficacité de la capture d’exons (SureSelect, Agilent) suivi d’un séquençage haut-débit sur plateforme Illumina GAIIx (en moyenne pour les 2 expériences ont été générés 70 millions reads de 76 pb, environ 5 Gbases de séquences brutes).

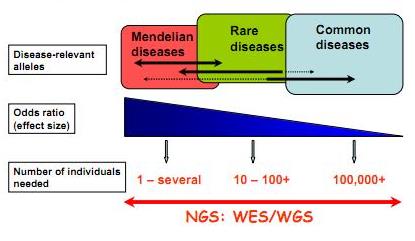

Techniquement le séquençage d’exons est relativement simple : il implique une capture par hybridation spécifique (NimbleGen, SureSelect de Agilent sont les plus employés), une purification de ces exons ou parties d’exons capturés et le séquençage haut-débit de ceux-ci… L’article de Majewski et al., disponible ici (J. Med. Genet. 2011) cerne avec brio le formidable potentiel de ces nouvelles études, avec son « qu’est ce que le séquençage d’exons peut faire pour vous ? ». Il est assez aisé de comprendre que le séquençage des régions codantes est plus accessible au niveau budget et souvent suffisant pour répondre à beaucoup de questions de cliniciens travaillant à la recherche des causalités de maladies rares. Le schéma ci-dessous, tiré de Leslie G Biesecker, Nature Genetics 42, 13–14 (2010), synthétise la procédure permettant d’aboutir rapidement à la notion de « gènes candidats » (ou plutôt de mutations causales). Les mutations témoins sont accessibles sur les bases de données mondiales dbSNP ou bien encore par l’intermédiaire du projet 1000 Génomes… dont nous avons parlé dans de précédents articles.

L’article montre à quel point l’investigation visant à la découverte des causalités d’une maladie rare, par exemple, a été totalement bouleversée. Ces technologies couplant capture d’exons et séquençage des régions codantes capturées ont d’ores et déjà montré la preuve de leur efficacité. L’article nous rappelle que le génome humain réalisé en 2001 a coûté plus de 2,7 milliards USD, qu’en 2008 un séquençage humain complet coûtait 1,5 millions de USD et qu’aujourd’hui ce même séquençage approche les 10 000 USD…

Feuille de route pour l'utilisation du séquençage haut-débit appliqué à l'identification des variations génomiques à l'origine de maladies "génétiques"

Ainsi que le montre Majewski et al. par le schéma ci-dessus plus la maladie que l’on cherche à élucider (si l’on peut s’exprimer ainsi) est la résultante d’une mutation qui a un effet fort, moins la cohorte à séquencer sera importante. En d’autres termes, pour ce qui concerne les maladies multi-factorielles (Alzheimer par exemple), le nombre d’individus dont les exons sont à séquencer sont importants… pour ce type de problématique les GWAS (Genome Wide Association Studies) par l’intermédiaire de scan de régions polymorphes anonymes sur la base de supports tels que les puces Illumina (puces permettant de scanner jusqu’à 4,3 millions de SNPs humains) restent compétitives et d’une puissance comparable. Dans le cas des maladies complexes d’autres stratégies sont développées telles qu’un premier crible sur une grande quantité de cas/témoins sur la base de puce haute densité de SNPs et un focus-séquencing des régions génomiques montrant une association potentielle avec le phénotype étudié…

Le séquençage haut-débit devenant de plus en plus accessible financièrement et par les méthodologies (pipeline d’analyses) de plus en plus disponibles permet d’envisager de nouvelles approches dans la découverte de cibles thérapeutiques potentielles. Ceci étant, l’accessibilité à des quantités de génomes de plus en plus disponibles (sans réel contrôle des organismes d’état) n’est pas sans soulever des problèmes d’éthique profonds et quelque peu négligé dans le débat scientifique actuel.

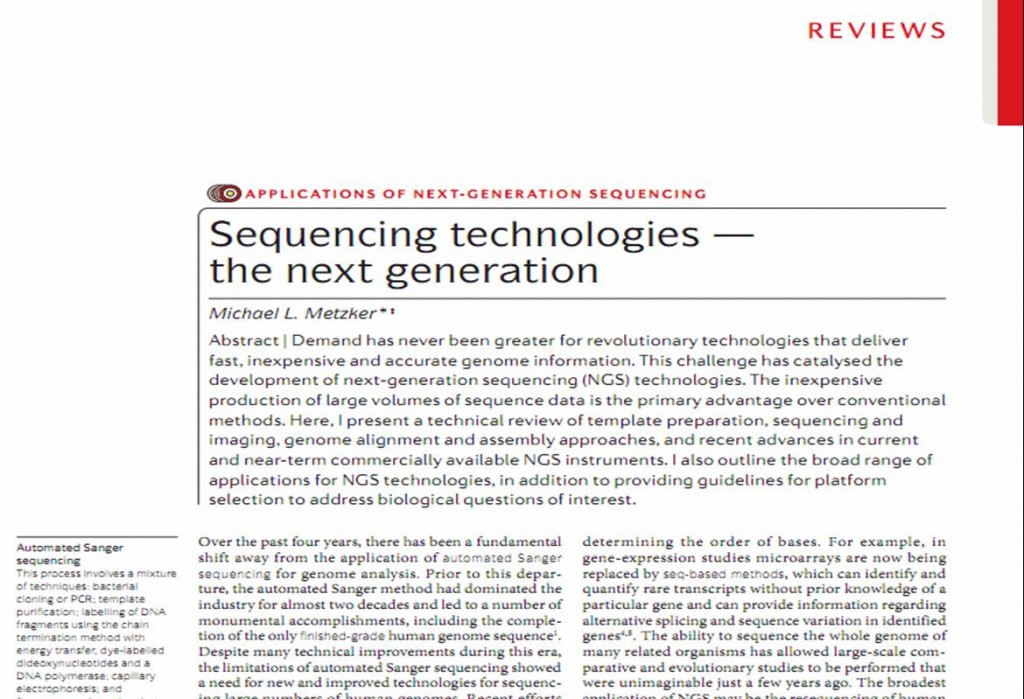

Pour continuer dans notre tour d’horizon technologique des différentes méthodes de séquençage voici une revue faisant le point sur les différentes plateformes (plutôt dans le gros calibre). Certes, cette revue date de presque deux ans et écarte d’emblée les séquenceurs de paillasse, néanmoins les schémas, plutôt bien faits, permettent d’entrevoir les subtilités des diverses modalités de séquençage. En outre, cette revue propose une base comparative argumentée permettant de se faire une opinion éclairée des capacités des diverses plateformes (comme d’habitude vous avez accès à la publication en cliquant sur l’image ci-dessous)… bonne lecture.

Voici la période de Noël… comme tout le monde, vous avez un cousin un peu pénible à qui vous devrez faire un cadeau… il est probable que ce gars devienne un vrai type bien après avoir lu le bouquin que je vais évoquer ici (rien que ça !). Un livre illustré par Charb… le créateur de « Maurice & Patapon », drôle & crado… un gars héritier de Chomsky, un autre gars drôle et intelligent qui rendra votre cousin plus… sympa après trois verres de vodka.

Voici la période de Noël… comme tout le monde, vous avez un cousin un peu pénible à qui vous devrez faire un cadeau… il est probable que ce gars devienne un vrai type bien après avoir lu le bouquin que je vais évoquer ici (rien que ça !). Un livre illustré par Charb… le créateur de « Maurice & Patapon », drôle & crado… un gars héritier de Chomsky, un autre gars drôle et intelligent qui rendra votre cousin plus… sympa après trois verres de vodka.

Ce livre permet de gagner en esprit critique (et ainsi d’être plus pertinent face à un article scientifique mais surtout plus éveillé dans sa vie de citoyen face à un journal de 20h, par exemple). Ce petit cours (humblement nommé) écrit par un militant libertaire, professeur en sciences de l’éducation semble motivé par un regret formulé par Noam Chomsky : «Si nous avions un vrai système d’éducation, on y donnerait des cours d’autodéfense intellectuelle». Normand Baillargeon, semble faire sienne la phrase fétiche partagée par Bourdieu et Castoriadis « vivre libre ou se reposer », il nous incite à faire preuve d’une grande vigilance et d’une rigueur froide (par froide s’entend dépassionnée) dans l’analyse d’une information. Le professeur en sciences de l’éducation continue son propos en tâchant de donner des moyens pour être critique, un minimum de connaissances (probabilités simples, statistiques…) suffisent à organiser une opinion. Si pour Bourdieu la sociologie est un sport de combat, pour Baillargeon la meilleure autodéfense réside dans l’éveil des consciences que l’on souhaite voir dormir.

L’auteur nous livre quelques exemples bien sentis, le tout rédigé dans une langue très claire, peu ampoulée… accessible à tous (même ceux qui ont le plus de diplômes et qui sont donc formatés par le système, ce même système qui a oublié l’enseignement de l’esprit critique dans nos chères écoles). Normand Baillargeon apporte la preuve que l’on peut être intelligent, humaniste, militant tout en étant humble… L’esprit critique pour tous : vous pourrez trouver en guise d’amuse bouche un pdf de ce petit cours en usant du lien que vous êtes en train de lire… bon appétit.

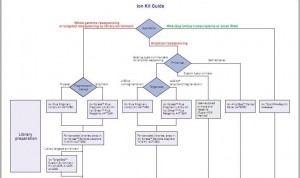

Le bien beau document que voilà ! Se repérer dans toutes les options de préparation des échantillons à séquencer, options qui sont fonctions de l’origine et de l’application que l’on souhaite mettre en oeuvre par l’intermédiaire du séquençage, peut être un réel casse-tête que ce document souhaite simplifier ici.

Cet arbre de décision s’étoffera très rapidement : d’autres branches pousseront avec les protocoles « mate pair » & « paired end », les nouvelles indexations… et surtout l’arrivée du kit permettant de séquencer 400 b… Peut être que les branches portant les options 100 b seront, quant à elles, pour l’occasion élaguées.

Cet arbre de décision s’étoffera très rapidement : d’autres branches pousseront avec les protocoles « mate pair » & « paired end », les nouvelles indexations… et surtout l’arrivée du kit permettant de séquencer 400 b… Peut être que les branches portant les options 100 b seront, quant à elles, pour l’occasion élaguées.

Ce document, et beaucoup d’autres, est disponible sur le site de la communauté Ion Torrent.

Qui sommes nous?

Christophe Audebert [@]

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

Renaud Blervaque [@]

Biologiste moléculaire, chargé d'études génomiques.

Biologiste moléculaire, chargé d'études génomiques.

Gaël Even [@]

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Catégories

- Analyse de données (14)

- Automatisation (5)

- Bioinformatique (27)

- Biologie (56)

- biologie transverse (35)

- Biotechnologie (30)

- Chronique littéraire (8)

- Comparatif (6)

- Diagnostic (8)

- Economie (17)

- Epidemiologie (2)

- Evénement (17)

- Formation (3)

- Gestion de projet (5)

- Grille de calcul (1)

- Intégration (5)

- Logiciels (8)

- Médecine (14)

- politique de la recherche (17)

- Recherche (21)

- Séquençage (70)

- Séquenceur (39)

- Uncategorized (25)

- Workflow (4)

Accès rapide aux articles

- Covid-19 : zoom sur les vaccins

- Comment l’ADN pourrait être le stockage de données du futur

- COVID-19 : la data visualisation au service de la science

- COVID-19 : des explications et un point d’étape au 20 février 2020

- Pour mettre du vin dans son eau

- Des petits trous, toujours des petits trous…

- Qui serait candidat ?

- Un robot pour analyser vos données…

- Monde de dingue(s)

- L’art et la manière de développer une qPCR

- Un MOOC Coursera sur le WGS bactérien

- Chercheurs & enseignants-chercheurs, l’art du multitâche.

- Un jeu de données métagénomiques

- Facteur d’impact

- Microbiote & smart city : juxtaposition de tendances

Accès mensuels

- février 2021 (1)

- décembre 2020 (1)

- février 2020 (2)

- septembre 2019 (1)

- avril 2018 (2)

- décembre 2017 (1)

- novembre 2017 (2)

- juillet 2017 (2)

- juin 2017 (5)

- mai 2017 (4)

- avril 2017 (3)

- mars 2017 (1)

- janvier 2017 (2)

- décembre 2016 (3)

- novembre 2016 (4)

- octobre 2016 (2)

- septembre 2016 (2)

- août 2016 (3)

- juillet 2016 (2)

- juin 2016 (4)

- mai 2016 (3)

- mars 2016 (1)

- novembre 2015 (2)

- avril 2015 (1)

- novembre 2014 (1)

- septembre 2014 (1)

- juillet 2014 (1)

- juin 2014 (1)

- mai 2014 (1)

- avril 2014 (1)

- mars 2014 (1)

- février 2014 (3)

- janvier 2014 (1)

- décembre 2013 (5)

- novembre 2013 (2)

- octobre 2013 (2)

- septembre 2013 (1)

- juillet 2013 (2)

- juin 2013 (2)

- mai 2013 (4)

- avril 2013 (2)

- mars 2013 (1)

- février 2013 (3)

- janvier 2013 (2)

- décembre 2012 (2)

- novembre 2012 (2)

- octobre 2012 (2)

- septembre 2012 (2)

- août 2012 (1)

- juillet 2012 (3)

- juin 2012 (5)

- mai 2012 (5)

- avril 2012 (6)

- mars 2012 (6)

- février 2012 (8)

- janvier 2012 (6)

- décembre 2011 (5)

- novembre 2011 (6)

- octobre 2011 (6)

- septembre 2011 (7)

- août 2011 (5)

- juillet 2011 (8)

Pages