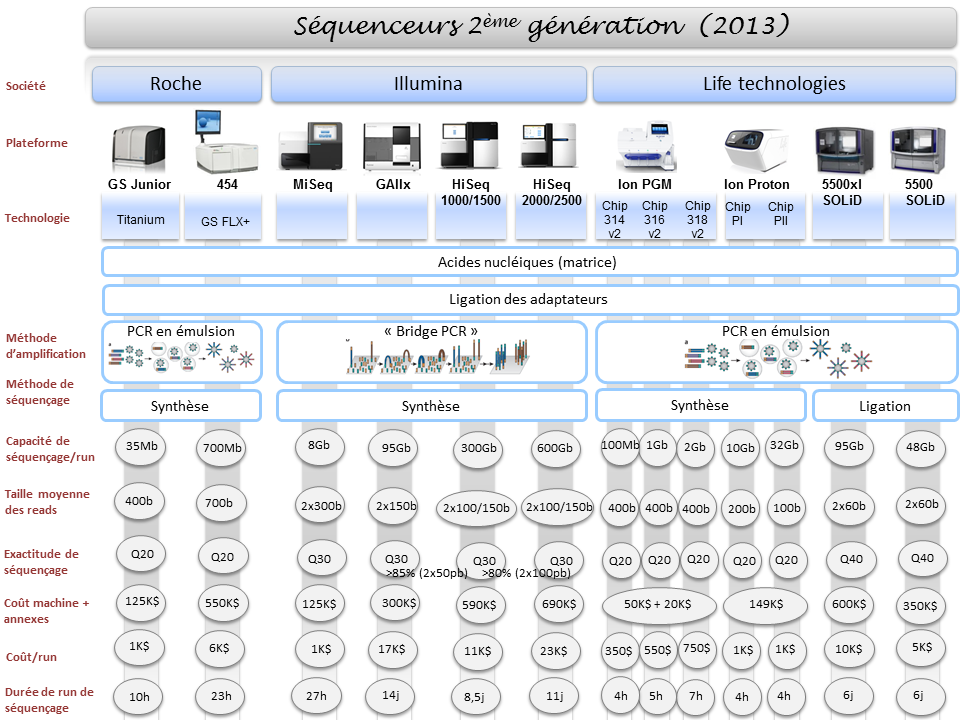

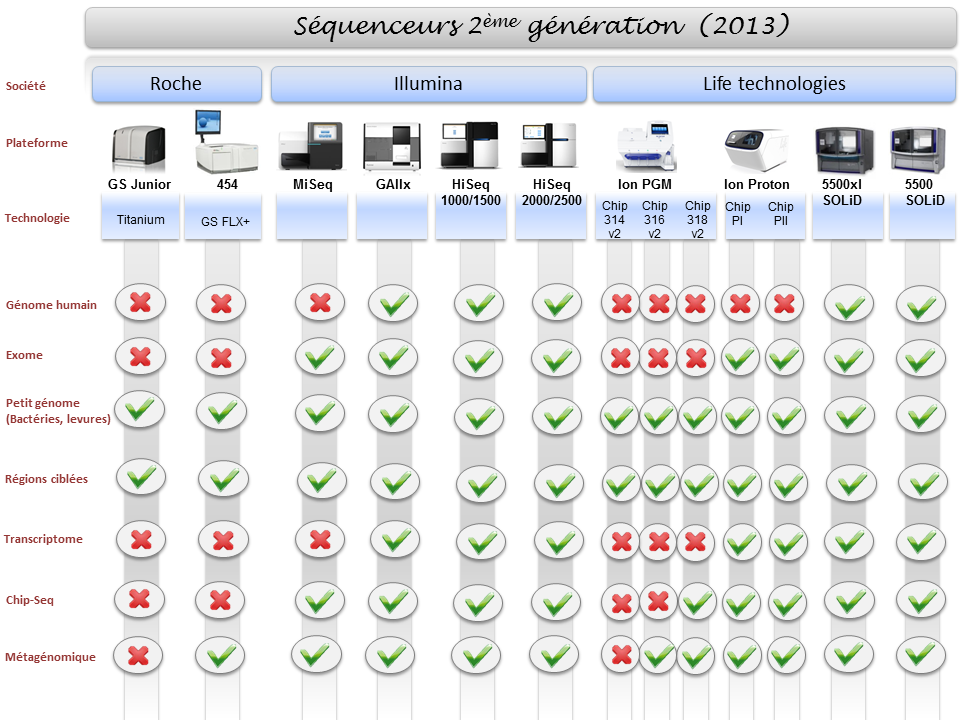

La diversité du parc technologique des séquenceurs de deuxième génération n’est plus une surprise pour personne. Ceci étant, il devenait indispensable de mettre à jour l’ensemble des informations postées sur ce site, il y a exactement deux ans (2011), faisant un état de l’art des différentes caractéristiques technologiques des séquenceurs, ainsi que les possibles applications biologiques associées.

Pour ne mentionner que les trois plus gros fournisseurs du marché, les sociétés Roche, Illumina et Life Technologies n’ont cessé de faire évoluer leur gamme, tant sur le plan des équipements que sur le plan des capacités de séquençage.

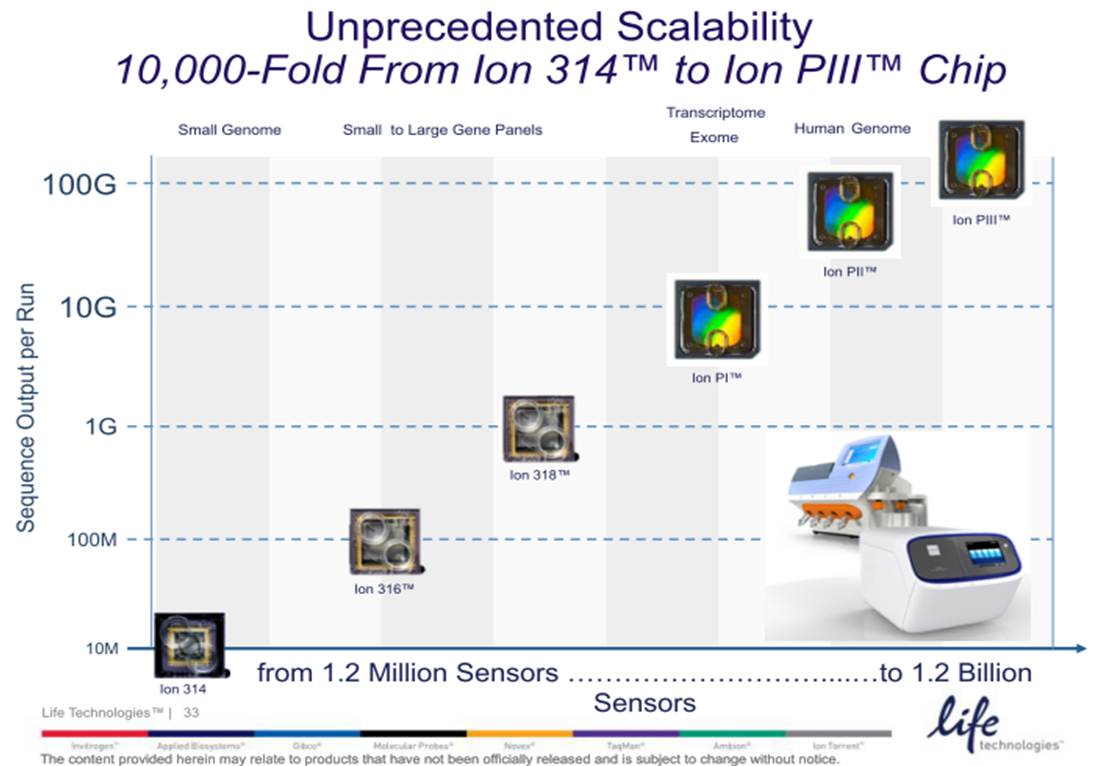

Par voie de conséquence, ce survol est l’occasion de refaire le point sur les technologies appropriées selon l’application biologique recherchée. A noter que le Ion proton, dernier en date sur le marché des séquenceurs de deuxième génération disposera au cours de l’année 2014 d’une puce « PIII » permettant de générer environ 64Gb. Cette capacité de séquençage permettra à Ion torrent de se positionner sur le séquençage de génome humain à partir d’un séquenceur de paillasse et accèdera ainsi à la gamme complète des applications citées ci-dessous.

Ce qui suit pourrait être tiré d’un roman d’anticipation technofuturiste où le héros s’empêtre dans un polar aux implications géopolitiques. Après la mise en application de la politique de l’enfant unique, politique lancée en 1979 par Deng Xiaoping qui a eu la fâcheuse conséquence d’induire un déséquilibre entre les sexes (116 garçons pour 100 filles, 2005), la Chine, forte de sa population de presque 1 milliard 400 millions de ressortissants, cherche à appliquer les lois de la sélection génomique sur sa propre population. Le Q.I., phénotype relativement héritable (héritabilité supérieure à 0,5) est le deuxième caractère, après le sexe, « choisi » par les autorités. Cette article développe les différents éléments qui ont permis à la Chine de devenir le premier pays transhumaniste.

Ce qui suit pourrait être tiré d’un roman d’anticipation technofuturiste où le héros s’empêtre dans un polar aux implications géopolitiques. Après la mise en application de la politique de l’enfant unique, politique lancée en 1979 par Deng Xiaoping qui a eu la fâcheuse conséquence d’induire un déséquilibre entre les sexes (116 garçons pour 100 filles, 2005), la Chine, forte de sa population de presque 1 milliard 400 millions de ressortissants, cherche à appliquer les lois de la sélection génomique sur sa propre population. Le Q.I., phénotype relativement héritable (héritabilité supérieure à 0,5) est le deuxième caractère, après le sexe, « choisi » par les autorités. Cette article développe les différents éléments qui ont permis à la Chine de devenir le premier pays transhumaniste.

Acte 1 : une politique de reconquête

La Chine possède des ports en Europe, une partie significative de la dette américaine, des milliers d’hectares agricoles en Afrique et un parc de bombes atomiques qui ne laisserait pas insensible le docteur Folamour. Malgré un budget de millions de dollars alloué à une armée aux ordres du parti unique, l’usine du monde ne semble pas avoir de volonté expansionniste impérialiste en vue de repousser ses frontières (si on omet le sujet du Tibet). Il semble que les ambitions de la Chine actuelle résident moins dans le fait de mettre à la disposition de l’occident sa main-d’œuvre bon marché que de devenir la première puissance mondiale matérielle et intellectuelle. c’est pourquoi le pays mise toujours sur sa vraie matière première : l’humain. Devenue une puissance spatiale avec ses Taikonautes, la Chine envoie dans les meilleures universités du monde, ses étudiants qui, de retour (pour ceux qui reviennent), accomplissent une recherche de tout premier plan. Dans le champ de la génomique et des biotechnologies, la Chine s’impose aujourd’hui comme un acteur de tout premier plan.

Acte 2 : une recherche efficace

En effet, la Chine compte plus d’un cinquième de la population mondiale et compte aussi sur la volonté de fer pour retrouver son lustre d’antan. Il est alors, relativement aisé d’imaginer que même si une portion faible de sa population atteint les études supérieures, le pays sélectionne des étudiants qui deviendront des chercheurs motivés et ayant émergé des tous meilleurs étudiants d’une classe d’âge donné. Il est passé le temps où les meilleurs chercheurs chinois s’exilaient inconditionnellement aux Etats-Unis pour finir par être naturalisés – le classement académique des universités mondiales (aussi appelé classement de Shanghaï, ou encore « Academic Ranking of World Universities » en anglais) est un outil parfait pour identifier les meilleures universités où envoyer ses étudiants. La Chine devient même attractive sur la scène mondiale de la recherche scientifique et technologique. Selon un rapport de l’OCDE, le pays est deuxième pour la dépense en recherche et développement, injectant 136 milliards US$ en 2006 (USA : 330 milliards US$ pour la même période).

L’Empire du milieu oriente sa politique du développement technologique dans des domaines jugés comme hautement stratégiques: l’énergie, les ressources naturelles, l’environnement, les techniques de production industrielle et les technologies de l’information, les biotechnologies, les nanotechnologies, les technologies spatiales et maritimes. La Chine est en tête des pays en nombre de brevets déposés par année, ceci est l’aboutissement de trente ans durant lesquels le pays a misé sur la recherche scientifique pour rattraper son retard technologique sur l’Occident. Depuis le début des années 2000, le gouvernement promeut une innovation purement chinoise. Concernant le niveau des étudiants chinois, ceux-ci commencent à être l’objet de discriminations dans certaines universités américaines où ils occupent les meilleurs places. La recherche scientifique, basée sur une « exportation » massive d’étudiants a permis à la Chine de rattraper son retard technologique, cette technologie aujourd’hui sert une recherche scientifique de tout premier plan et sert, en ce qui concerne la biotechnologie, un dessein qui peut faire peur, vu d’ici.

Acte 3 : des moyens puissants

L’exemple qui vient à l’esprit immédiatement est le BGI (Beijing Genomics Institute). A ce sujet, vous pouvez lire notre précédent article : Taylor + Deng Xiao Ping + Watson = la Chine marche sur les chromosomes. Rappelons que le BGI est la plus grande plateforme génomique mondiale et un contributeur scientifique de tout premier ordre. Grâce à des plateformes de haute-technologie permettant de générer des volumes de séquences et de typages à de très bas coût, la Chine aurait la possibilité d’appliquer les résultats de sa recherche scientifique à l’échelle de sa vaste population.

Le BGI développe un laboratoire de génétique cognitive avec pour ambition de répondre à ces questions : Comment fonctionne le cerveau humain ? Comment les gènes affectent la capacité cognitive ? Comment les gènes et l’environnement interagissent pour produire l’intelligence et la personnalité humaine ? Le BGI a lancé un recrutement d’une cohorte de personnes volontaires aux Q.I. élevés. L’objectif est donc de rechercher les variations génétiques associées à des variations significatives au niveau du Q.I. (notons qu’une étude cas-témoin eut nécessité une cohorte de Q.I. bas à très bas… difficile de procéder à un recrutement volontaire !). Le Q.I. étant plutôt héritable, il sera donc techniquement possible de sélectionner les porteurs des variants « Q.I. élevé ». Ainsi il est possible de procéder à deux niveaux :

– orientation / optimisation « d’accouplements » : les porteurs de ces variations « Q.I. élevé », après s’être génotypés, auront tendance à rechercher un conjoint lui aussi porteur de ces mêmes variations afin de maximiser leur chance de procréer un enfant lui même porteur de ces variations (notons ici qu’il n’y a pas de réel progrès génétique, en tant que tel)

– passons par l’étape FIV : évitant de miser sur le hasard, les gamètes des deux futurs parents produiront plusieurs dizaines d’embryons, chaque œuf sera biopsié (une petite étape de phi29, un génotypage ciblé ou une sélection génomique sur la base de l’exploitation d’un génotypage pan-génomique à l’aide d’une cartographie basée sur plusieurs millions de marqueurs SNPs humains). Fort de la connaissance du « Q.I. estimé » de ces dizaines d’œufs… il ne restera qu’à « contrecarrer » l’aléa de méiose et de ne ré-implanter que ceux présentant le meilleur score de Q.I. estimé…

La sélection humaine pose bien évidemment des problème de bioéthique. Si l’occident sélectionne d’ores et déjà des êtres humains dans le but de limiter les enfants nés porteurs de tares génétiques majeures, l’Empire du milieu semble parti sur une autre voie (même si cette voie n’empêche pas l’autre) : améliorer significativement le Q.I. de sa population et ainsi basculer dans l’ère de la transhumanisation (selon ce mouvement intellectuel, l’Homme doit prendre en main sa propre évolution).

La sélection humaine pose bien évidemment des problème de bioéthique. Si l’occident sélectionne d’ores et déjà des êtres humains dans le but de limiter les enfants nés porteurs de tares génétiques majeures, l’Empire du milieu semble parti sur une autre voie (même si cette voie n’empêche pas l’autre) : améliorer significativement le Q.I. de sa population et ainsi basculer dans l’ère de la transhumanisation (selon ce mouvement intellectuel, l’Homme doit prendre en main sa propre évolution).

Après le Q.I., le grand jeu du moment consiste à deviner quel sera le phénotype de choix (la docilité ?, le courage ?), il faut espérer que l’on attendra quelques décennies avant d’envisager le premier humain OGM… Envisageant cela, on caricature la démarche actuelle chinoise et on s’imagine, un peu, à la place de Charlton Heston à la fin de Soleil Vert (film de Richard Fleischer, sorti en 1973) quand il découvre la matière première constitutive de l’aliment qui nourrit une planète devenue stérile.

Quand l’histoire d’un homme entre en collision avec l’Histoire évolutive des hominidés et de ce que Carl Linnaeus en 1758, nomma Homo sapiens, cela produit un article au titre provoquant : « L’homme qui ne descendait pas d’Adam » (Pierre Barthélémy dans son excellent blog, Passeur de Sciences, 10 mars 2013).

Quand l’histoire d’un homme entre en collision avec l’Histoire évolutive des hominidés et de ce que Carl Linnaeus en 1758, nomma Homo sapiens, cela produit un article au titre provoquant : « L’homme qui ne descendait pas d’Adam » (Pierre Barthélémy dans son excellent blog, Passeur de Sciences, 10 mars 2013).

Tout d’abord, il semble utile de rappeler le concept d’Adam et Eve phylogénétique. Théologues rangez vos saintes écritures, il s’agit ici d’un concept scientifique et technique d’anthropogénétique. Les variations génétiques liées au chromosome Y, ainsi que celles présentes sur la mitochondrie sont utilisées pour étudier l’histoire de ces seuls fragments chromosomiques. L’Adam du chromosome Y et l’Ève mitochondriale ne sont donc que des vues de l’esprit.

Parlons donc du cas d’Albert Perry dont le chromosome Y ne ressemblait à rien de connu. Actuellement, l’Adam du chromosome Y a vécu théoriquement entre 60.000 et 140.000 ans avant maintenant (la Eve mitochondriale quant à elle, aurait théoriquement vécu entre 140.000 et 240.000 ans avant maintenant). Surprise, après étude du chromosome Y d’Albert Perry, on s’étonne d’être passé à côté de cette lignée humaine. En exhumant des bases de données dont visiblement l’analyse n’avait pas été complète, Mendez et al. ont trouvé 11 séquences issues du chromosome Y de 11 membres de la tribu des Mbo (An African American Paternal Lineage Adds an Extremely Ancient Root to the Human Y Chromosome Phylogenetic Tree, AJHG, 2013). Cette tribu est plus ou moins localisée au Nord Ouest du Cameroun, une région d’où a été déporté un grand nombre d’esclaves. Le fait d’ajouter cette lignée humaine « oubliée », l’âge de notre Adam théorique doublerait (en accord avec la théorie de la coalescence) pour être comprise entre 237-581 000 ans.

- Carte localisant approximativement les personnes parlant le dialecte des Mbo – tirée de AJHG, Mendez et al., 2013

Le cas Perry est un exemple intéressant à plusieurs titres. En tout premier lieu, il permet de voir comment un cas particulier étudié peut avoir une incidence sur la compréhension de l’histoire humaine. En ce sens, ceci est à porter au crédit de la génomique personnelle : avec le développement des sociétés telles que 23andMe, on peut présumer que dans un avenir proche, les nouvelles données que le particulier payera afin de connaitre sa propre histoire, serviront peut être à l’ensemble de la communauté scientifique… tel que l’exemple d’Albert Perry (passé à la postérité) le suggère. Ensuite, cet exemple montre à quel point la connaissance est relative. Notre développement technologique, notre puissance de génération de données avec pour limite actuelle le temps accordé à leur analyse, laissent présager que de plus en plus vite notre connaissance sera volatile, les références changeront de plus en plus vite…

Ce petit article est aussi l’occasion de vous proposer une visite sur le très beau, très documenté blog francophone : The fossil and Mr Darwin et particulièrement de prendre le temps de lire l’article dont il est question ici : mais où est passé Adam ?

Bonne lecture !

Lancé en avril 2012, Coursera est une entreprise qui propose un accès gratuit à un ensemble de cours en ligne. Rien de nouveau par rapport aux nombreux MOOC (pour « massive open online course ») de plus en plus présents sur la toile? Dans cet article nous égrènerons les principales caractéristiques de Coursera : ses atouts, en quoi il se démarque du cours en ligne classique et pourquoi il pourrait constituer une petite révolution dans le monde éducatif .

– La plupart des MOOC sont très centrés autour de l’informatique (on peut le comprendre), des sciences mathématiques et de l’ingénierie. Coursera propose un panel de cours très variés, allant de la médecine à la poésie en passant par l’économie et l’histoire, sans oublier la biologie et la bioinformatique. On trouve même des cours de guitare en ligne!

– Coursera a conclu un partenariat avec des dizaines d’universités (dont de très prestigieuses) à travers le monde, offrant ainsi des cours de haute qualité dans différentes langues: fin 2012 Coursera annonce 680 000 inscrits provenant de 42 pays.

– Pour les instructeurs, Coursera est un catalyseur de propagation du savoir, certains cours dépassant les 100 000 étudiants, beaucoup plus que les 400 étudiants qu’un professeur peut espérer instruire chaque année dans son université. Un professeur de l’université de Stanford a ainsi calculé que son cours Coursera de 100 000 étudiants revenait à distiller des cours à une classe pendant 250 ans!

– Les cours sont fixés dans le temps, renouvelés, interactifs avec l’insertion de questionnaires au milieu des présentations, des exercices à rendre et à corriger, des forums pour partager. L’apprentissage est clairement maximisé si on se donne la peine de suivre assidument les cours. Coursera s’appuie sur des principes pédagogiques simples :

- Les questionnaires et exercices permettent d’ancrer le savoir

- Le partage et les corrections des exercices par ses pairs donnent une vision différente sur son travail et la façon dont l’étudiant a lui-même assimilé (se mettre à la place du correcteur en quelque sorte)

- L’organisation en classes: la présence d’un forum permet de partager son expérience et ses conseils avec ses pairs , ce qui est plus motivant.

– Pour les étudiants /autodidactes, c’ est une aubaine : participer à des cours réservés d’habitude à une élite et tout cela gratuitement, vive le e-learning!

Pour l’instant le plan d’affaire semble un peu flou. Pour plus de détails vous pouvez consulter la page Wikipedia dédiée à Coursera. Des certificats de participation authentifiés sont déjà délivrés (de l’ordre de 30 à 60$ par cours) pour permettre à l’e-étudiant de valoriser les compétences acquises. Coursera pourrait aussi vendre votre profil à des entreprises de recrutement (avec l’accord des étudiants). A terme des frais de scolarité pourraient être également appliqués.

Les nouveaux MOOC tels que Coursera, Udacity (MOOC plutôt centré sur les disciplines scientifiques) ou edX ( association à but non-lucratif ) sont-ils en train de révolutionner notre façon d’apprendre? Il nous faudra attendre quelques années avant de mesurer l’impact de cette propagation à grande échelle de l’apprentissage. Va-t-on assister à une véritable explosion du nombre d’autodidactes aussi compétents que de nouveaux diplômés? Ou cette manne de savoir va-t-elle rester marginale et utilisée par une élite déjà formée par le système universitaire « classique » et avide de nouvelles connaissances?

Pour finir, voici les principaux cours liés aux biotechnologies actuellement sur Coursera :

A plus long terme, vous retrouverez également un cours de l’université de Melbourne sur l’épigénétique qui commencera au 1er juillet et un cours d’introduction à la bioinformatique par l’université de San Diego d’ici la fin d’année 2013.

La liste complète des cours autour des sciences de la vie est disponible à cette adresse : https://www.coursera.org/courses?orderby=upcoming&cats=biology

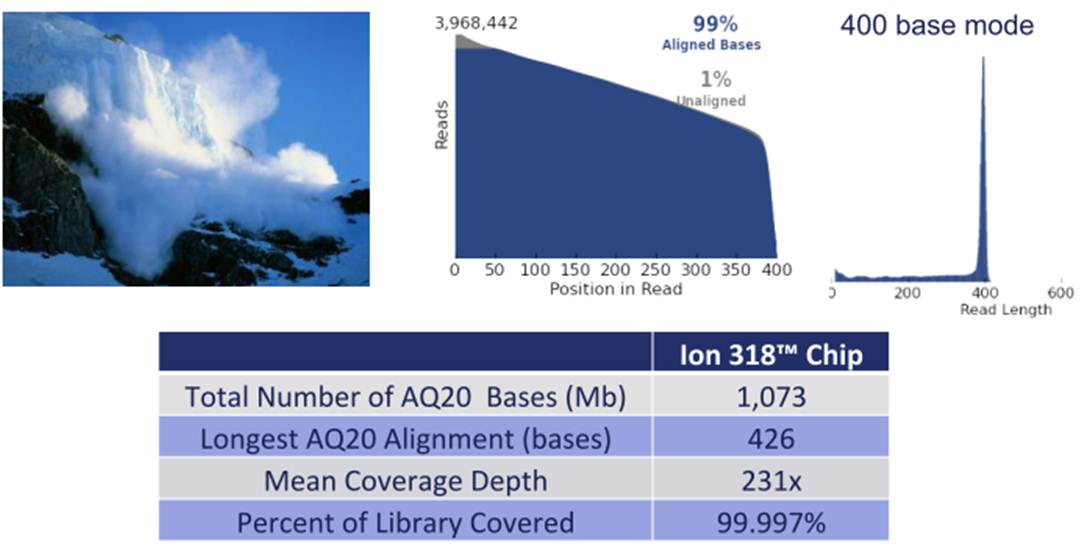

Le mois de décembre 2012 a connu le lancement du kit 400 bases (

Le mois de décembre 2012 a connu le lancement du kit 400 bases (

Ion PGM™ Template OT2 400 Kit) qui est principalement attendu pour les applications de séquençage de novo et de séquençage d’amplicons ciblant le 16S, 18S ou encore ITS2 (respectivement pour l’étude de la diversité bactérienne, eucaryote ou fongique) pour les études métagénomiques. Comme vous pouvez le constater cette application est uniquement supportée par le One Touch 2 devenu nécessaire pour accéder aux reads de 400 bases (c’est en partie pour cette raison que notre plateforme PEGASE-Biosciences a décidé de se doter de cette automate).

L’autre nouveauté est portée par les consommables de séquençage associés au Ion Proton (le grand frère du PGM). En effet, si la Puce Ion PIII est encore virtuelle, la PI et PII, permettent de délivrer : 10 Gb et 70 millions de reads filtrés environ pour la première, contre plus de 280 de millions de reads et plus de 70 Gb pour la seconde (de quoi séquencer un génome humain à 20 X).

Du côté de Life Technologies et de sa technologie Ion Torrent, sans aucun doute, la principale nouveauté de l’année 2013 touche l’amplification clonale (phase où, à partir de la librairie préparée, est réalisée la matrice de séquençage fixée de manière covalente sur des billes qui se logeront dans les puits présents sur la puce). Ainsi, la fameuse (et pour certains la fâcheuse) phase de PCR en émulsion trouvera une alternative avec la chimie isothermique dite « avalanche » (dont vous pouvez voir l’aperçu d’un run ci-dessous). A en croire Life Technologies, cette chimie ouvre la voie à des tailles de séquences générées encore plus longues.

Bien entendu, Life Tech annonce l’arrivée d’un nouvel automate permettant d’intégrer la nouvelle chimie mais aussi de charger les puces (et pour quelques dizaines de k€, d’épargner au manipulateur les deux phases délicates du séquençage).

Pour conclure brièvement, l’une des nouveautés et non des moindres : l’acceptation du PGM comme diagnostic moléculaire CE-IVD (un parcours pas vraiment de tout repos) a n’en pas douter une conformité qui ne devrait pas laisser insensible les chercheurs, praticiens hospitaliers.

DNA-Vision est devenue en 2011, le prestataire européen en génomique avec la plus grande puissance de séquençage (quatre systèmes Solid, deux HiSeq2000, un GAIIx, tous deux d’Illumina, et deux 454-de chez Roche). La petite société issue de l’Université Libre de Bruxelles (ULB) et fondée en 2004 a bien grandi et est actuellement dirigée par Laurent Alexandre. Ce dernier est le créateur du site e-toubib, Doctissimo, aujourd’hui détenteur de 80 % de DNA-Vision, suite à la vente de son site internet à Lagardère qui a permis à l’ex-chirurgien de devenir riche… engrangeant plus de 139 millions d’euros suite à la transaction. Il faut dire que le docteur en médecine, chirurgien urologue, énarque et diplômé en sciences politiques a été à l’origine de plusieurs sociétés dans le domaine médical : Benefit, Medcost, Clinics et enfin le site préféré des hypocondriaques, Doctissimo. C’est avec pour idée principale d’appliquer le séquençage, en profitant de sa vertigineuse baisse de coûts, au champ de la médecine personnalisée que le médecin essayiste, auteur de « la mort de la mort » est devenu président de la société DNAvision. Même s’il est vrai que, l’encore assez nouveau président de DNAVision, préparant l’entrée en bourse de son entreprise, parle de médecine personnalisée, la société belge est connue pour sa maîtrise des technologies haut-débit et à titre d’exemple, pour son expertise du séquençage appliqué aux études métagénomiques (vous pouvez lire : Impact of diet in shaping gut microbiota revealed by a comparative study in children from Europe and rural Africa, PNAS, avril 2010).

DNA-Vision est devenue en 2011, le prestataire européen en génomique avec la plus grande puissance de séquençage (quatre systèmes Solid, deux HiSeq2000, un GAIIx, tous deux d’Illumina, et deux 454-de chez Roche). La petite société issue de l’Université Libre de Bruxelles (ULB) et fondée en 2004 a bien grandi et est actuellement dirigée par Laurent Alexandre. Ce dernier est le créateur du site e-toubib, Doctissimo, aujourd’hui détenteur de 80 % de DNA-Vision, suite à la vente de son site internet à Lagardère qui a permis à l’ex-chirurgien de devenir riche… engrangeant plus de 139 millions d’euros suite à la transaction. Il faut dire que le docteur en médecine, chirurgien urologue, énarque et diplômé en sciences politiques a été à l’origine de plusieurs sociétés dans le domaine médical : Benefit, Medcost, Clinics et enfin le site préféré des hypocondriaques, Doctissimo. C’est avec pour idée principale d’appliquer le séquençage, en profitant de sa vertigineuse baisse de coûts, au champ de la médecine personnalisée que le médecin essayiste, auteur de « la mort de la mort » est devenu président de la société DNAvision. Même s’il est vrai que, l’encore assez nouveau président de DNAVision, préparant l’entrée en bourse de son entreprise, parle de médecine personnalisée, la société belge est connue pour sa maîtrise des technologies haut-débit et à titre d’exemple, pour son expertise du séquençage appliqué aux études métagénomiques (vous pouvez lire : Impact of diet in shaping gut microbiota revealed by a comparative study in children from Europe and rural Africa, PNAS, avril 2010).

Revenons au moins un instant sur le séquençage haut-débit appliqué à la médecine personnalisée, vu comme le fait de rendre accessible au soignant l’information génomique de son patient.

A une époque où le Dossier Médical Unique (DMP) a grand mal à devenir une évidence, à une période où l’accès universel aux soins est de plus en plus remis en question pour des raisons de disette financière, l’accès à une archive de plusieurs Gigaoctets de données par patient semble peu crédible à court terme. Ajoutés à cela les problèmes d’éthique, de confidentialité de données et de formation du personnel soignant à l’interprétation de ces données et vous comprendrez que le rêve d’un Laurent Alexandre aura du mal à toucher la médecine de masse mais pourra séduire les cliniques privées qui échappent à la problématique d’un accès universalisé aux soins.

On voit qu’à l’instar du tourisme spatial, la cible ne semble pas vraiment être le chômeur en fin de droit. La médecine pour pas grand monde… puisque si un séquençage coûte de moins en moins cher, l’interprétation des données générées et l’intégration de ces données dans un réel parcours médical est encore inaccessible aux 99 % des personnes les plus pauvres des 10 % des pays les plus riches.

Malgré tout, la médecine personnalisée dépasse cette vision de l’ADN. En effet, la médecine personnalisée comporte plusieurs approches :

– la détermination du risque (un génotypage haut-débit chez 23andme ou un séquençage chez un autre quidam pour vous dire que vous avez 2,03 % de chance de plus que la moyenne d’être atteinte de la maladie d’Alzheimer)

– la médecine stratifiée où seuls les patients répondant positivement à l’administration d’une solution curative, minimisant les effets secondaires de celle-ci, seront traités.

– la thérapie génique (un peu passée de mode) pour laquelle il existe trois types de thérapies : la transfection permanente d’ADN, la transfection transitoire d’ADN, les thérapies portant sur l’ARN.

Si le séquençage multiparallélisé de l’ADN a tendance à se démocratiser au sein des laboratoires de recherche et de certains laboratoires en usant comme diagnostic, il semble qu’un pas de géant reste à franchir pour que celui-ci transforme complètement notre vision de la médecine. La médecine personnalisée n’est cependant pas à remettre en question… il s’agit juste de lui donner un horizon réaliste et réalisable, sans quoi cette notion sera à ranger, comme beaucoup d’autres avant, aux rayons des mots clés usés par la mode.

Si le séquençage multiparallélisé de l’ADN a tendance à se démocratiser au sein des laboratoires de recherche et de certains laboratoires en usant comme diagnostic, il semble qu’un pas de géant reste à franchir pour que celui-ci transforme complètement notre vision de la médecine. La médecine personnalisée n’est cependant pas à remettre en question… il s’agit juste de lui donner un horizon réaliste et réalisable, sans quoi cette notion sera à ranger, comme beaucoup d’autres avant, aux rayons des mots clés usés par la mode.

La paléogénétique, la science qui permet de remonter le temps, a trouvé sous la forme de séquenceurs haut-débit, sa DeLorean… en route vers l’Ardèche, dans l’antre de la grotte Chauvet. La grotte Chauvet, inventée en 1994, comporte 420 représentations d’animaux d’une incroyable diversité technique. C’est en partie les déductions menées à partir de l’étude de cette grotte, que l’on a remis en cause l’idée d’un art (pariétal) évoluant lentement et de manière linéaire. L’art peut être vu comme une suite d’apogées et de déclins, un concept s’opposant à l’idée d’un art co-évoluant avec le progrès technique et la diffusion du savoir-faire et des connaissances.

La paléogénétique, la science qui permet de remonter le temps, a trouvé sous la forme de séquenceurs haut-débit, sa DeLorean… en route vers l’Ardèche, dans l’antre de la grotte Chauvet. La grotte Chauvet, inventée en 1994, comporte 420 représentations d’animaux d’une incroyable diversité technique. C’est en partie les déductions menées à partir de l’étude de cette grotte, que l’on a remis en cause l’idée d’un art (pariétal) évoluant lentement et de manière linéaire. L’art peut être vu comme une suite d’apogées et de déclins, un concept s’opposant à l’idée d’un art co-évoluant avec le progrès technique et la diffusion du savoir-faire et des connaissances.

Les œuvres de la grotte Chauvet démontrent q’au début du Paléolithique supérieur, des artistes étaient capables d’une abstraction intellectuelle (une certaine conceptualisation) pour préparer la paroi calcaire et penser le dessin, tout en maitrisant des techniques complexes (estompes,perspective…). L’observation des traces humaines, à la grotte Chauvet comme dans beaucoup de lieux montrant une activité préhistorique, est accompagnée d’analyses de mesures physico-chimiques. Ainsi, avec d’autres méthodes, la datation radiométrique au carbone 14 a été employée pour permettre une estimation de l’âge absolu d’un échantillon organique… la grotte ardéchoise aurait hébergé les artistes du paléolithique autour de 31 000 ans avant notre ère. Assez nouvellement les techniques de génomique trouvent un champ d’application au niveau de la l’histoire des populations et viennent compléter les autres types d’observations pour nous reconstituer ce que le temps a détruit ou transformé.

Le carbone 14 génomique pourrait (en quelque sorte) être constitué par l’ADN mitochondrial. L’ADNmt est ici pris comme témoin (plus ou moins stable) des espèces disparues et sert de base aux études phylogénétiques, loin de Jurassic Park mais néanmoins enthousiasmant… mais est ce vraiment aussi simple ?

En effet, de par sa stabilité présumée au fil de l’évolution, l’ADNmt est devenu une cible de choix pour l’étude de la diversité des populations : a priori, les gènes déterminant la fonction respiratoire de la cellule sont moins la cible d’adaptations fréquentes à des changements environnementaux que, par exemple, ceux de l’immunité, situés, eux, dans l’ADN nucléaire. Je vous conseille vivement, à ce sujet, la lecture de l’article suivant, remettant en cause ce paradigme (cf. CNRS – le journal – mars 2007).

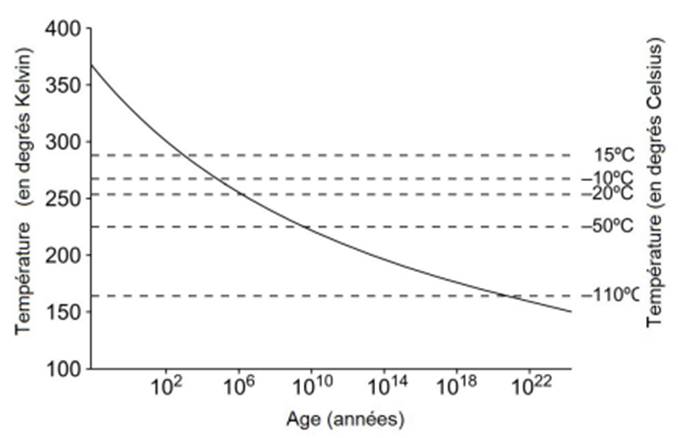

Mais revenons à l’utilisation du séquençage haut-débit pour remonter le temps. Le temps a fait son œuvre quant à la première étape de la préparation de la librairie, la fragmentation. « Dans les régions tempérées, ce sont les échantillons provenant de grottes qui sont souvent les mieux conservés (cf. figure ci-dessous). Dans les grottes, la température reste très stable, autour d’une valeur comprise entre 10 et 15°C. De plus, les grottes se creusent dans des environnements karstiques, riches en calcium et de pH neutre ou basique, qui sont des conditions propices à la conservation de la matière organique et de l’ADN en particulier. » – Extrait de la thèse de Céline Bon (CEA – page 50 – 25 juin 2012).

Temps de survie d’un ADN de taille supérieure à 100 pb

Le séquençage haut-débit devient réellement d’un grand intérêt dans l’étude du métagénome des coprolithes et des ossements retrouvés dans ces grottes. La capture d’écran ci-dessous vous mènera en cliquant dessus, sur une partie du site du CEA où une vidéo simple et efficace, reprend les propos de Jean-Marc Elalouf. Ce dernier aborde l’exceptionnelle conservation des ossements qui a permis aux biologistes d’en analyser l’ADN et ainsi de faire de nouvelles avancées sur l’étude des espèces éteintes et la phylogénie des ours des cavernes.

Pour rien vous cacher, il s’agit ici d’un article avec un petit goût d’auto-promotion. En effet, les 3 membres de Biorigami participent aussi activement à une plateforme d’expertise nouvellement créée, cette entité a pour ambition la réalisation de quelques prestations, principalement en génomique haut-débit, mais aussi la participation à des projets nécessitant conseils, expertises et analyses… pour répondre au mieux aux questions biologiques posées. Enchaînons en citant les pages actualités du site internet de Gènes Diffusion : « cette alliance entre les deux structures (ndlr : Gènes Diffusion et l’Institut Pasteur de Lille) a pris le nom de PEGASE (Plateforme d’Expertises Génomiques Appliquées aux Sciences Expérimentales). Elle permet de mutualiser les moyens de la branche R&D génomique de Gènes Diffusion et du laboratoire TAG (Transcriptomic analysis and Applied Genomics) de l’Institut Pasteur de Lille.

La création de cette unité devrait permettre le développement de nouvelles activités, collaborations scientifiques et prestations, dès les prochains mois

Issue de la collaboration entre Gènes Diffusion et l’Institut Pasteur de Lille, PEGASE (Plateforme d’Expertises Génomiques Appliquées aux Sciences Expérimentales) vient de lancer son site web. Cette présence sur le web permettra à la nouvelle structure de faire l’interface avec les différents acteurs de la génomique.

Par ailleurs, le site permettra également de faire partager à la communauté scientifique les différentes expertises en biologie moléculaire et bio-informatique issues des travaux de recherche de l’unité. »

Vous pourrez obtenir plus de précision concernant cette nouvelle plateforme en suivant le lien suivant : www.pegase-biosciences.com.

Pour les plus joueurs d’entre vous, un concours est lancé pour fêter cette naissance, le projet exécutable sur puce 318 de Ion Torrent, sera réalisé par nos soins, gratuitement… pour plus de précisions, nous vous invitons à suivre le lien suivant : concours PEGASE.

Un document qui n’est pas sans rappeler celui publié en novembre 2011, en intégrant les dernières mises à jour.

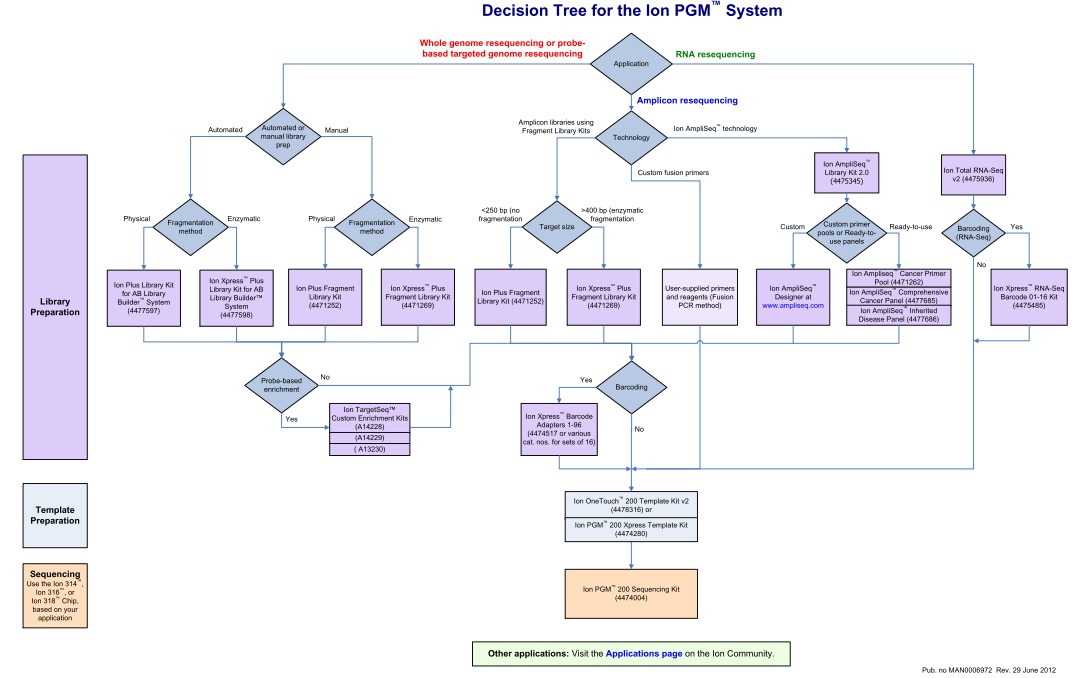

Cet arbre de décision est l’occasion de retrouver l’ensemble des modalités de séquençage qu’offre la technologie Ion Torrent via le PGM. En attendant l’arrivée du kit permettant de séquencer 400b, l’essentiel des modifications résident dans la préparation des échantillons avec notamment de nouvelles indexations (évolution du kit à 96 barcodes en DNA-seq et apparition du kit à 16 barcodes en RNA-seq), un élargissement du panel de primers dédiés à la recherche sur le cancer, etc…

Pour les privilégiées de la Ion Community, ce document est également l’occasion de retrouver aisément la liste des protocoles Ion Torrent selon l’ application d’intérêt en cliquant sur le lien en bas de page.

Les outils d’assemblage, de mapping sur référence deviennent relativement pléthoriques… il est de ce fait relativement aisé de choisir l’outil permettant de gérer au mieux les défauts de votre séquenceur, vous n’avez que l’embarras du choix en somme. Même si cette étape n’est pas à négliger, il n’en reste pas moins que le rôle du biologiste restera toujours d’apporter du sens à une ou plusieurs millions de séquences, informations qui viendront tenter d’élucider une question biologique. Les outils permettant de faire parler un ensemble de reads, que vous pratiquiez le de novo RNA-seq ou séquençage génomique de novo sont plutôt restreints, peu diffusés, limités ou tout simplement absents… Ces grands absents constituent le point noir de l’analyse secondaire de vos reads. De nombreux biologistes recherchent un financement (séquencer massivement coûte encore un peu cher !), font séquencer l’objet de leur étude -hors humain, rat, souris- repartent quand tout va bien avec de beaux contigs, et se retrouvent face à un livre écrit dans une langue inconnue. Ce livre est censé renfermer la réponse à beaucoup de leurs questions… on comprend leur frustration d’autant qu’ils ne possèdent pas de pierre de Rosette.

Les outils d’assemblage, de mapping sur référence deviennent relativement pléthoriques… il est de ce fait relativement aisé de choisir l’outil permettant de gérer au mieux les défauts de votre séquenceur, vous n’avez que l’embarras du choix en somme. Même si cette étape n’est pas à négliger, il n’en reste pas moins que le rôle du biologiste restera toujours d’apporter du sens à une ou plusieurs millions de séquences, informations qui viendront tenter d’élucider une question biologique. Les outils permettant de faire parler un ensemble de reads, que vous pratiquiez le de novo RNA-seq ou séquençage génomique de novo sont plutôt restreints, peu diffusés, limités ou tout simplement absents… Ces grands absents constituent le point noir de l’analyse secondaire de vos reads. De nombreux biologistes recherchent un financement (séquencer massivement coûte encore un peu cher !), font séquencer l’objet de leur étude -hors humain, rat, souris- repartent quand tout va bien avec de beaux contigs, et se retrouvent face à un livre écrit dans une langue inconnue. Ce livre est censé renfermer la réponse à beaucoup de leurs questions… on comprend leur frustration d’autant qu’ils ne possèdent pas de pierre de Rosette.

Cet article part d’un constat, l’important est moins de savoir si votre séquenceur fournit les reads les plus propres, les plus longs, si votre assembleur est le plus adapté… car tous ces efforts resteront vains si vous écrivez un livre dont personne ne peut comprendre le sens. J’arrête là de filer la métaphore.

Blast2GO -ici dans sa version gratuite- est un outil qui trouvera vite (trop vite) ses limites mais qui permettra d’apporter du sens à des séquences générées à haut-débit. La publication de Conesa et al. (Bioinformatics – 2005), dévoile le pipeline d’analyse. Grossièrement, il s’agit de blaster des séquences (en 2005 – on envisageait par séquences des reads et non des reads assemblés) automatiquement sur le serveur du NCBI, les résultats de blast sont récupérés, les autres phases du pipeline sont réalisées en interrogeant les bases de données de Blast2GO, in fine des termes GO permettent d’annoter les séquences dont on souhaite décoder le sens. La principale qualité de Blast2GO réside dans son ergonomie, l’interface Java6 permet une prise en main directe (aucune ligne de code). Ses défauts sont multiples… tout d’abord Blast2GO plante… très régulièrement, ensuite pour une séquence d’entrée (dont la taille sera nécessairement inférieure à 7000 bases) vous ne disposerez que d’une annotation pour le meilleur des hits.

Qui sommes nous?

Christophe Audebert [@]

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

Renaud Blervaque [@]

Biologiste moléculaire, chargé d'études génomiques.

Biologiste moléculaire, chargé d'études génomiques.

Gaël Even [@]

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Catégories

- Analyse de données (14)

- Automatisation (5)

- Bioinformatique (27)

- Biologie (56)

- biologie transverse (35)

- Biotechnologie (30)

- Chronique littéraire (8)

- Comparatif (6)

- Diagnostic (8)

- Economie (17)

- Epidemiologie (2)

- Evénement (17)

- Formation (3)

- Gestion de projet (5)

- Grille de calcul (1)

- Intégration (5)

- Logiciels (8)

- Médecine (14)

- politique de la recherche (17)

- Recherche (21)

- Séquençage (70)

- Séquenceur (39)

- Uncategorized (25)

- Workflow (4)

Accès rapide aux articles

- Covid-19 : zoom sur les vaccins

- Comment l’ADN pourrait être le stockage de données du futur

- COVID-19 : la data visualisation au service de la science

- COVID-19 : des explications et un point d’étape au 20 février 2020

- Pour mettre du vin dans son eau

- Des petits trous, toujours des petits trous…

- Qui serait candidat ?

- Un robot pour analyser vos données…

- Monde de dingue(s)

- L’art et la manière de développer une qPCR

- Un MOOC Coursera sur le WGS bactérien

- Chercheurs & enseignants-chercheurs, l’art du multitâche.

- Un jeu de données métagénomiques

- Facteur d’impact

- Microbiote & smart city : juxtaposition de tendances

Accès mensuels

- février 2021 (1)

- décembre 2020 (1)

- février 2020 (2)

- septembre 2019 (1)

- avril 2018 (2)

- décembre 2017 (1)

- novembre 2017 (2)

- juillet 2017 (2)

- juin 2017 (5)

- mai 2017 (4)

- avril 2017 (3)

- mars 2017 (1)

- janvier 2017 (2)

- décembre 2016 (3)

- novembre 2016 (4)

- octobre 2016 (2)

- septembre 2016 (2)

- août 2016 (3)

- juillet 2016 (2)

- juin 2016 (4)

- mai 2016 (3)

- mars 2016 (1)

- novembre 2015 (2)

- avril 2015 (1)

- novembre 2014 (1)

- septembre 2014 (1)

- juillet 2014 (1)

- juin 2014 (1)

- mai 2014 (1)

- avril 2014 (1)

- mars 2014 (1)

- février 2014 (3)

- janvier 2014 (1)

- décembre 2013 (5)

- novembre 2013 (2)

- octobre 2013 (2)

- septembre 2013 (1)

- juillet 2013 (2)

- juin 2013 (2)

- mai 2013 (4)

- avril 2013 (2)

- mars 2013 (1)

- février 2013 (3)

- janvier 2013 (2)

- décembre 2012 (2)

- novembre 2012 (2)

- octobre 2012 (2)

- septembre 2012 (2)

- août 2012 (1)

- juillet 2012 (3)

- juin 2012 (5)

- mai 2012 (5)

- avril 2012 (6)

- mars 2012 (6)

- février 2012 (8)

- janvier 2012 (6)

- décembre 2011 (5)

- novembre 2011 (6)

- octobre 2011 (6)

- septembre 2011 (7)

- août 2011 (5)

- juillet 2011 (8)

Pages