Le séquençage haut-débit voit cohabiter depuis quelques années deux générations de séquenceurs.

Au passage, une question Trivial Pursuit pour laquelle il faudra avoir un œil de caracal : quelqu’un sait quelle société a développé la première génération de séquenceurs haut-débit ? et quand ?

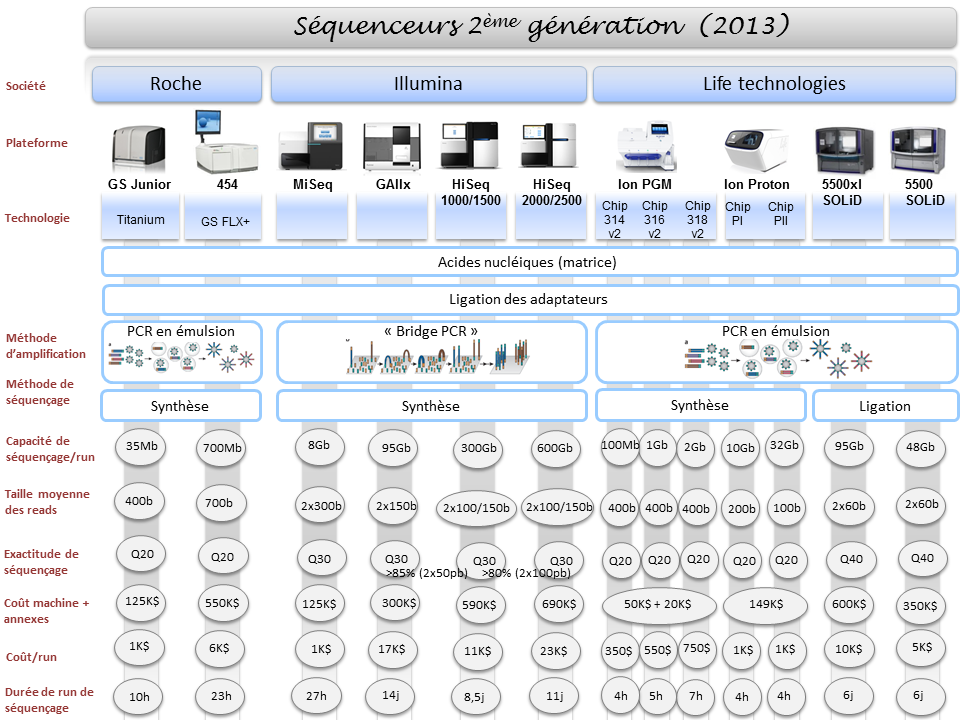

Les séquenceurs de deuxième génération se voient conditionnés sous forme de séquenceurs de paillasse (PGM de Ion Torrent, Miseq d’Illumina, GS-junior de Roche) permettant une démocratisation du séquençage, pendant que leurs grands frères pulvérisent la loi de Moore pour envisager un rendement (coût / Mb) toujours plus compétitif.

La large diffusion du séquençage de 3ème génération se laisse désirer laissant le champ libre à la génération précédente. Cet article vise à réaliser un court état des lieux du séquençage haut-débit de troisième génération : un futur plus ou moins lointain, de nouvelles applications potentielles.

La question : séquenceurs de 3ème génération, l’âge de raison, c’est pour quand ? est l’interrogation qui a hanté l’AGBT 2013 marqué par le silence d’Oxford Nanopore. Cette année 2013 fut marquée par le retrait d’Illumina du capital de la société britannique : « Oxford Nanopore Technologies Ltd a annoncé la vente d’une participation détenue par son concurrent américain Illumina Inc., une étape vers la fin d’une relation pleine de conflits dans la course au développement des séquenceurs haut-débit permettant de séquencer plus rapidement et pour moins cher. »

Avant de caractériser ce que sont, seront, pourront être les 3ème générations de séquenceurs, commençons par un rapide tour des caractéristiques générales de leurs prédécesseurs et principalement de ce qui constitue leurs points faibles :

– la phase d’amplification clonale (réalisée par PCR) est source de biais (doublons, erreurs de PCR)

– les problèmes liés au déphasage engendrant une chute de la qualité le long du read produit (ce qui bride la production de reads vraiment longs)

-des reads courts (de moins d’une centaine à environ 800 bases – vous l’aurez noté ce point est en partie une conséquence du précédent)

-des machines et des consommables onéreux

– des temps de run longs

Ainsi l’objectif principal des séquenceurs de 3ème génération est de palier les défauts de leurs aînés en produisant des reads plus longs, plus vite pour moins cher. Les séquenceurs de 2ème génération, quels que soient leurs modes de détection (mesure de fluorescence, mesure de pH) sont trop peu sensibles pour envisager la détection d’une simple molécule, d’un simple nucléotide : nécessairement la librairie doit être amplifiée, ce qui provoque des biais, des temps de préparation relativement longs et l’usage de consommables qui impacte le coût final de séquençage… assez rapidement la qualité chute plus vos reads s’allongent ce qui oblige à brider les tailles de reads que ces technologies sont capables de délivrer. En outre, travaillant sur une matrice qui est une copie de votre librairie initiale, l’information portée par les bases méthylées est perdue (ceci oblige à ajouter une phase de traitement au bisulfite qui peut être hasardeuse)

Actuellement l’une des seules technologies de 3ème génération réellement utilisée est celle de Pacific Biosciences (les hipsters disent « PacBio »). La firme, fondée en 2004, a lancé en 2010, son premier séquenceur de troisième génération le Pacbio RS basé sur une technique de séquençage SMRT (Single Molecule Real Time sequencing.) Aujourd’hui la société Roche qui n’a pu absorber Illumina lors de son OPA, a investi 75 millions de USD, le 25 septembre 2013, pour co-développer des kits diagnostiques in vitro exploitant la technologie de PacBio.

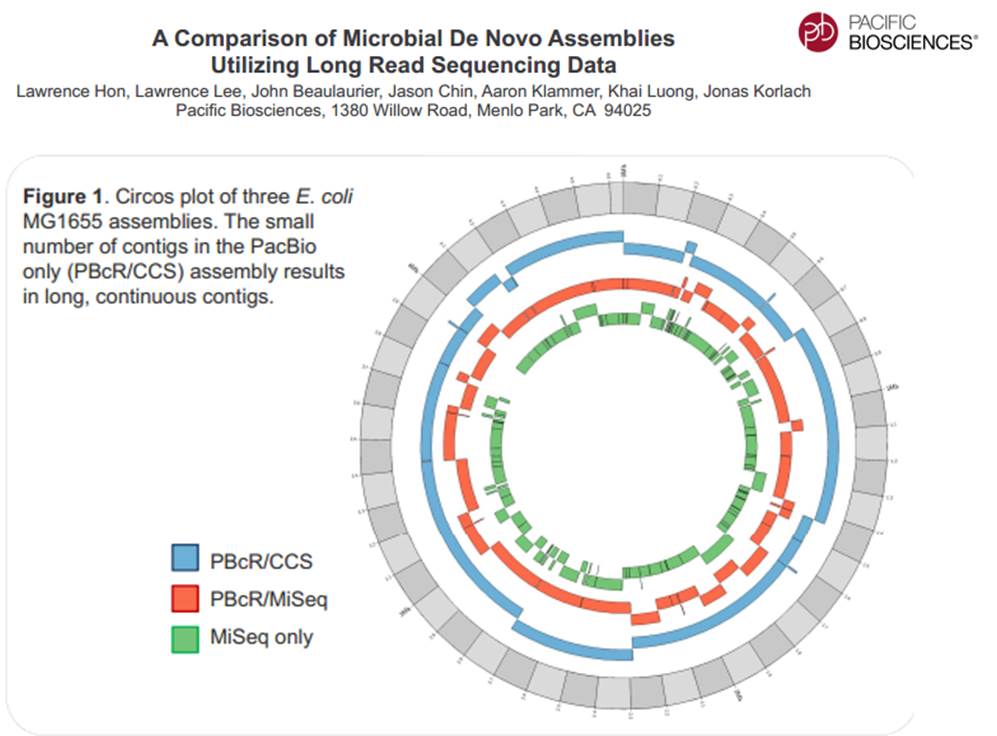

La technologie de PacBio est aujourd’hui exploitée pour réaliser du séquençage de novo de petits génomes :

Avec ces 200 à 300 Mb délivrés par SMRT-cell, séquencer des organismes eucaryotes supérieurs demande un investissement important, malgré tout, cette technologie délivrant des reads de plusieurs milliers de bases, permet d’envisager une diminution du nombre de contigs obtenus par les seules stratégies reads-courts / gros débit.

Face à la technologie proposée par PacBio, d’autres technologies essaient d’émerger pour arriver à occuper le marché du séquençage de 3ème génération :

– La combinaison détection optique et multipore est une voie envisagée pour le séquençage de 3ème génération avec le travail mené par NobleGen biosciences.

– L’imagerie directe de l’ADN

Le microscope électronique offre une résolution possible jusqu’à 100 pm, de sorte que les biomolécules et les structures microscopiques tels que des virus, des ribosomes, des protéines, des lipides, des petites molécules et des atomes même simples peuvent être observés. Bien que l’ADN est visible lorsqu’on l’observe avec un microscope électronique, la résolution de l’image obtenue n’est pas suffisamment élevée pour permettre le déchiffrement de la séquence, c’est à dire, le séquençage de l’ADN. Cependant, lors du marquage différentiel des bases de l’ADN avec des atomes lourds ou des métaux, un tel séquençage devient possible.

– Le séquençage à l’aide de transistor (Transistor-mediated DNA sequencing– une technologie développée par IBM)

Dans le système conceptualisé par IBM, l’ADN est contraint de passer par le pore à cause de la tension électrique subie, la vitesse de passage de la molécule à séquencer est maîtrisée à l’aide de contacts métalliques à l’intérieur du nanopore. La lecture des bases serait réalisée lors du passage de l’ADN simple brin au travers du pore (ça rappelle quelque chose…)

– Et Oxford Nanopore dans tout cela ? Si la société anglaise a annoncé la vente de la participation d’Illumina, elle a marqué l’année 2013 par son silence assourdissant. Passé l’oxymore, en cette fin d’année, coup de poker ou réel lancement, Oxford Nanopore propose un programme d’accès à sa technologie Minion où pour 1000 USD, il est possible de postuler à l’achat des clés USB de séquençage.

La stratégie d’Oxford Nanopore est basée, en partie, sur la possible démocratisation du séquençage de 3ème génération, elle s’oppose à celle de PacBio qui mise sur son arrivée précoce sur le secteur du séquençage haut-débit : décentralisation contre l’inverse. En clair, l’investissement d’un PacBio est tel que l’outil est réservé à des centres, des prestataires de services pouvant assumer cet investissement, ce qui oblige à centraliser les échantillons pour les séquencer, contre les produits (encore en développement) d’Oxford Nanopore dont la promesse est : le séquençage pour tous (ou presque).

PacBio revendique sa participation à un projet qui consiste à doubler la quantité de génomes bactériens « terminés » (actuellement de 2384) en quelques mois.

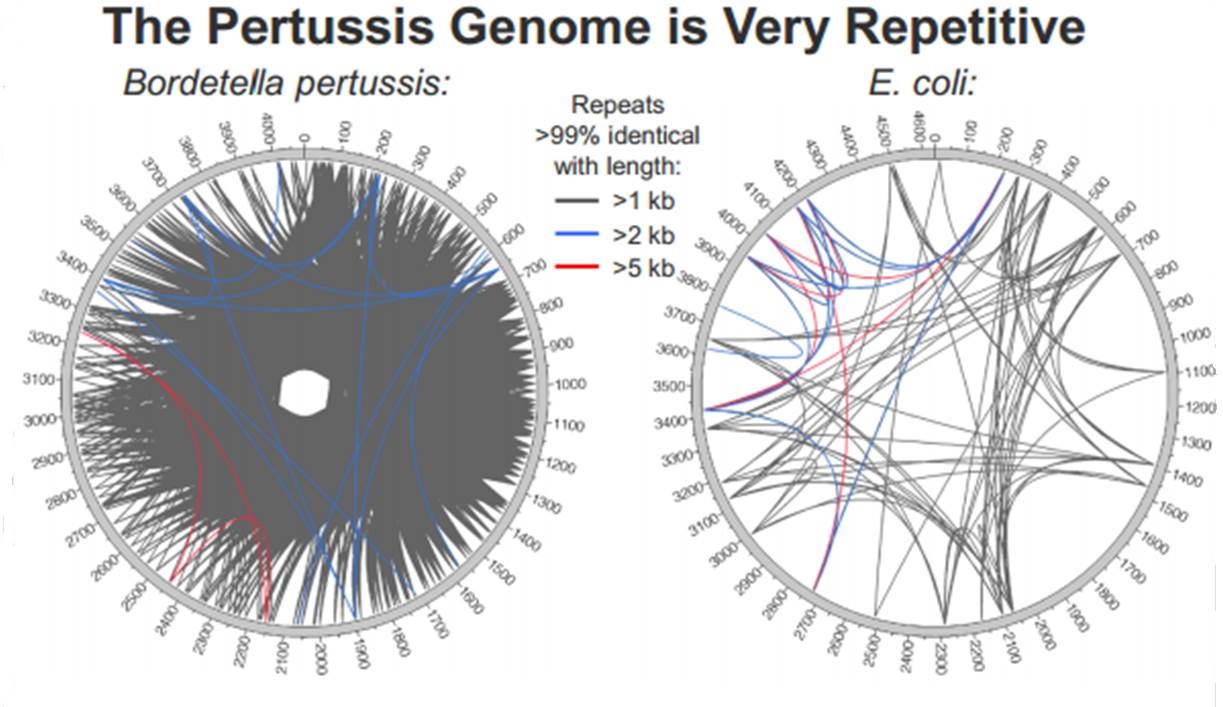

En cliquant ci-dessus sur la représentation graphique qui illustre la différence de plasticité de génome entre le génome d’une Bordetella pertussis (l’agent pathogène responsable de la coqueluche) et celui d’Escherichia coli, un poster vous apparaîtra. Ce dernier reprend les caractéristiques de l’utilisation de la technologie de PacBio à des fins d’assemblage de novo de génomes bactériens par une stratégie non-hybride (seuls des reads de PacBio sont utilisés). Les résultats sont assez bluffants, la longueur des reads de PacBio permet un assemblage complet (au prix de plusieurs SMRT cells tout de même !), de génomes bactériens « difficiles » tel que celui de Bordetella pertussis connu pour posséder un GC % relativement élevé (environ 65 %) ainsi que de nombreux éléments transposables. Les génomes possédant de nombreux éléments répétés posent de grandes difficultés d’assemblage, c’est un des arguments qui permet à PacBio de positionner sa technologie actuellement… en quelques mois les stratégies hybrides (reads courts générés par des séquenceurs de 2ème génération) ont laissé place aux stratégies non-hybrides où le séquençage PacBio se suffit à lui-même.

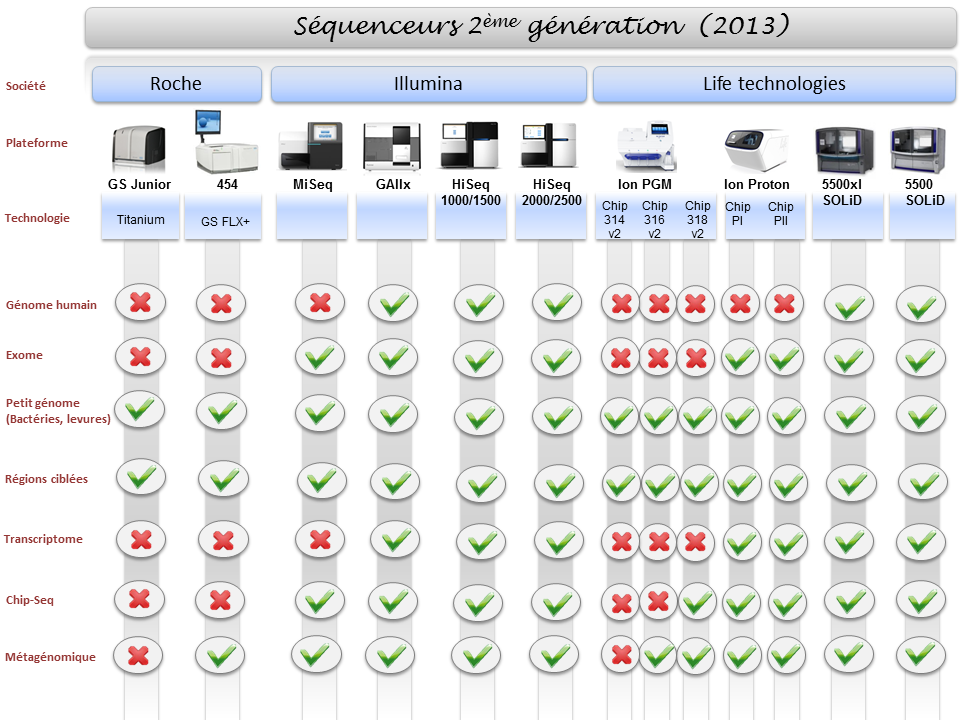

La diversité du parc technologique des séquenceurs de deuxième génération n’est plus une surprise pour personne. Ceci étant, il devenait indispensable de mettre à jour l’ensemble des informations postées sur ce site, il y a exactement deux ans (2011), faisant un état de l’art des différentes caractéristiques technologiques des séquenceurs, ainsi que les possibles applications biologiques associées.

Pour ne mentionner que les trois plus gros fournisseurs du marché, les sociétés Roche, Illumina et Life Technologies n’ont cessé de faire évoluer leur gamme, tant sur le plan des équipements que sur le plan des capacités de séquençage.

Par voie de conséquence, ce survol est l’occasion de refaire le point sur les technologies appropriées selon l’application biologique recherchée. A noter que le Ion proton, dernier en date sur le marché des séquenceurs de deuxième génération disposera au cours de l’année 2014 d’une puce « PIII » permettant de générer environ 64Gb. Cette capacité de séquençage permettra à Ion torrent de se positionner sur le séquençage de génome humain à partir d’un séquenceur de paillasse et accèdera ainsi à la gamme complète des applications citées ci-dessous.

Bertrand Jordan a eu son doctorat en physique nucléaire à 1965 et a très bien fait de se convertir à la biologie moléculaire. Entre autres choses, il a réalisé en 1982 l’isolement du premier gène d’histocompatibilité humain, et en 2000, il a fondé la Génopole de Marseille. Bertrand Jordan est membre de l’Organisation européenne de biologie moléculaire (EMBO) ainsi que de l’organisation internationale HUGO (Human Genome Organisation).

Mais surtout, et c’est ce qui nous intéresse ici, l’auteur de plus de 150 publications scientifiques fait œuvre de vulgarisation et offre depuis plus de dix ans, des chroniques génomiques publiées au sein de la revue Médecine / Sciences. Ces chroniques sont accessibles gratuitement (vous pouvez y accéder directement sur le site de www.medecinesciences.org ou en cliquant sur l’image ci dessus en haut à gauche).

On peut vous conseiller de lire le point de vue de Bertrand Jordan sur les séquenceurs haut-débit dans sa chronique de mars 2010 intitulée : le boom des séquenceurs nouvelle génération, sans oublier le point de vue partagé (parfois longtemps après lui) par un nombre croissant de chercheurs sur les GWAS, dans sa chronique de mai 2009 : le déclin de l’empire des GWAS. C’est là tout l’intérêt de ces chroniques qui, bénéficiant d’un propos clair, simple, construit, argumenté et rare, permettent de prendre un peu de recul sur les applications d’une science qui n’ont pas toujours tenu leurs promesses. Ces chroniques peuvent être l’occasion de faire tomber le masque, de dégonfler l’air de ces vessies qui se prennent parfois pour des lanternes.

Bertrand Jordan, chroniqueur mais aussi auteur de quelques livres aux titres évocateurs, parfois mémorablement provocateurs :

Voyage autour du Génome : le tour du monde en 80 labos. Editions Inserm/John Libbey, Paris, 1993

Voyage au pays des gènes. Editions. Les Belles Lettres/ Inserm, Paris, 1995

Génétique et génome, la fin de l’innocence. Editions Flammarion, Paris, 1996

Les imposteurs de la génétique. Editions du Seuil, Paris, 2000 (Prix Roberval Grand Public 2000)

Le chant d’amour des concombres de mer. Editions du Seuil, Paris, 2002

Les marchands de clones. Editions du Seuil, Paris, 2003

Chroniques d’une séquence annoncée. Editions EDK, Paris, 2003

Le clonage, fantasmes et réalité. Essentiel Milan, Editions Milan, 2004

Thérapie génique : espoir ou illusion ? Editions Odile Jacob, Paris, 2007

L’humanité au pluriel : la génétique et les questions de race. Le Seuil, collection Sciences ouvertes, Paris, 2008

Autisme, le gène introuvable : Le Seuil, Paris, 2012

Dans la forme, cette vidéo (en anglais) se veut humoristique mais le fond est assez sérieux puisqu’il montre ce qui ne devrait pas arriver quand un scientifique effectue une demande (courtoise) de partage de données : Un enchainement d’échanges souvent à la limite de l’absurde reflet d’une situation malheureusement assez commune dans le domaine de la science.

Auteurs : Karen Hanson, Alisa Surkis and Karen Yacobucci

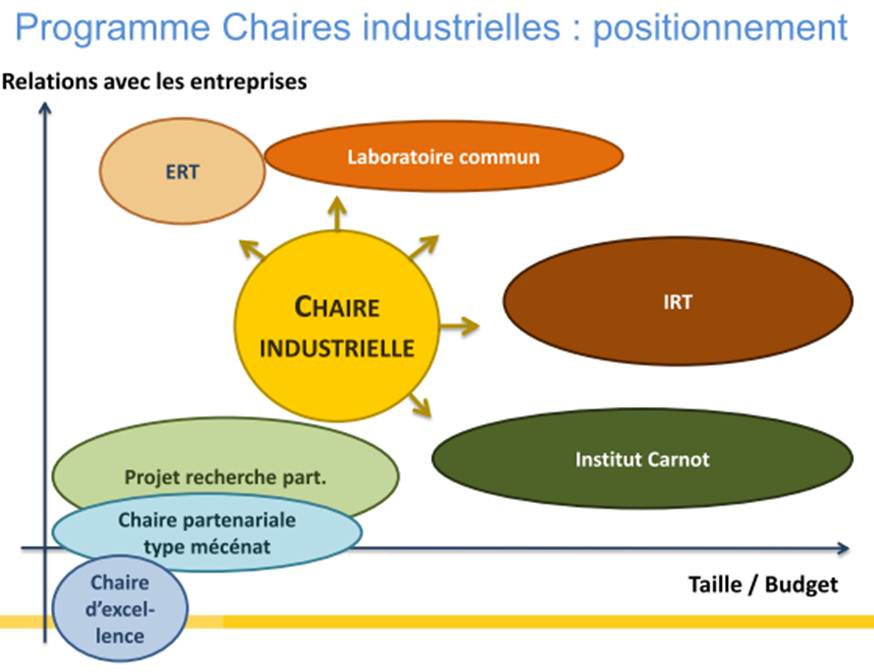

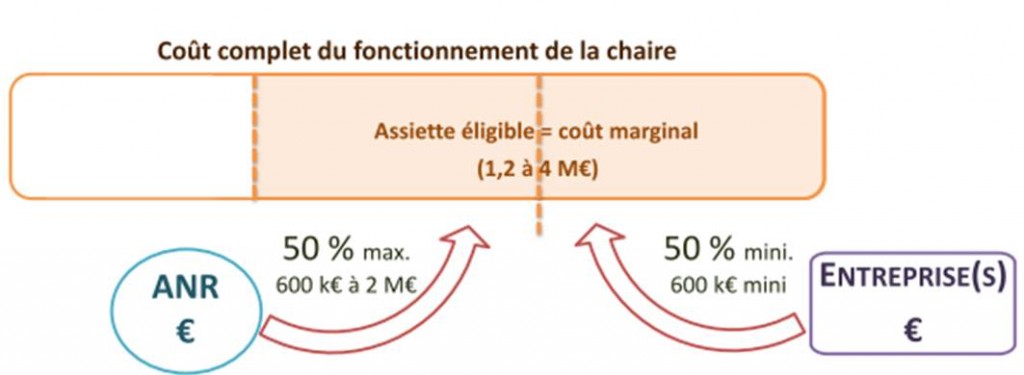

Lors d’une réunion le 21 mai dernier à Lille, Lionel Choplin, responsable du programme chaires industrielles venait présenter les ambitions de l’ANR pour associer le secteur privé –le co-financier et bénéficiaire des fruits de la valorisation de la recherche- et le secteur public –le pourvoyeur de cerveaux (de préférence provenant d’une grande université étrangère) et de structure d’accueil. Vous trouverez la présentation en suivant ce lien.. Ce programme est très largement inspiré du PCI canadien (Professeurs-Chercheurs Industriels) du CRSNG (Conseil de Recherches en Sciences Naturelles et en Génie du Canada) qui « offre » trois types de subventions :

- professeur-chercheur industriel principal pour les chercheurs principaux distingués (subvention renouvelable d’une durée de cinq ans);

- professeur-chercheur industriel agrégé pour les chercheurs en début de carrière qui démontrent un potentiel exceptionnel (subvention renouvelable une fois d’une durée de cinq ans);

- professeur-chercheur industriel cadre pour les professionnels exceptionnels de la recherche et développement (subvention non renouvelable d’une durée de cinq ans).

Dans sa version française, la subvention est clairement destinée aux deux premiers cas mentionnés ci-dessus. Ainsi la relation industriels-organismes de recherche devient plus monodirectionnelle. L’industriel lève des fonds (le ticket d’entrée étant de 600 k€ minimum sur 4 ans), l’ANR abonde d’autant (la stratégie du quitte ou double), la structure d’accueil hébergeant le titulaire de la chaire assure son bon fonctionnement (sachant que l’investissement en gros équipement est limité à 20 % de l’assiette). Le titulaire de la chaire ainsi que la structure d’accueil bénéficient de ce financement, l’industriel, quant à lui, aura un retour en terme d’image, de retombées sous forme de Propriété Intellectuelle et surtout en terme de connaissances sur un sujet qui est censé impacter sa croissance.

Le schéma ci-dessous reprend le positionnement relatif de la chaire industrielle par rapport aux autres programmes de l’ANR.

Par ce type de programmes, l’ANR vise plusieurs objectifs :

– Créer une dynamique à partir d’une offre de compétences et d’expertise en adéquation avec les besoins des acteurs du monde socio-économique

– Organiser les recherches dans une logique d’exploitation des résultats de recherche

– Insuffler au sein de l’établissement d’accueil une dynamique de recrutement de qualité dans un cadre de développement concerté fort

– Permettre un échange en temps réel de technologies et de savoir-faire entre les acteurs publics et privés de la recherche

– Assurer des retombées en termes d’image, résultant de l’accueil d’éminents enseignants-chercheurs au plan international

– Participation des acteurs publics au développement de produits innovants

– Mise en place de modèles économiques construits sur l’économie de la connaissance

Ce programme est comme beaucoup, critiquable, certainement imparfait mais il a le mérite d’afficher la volonté étatique de concilier secteur privé et secteur public, les industriels et les structures d’accueil… dans une relation plus équilibrée que de coutume afin que ces deux acteurs tirent bénéfice de cette relation. Rappelons ici que même aux États-Unis, souvent cités en exemple, les partenariats universités-entreprises restent modestes : 6 % des dépenses réalisées en 1999, au plus fort de la bulle Internet, depuis, cette part est redescendue à 4 %.

Cet article est l’occasion de revenir sur un changement notable dans la politique d’évaluation de la recherche scientifique française, une politique légèrement moins ancrée sur la productivité bibliométrique, replacée dans l’écosystème économique et social. Une première réponse aux différentes critiques et notamment celle de Yehezkel Ben-Ari formulée dans sa tribune du Monde datée du 16 décembre 2011 : « Shanghai et l’évaluation technocratique tuent la recherche biomédicale ! ». L’évaluation étant le nœud gordien du problème un début de réponse peut être contenu dans cette reprise d’une dépêche de l’AEF. Celle-ci mérite d’être diffusée… et mérite aussi la faveur d’une opinion…

Dépêche n°166899, Paris, mardi 22 mai 2012

L’Aeres adopte six critères d’évaluation des entités de recherche, au lieu de quatre.

L’Aeres (Agence d’évaluation de la recherche et de l’enseignement supérieur) « a récemment étendu à six le nombre de ses critères » d’évaluation des entités de recherche, indique-t-elle dans un document intitulé « Critères d’évaluation des entités de recherche : le référentiel de l’Aeres », approuvé par le conseil de l’agence le 12 avril 2012 et rendu public mardi 22 mai 2012. Les nouveaux critères retenus sont les suivants : « production et qualité scientifiques ; rayonnement et attractivité académiques ; interactions avec l’environnement social, économique et culturel ; organisation et vie de l’entité de recherche ; implication dans la formation par la recherche ; stratégie et projet à cinq ans ». Ces critères seront mis en oeuvre « lors de la campagne d’évaluation 2012-2013 ». Ils se substituent aux quatre critères employés depuis 2008, qui étaient « la qualité scientifique et la production ; le rayonnement et l’attractivité ; la gouvernance et la vie de l’entité de recherche ; la stratégie et le projet ». Cette évolution vient en complément de l’abandon de la note globale, en décembre 2011 (AEF n°159690). L’agence avait alors indiqué vouloir « maintenir les notes associées aux différents critères », tout en affichant son intention de « réviser » ces critères, « pour les améliorer ».

Cette extension des critères d’évaluation répond à des améliorations qui ont été « suggérées dans deux domaines », explique l’Aeres. Il en va ainsi des « activités qui relèvent de la recherche finalisée » et des « activités d’expertise venant en appui des politiques publiques » : « Celles-ci n’étaient pas reconnues et valorisées par l’agence dans la déclinaison de son référentiel en quatre critères », indique-t-elle. « L’introduction du critère ‘interactions avec l’environnement social, économique et culturel’ (…) vise à les intégrer pleinement parmi les activités évaluées. » « Le second domaine est celui de la formation par la recherche qui, dans le référentiel à quatre critères, n’était qu’un élément parmi d’autres du critère ‘gouvernance et vie de l’entité de recherche’ », poursuit l’agence. « Pour donner à la formation toute sa place dans les missions assignées aux entités de recherche, il a paru nécessaire, là encore, de traiter celle-ci comme un critère à part entière. »

CHAMP D’APPLICATION, FAITS OBSERVABLES ET INDICES DE QUALITÉ

L’Aeres souligne aussi que ce nouveau référentiel « répond plus nettement aux attendus de la loi de programme pour la recherche de 2006 », qui définit la « mission d’intérêt national » des personnels de la recherche comme comprenant : « le développement des connaissances ; leur transfert et leur application dans les entreprises, et dans tous les domaines contribuant au progrès de la société ; la diffusion de l’information et de la culture scientifique et technique dans toute la population, et parmi les jeunes ; la participation à la formation initiale et continue ; l’administration de la recherche ; l’expertise scientifique. »

Chacun des six critères est lui-même décomposé en trois aspects : son « champ d’application », les « faits observables » et les « indices de qualité ». Le « champ d’application » d’un critère « résume les aspects que l’évaluateur doit apprécier, en des termes généraux pour tous les types d’entités de recherche et pour tous les domaines ». Par exemple, le critère « production et qualité scientifiques », tel qu’il est défini dans le référentiel, « apprécie, par rapport aux standards de la discipline et du domaine de recherche, les découvertes, les résultats, les problématiques, les faits expérimentaux conduisant à des réalisations scientifiques ». Le document précise qu’ « il apprécie également l’originalité, la qualité et la portée de la recherche ». Les « faits observables » désignent pour leur part « des données factuelles qui peuvent être observées par les évaluateurs pour étayer leur appréciation ». Quant aux « indices de qualité », il s’agit de « la valeur à accorder à ces données pour élaborer l’appréciation proprement dite ».

UN DOCUMENT COMPLÉMENTAIRE SUR LA NOTATION VA ÊTRE PRÉPARÉ

Le « référentiel » de l’Aeres rappelle que ces critères « s’appliquent non seulement aux entités de recherche », mais aussi à leurs « composantes » : les équipes internes et les thèmes. En conséquence, « chaque critère est donc noté non seulement au niveau de l’entité de recherche, mais aussi, lorsque celle-ci est structurée en équipes internes, au niveau de ces équipes ». En revanche, les thèmes ne sont pas notés, « dans la mesure où ils ont en général un caractère transversal et où ils réunissent des personnels appartenant à plusieurs équipes internes d’une même entité de recherche ». L’agence indique qu’il reste à « lier étroitement la définition des critères et l’échelle de notation », autrement dit qu’ « à chaque note doit correspondre un niveau de qualité, dont la définition doit être précisée ». « Ces éléments feront l’objet d’un document méthodologique complémentaire » qui sera rendu public « avant le lancement de la campagne d’évaluation 2013-2014 », annonce-t-elle.

L’évolution des critères d’évaluation « a intégré les propositions recueillies auprès des responsables d’entités de recherche évaluées et de leurs évaluateurs », précise l’Aeres. « Elle a également pris en considération les réflexions méthodologiques conduites par plusieurs groupes de travail (…) et par d’autres agences européennes », tout en ayant « tiré parti des recommandations de dernier rapport de l’Opecst (Office parlementaire d’évaluation des choix scientifiques et technologies) » (AEF n°161145). L’agence précise qu’ « avant d’être rendu public, ce document a été soumis à la direction d’un grand nombre d’organismes de recherche et à la CPU (Conférence des présidents d’université) ». En outre, ajoute-t-elle, « à l’issue de chaque campagne d’évaluation, l’agence procédera à un retour d’expérience qui permettra aux évalués d’apporter les contributions qu’ils jugeront utiles à l’amélioration de la réflexion en cours ».

ÉVALUER L’INTERDISCIPLINARITÉ ET LES SHS

Le document comporte aussi les résultats d’un « travail sur la méthodologie d’évaluation de l’interdisciplinarité et sur les critères adéquats pour apprécier équitablement ce type de recherche », selon que l’on parle de « pluridisciplinarité » (« juxtaposition de perspectives disciplinaires »), d’ « interdisciplinarité » (« coopération de plusieurs disciplines autour de projets communs ») ou de « transdisciplinarité » (« approche scientifique qui dépasse les points de vue disciplinaires par l’approche globale d’une question »). Pour l’Aeres, si « les critères d’évaluation des entités de recherche pluri, inter ou transdisciplinaires ne sont pas différents de ceux auxquels on recourt pour évaluer des entités monodisciplinaires », il s’avère néanmoins « nécessaire de dégager les faits observables propres aux différentes formes d’interaction des disciplines et les indices de qualité correspondants ». Un « groupe de réflexion » travaille à ces questions, mais d’ores et déjà, l’agence considère que « deux marqueurs » peuvent nourrir l’évaluation de l’interdisciplinarité : « le type d’interaction et la proximité entre les disciplines qui interagissent ».

Enfin, le document de l’Aeres présente « une note complémentaire sur la production et la qualité scientifiques en sciences humaines et sociales ». Il ne s’agit pas d’ « un autre référentiel », avertit l’agence, dans la mesure où les six critères élaborés offrent déjà « un référentiel commun qui intègre les perspectives des sciences humaines et sociales, au même titre que les autres, et peut, le cas échéant, s’y adapter ». Il s’agit plutôt de « quelques précisions aux faits observables et aux indices de qualité » relatifs au seul critère de « production scientifique », « pour intégrer au mieux la variété des formes de publication et des autres productions scientifiques en sciences humaines et sociales, mais aussi la diversité relative des langues qui sont utilisées pour la recherche dans ce domaine ». L’Aeres propose ainsi des repères pour « la caractérisation des revues » et « la caractérisation des ouvrages scientifiques », accompagnés des « principes de révision des listes de revues en sciences humaines et sociales » et d’une définition de ce que l’agence considère comme relevant d’un « véritable travail d’édition scientifique » des actes de colloques et des ouvrages collectifs.

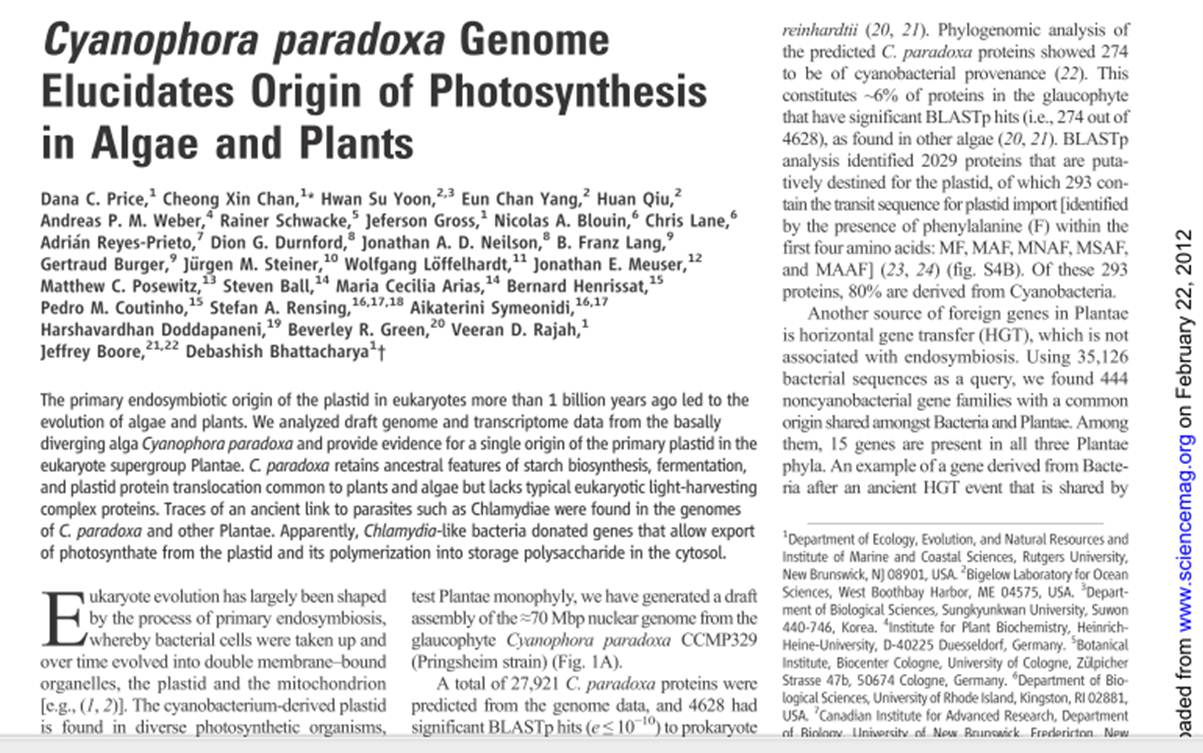

Cet article revient sur une publication de janvier 2012 de Science (voir image ci-dessous) qui exploite des données de biologie haut-débit pour répondre à deux questions biologiques liées : « comment a été permise la photosynthèse ? » – « toutes les plantes ont elles un ancêtre commun?«

Les auteurs exploitent des données génomiques et transcriptomiques d’un glaucophyte : Cyanophora paradoxa. Cyanophora paradoxa est le biflagellé le plus étudié des glaucophytes, pris pour modèle dans l’étude de l’endosymbiose et pour ce qui a trait à la fonction du proplaste à l’origine des chloroplates.

Ces proplastes ayant pour origine l’intégration par endosymbiose d’une cyanobactérie (les mitochondries quant à elles, ayant pour origine l’endosymbiose d’une alpha-protéobactérie). L’intégration de ces données apporte la preuve que toutes les plantes seraient issues d’un seul ancêtre commun: les plantes formeraient une lignée monophylétique.

Il y a plus d’un milliard d’années a eu lieu la rencontre entre une cyanobactérie et une cellule eucaryote : de cette rencontre a émergé des cellules capables d’exploiter la lumière solaire pour synthétiser de la matière organique. L’étude présentée ici distingue :

– les EGT (Endosymbiotic Gene Transfer) avec les échanges de gènes entre le génome de l’hôte et celui de la cyanobactérie initiale venant grandement enrichir le génome de cet hôte. La participation des gènes de cyanobactérie représenterait entre 6 % (pour Chlamydomonas reinhardtii) et 18 % (pour Arabidopsis thaliana). Chez C. paradoxa, 274 gènes semblent avoir une origine cyanobactérienne. L’étude de la séquence mitochondriale a permis de positionner les glaucophytes très près du point de divergence des algues vertes et rouges.

– une autre source d’apport de matériel génétique venant enrichir ce système : les transferts de gènes horizontaux (HGT). Les auteurs dénombrent 15 gènes qui sont partagés par les 3 taxons de plantes à l’origine d’une diversité de plantes, et qui auraient une origine bactérienne – des séquences proches de celles retrouvées chez des Chlamydiae et Legionella, des parasites intracellulaires de cellules eucaryotes.

Ainsi les gènes apportés par le parasite ont permis au couple cyanobactérie-cellule de fournir des gènes nécessaires aux échanges de « nourriture » (UhpC-type hexosephosphate transporters, des sous-unités de translocons). Cette étude démontre que ces échanges de gènes ont une signature unique chez les plantes, les algues et les glaucophytes confortant la thèse d’une lignée végétale monophylétique, un coup porté aux tenants de la thèse de la « paraphylie végétale ».

Cet article de Science est un bel exemple de l’exploitation, de l’intégration et enfin de l’interprétation donnant sens aux données génomiques et transcriptomiques générées à haut-débit (des données de transcriptomiques -réalisées sur la plateforme Illumina GAIIx- sont disponibles dans la banque du NCBI : Sequence Read Archive avec les n° d’accès suivants SRX104482, SRX104481, SRX104480).

La confusion entre mate-pair et paired-end, tant au niveau technologique (selon qu’on lise les notes techniques d’Illumina, de Roche ou de Life) que logiciel nous a mené à rédiger, en collaboration avec Ségolène Caboche, Bioinformaticienne à l’université de Lille2, une note technique dont le contenu est résumé ci-dessous :

– Genèse de la confusion entre mate-pair et paired-end

– Descriptions les deux approches, avec un focus sur les principales technologies de seconde génération de séquenceurs

– Traitement au niveau logiciel et conseils généralistes pour l’utilisation

Le document est consultable dans son intégralité sur notre blog :

Télécharger Paired-end versus mate-pair

Bonne lecture!

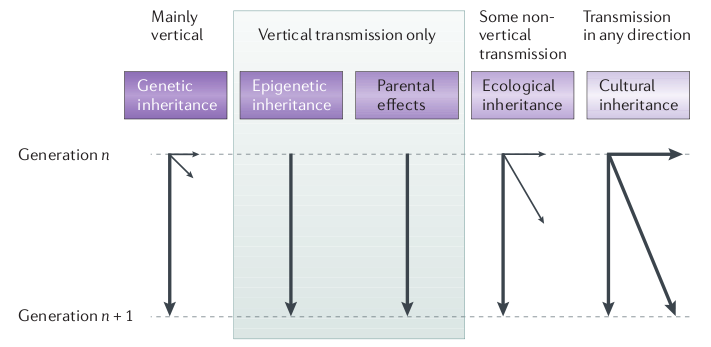

Pierre Barthélémy, journaliste scientifique au monde, a publié hier sur son blog (passeurdesciences.blog.lemonde.fr) une interview de Etienne Danchin (directeur de recherche CNRS et directeur de l’EDB) qui nous parle de la nécessité de s’extraire du dogme du « tout-génétique » pour s’intéresser plus précisément à d’autres mécanismes qui régissent l’hérédité, tel que l’épigénétique, l’hérédité culturelle et environnementale.

Vous pouvez retrouver l’interview dans son intégralité ici :

Cette interview fait suite à la publication d’une synthèse sur l’hérédité non génétique et son rôle dans l’évolution parue dans Nature Reviews Genetics en Juillet 2011 que vous pouvez consulter en intégralité ici.

Etienne Danchin n’est pas le seul à s’interroger sur la part réelle de la génétique dans les mécanismes de l’hérédité, nous vous conseillons une nouvelle fois l’excellente émission de Jean Claude Ameisen (à écouter dans ce post) qui aborde ces aspects de la transmission génétique et non génétique, entre générations.

L’hérédité culturelle est une composante en général peu discutée (notamment dans le domaine animal): quelle est la part de variation phénotypique qui peut être expliquée par une transmission sociale (ou transmission par apprentissage)? A noter que le rôle de la composante culturelle dans l’hérédité a été formalisé dans les années 1970, ça ne date donc pas d’hier, mais comme toutes les composantes non génétiques impliquées dans l’hérédité elle s’est retrouvée minimisée, voire ignorée, au profit de la composante génétique.

Quoi qu’il en soit, à l’heure de l’arrivée de la 3eme génération de séquenceur haut-débit et de la génération toujours plus astronomique de données génomiques, il est toujours bon de rappeler que le seul transfert de gènes n’explique qu’une proportion des mécanismes étudiés.

Pierre Barthélémy, journaliste scientifique à publié hier sur son blog (passeurdesciences.blog.lemonde.fr) une interview de Etienne Danchin (directeur de recherche CNRS) qui nous parle de la nécéssité de sortir du dogme du « tout-génétique » pour s’intérésser plus précisement à d’autre mécanisme qui régisse l’hériédité, l’épigénétique, l’hérédité génétique et environementale.

Vous pouvez retrouver l’interview dans son intégralité ici :

Cet interview est le résultats d’une synthèse sur l’hérédité non génétique et son rôle dans l’évolution publié dans Nature Reviews Genetics en Juillet 2011 que vous pouvez consulter en intégralité ici.

Etienne Danchin n’est pas le seul à s’intéroger sur la place réelle de la génétique dans les mécanisme de l’hérédité, nous vous conseillons une nouvelle fois l’excellente émission de Jean Claude Ameisen (à écouter dans ce post).

Les scientifiques seraient ils des parangons de vertu ? Comment et pourquoi les imposteurs travestissent la vérité en la parfumant de sciences et de techno-science ? C’est à ces questions que répond clairement Michel de Pracontal dans un ouvrage (ici ré-édité) publié, pour la première fois, il y a plus de 20 ans. Dans sa version de 2001, en quelques 332 pages le journaliste scientifique oeuvrant pour le Nouvel Observateur et Mediapart (son blog est totalement recommandable) réalise un manuel de référence pour tout zététicien qui se respecte. Certes, ce manuel abordant Rika Zaraï, l’astrologie, l’homéopathie, l’affaire Baltimore, les oeuvres de moult scientifiques peu vertueux inventeurs de données frelatées tel un Cyril Burt, d’ imposteurs en herbe et de gourous scientistes avides, est parsemé d’humour grinçant, sardonique mais il est avant tout, même avec quelques maladresses, une ode à l’esprit critique utile à tous. Le livre est structuré en manuel avec un exercice en fin de chapitre permettant d’aiguiser son esprit critique et de se détacher de l’autorité scientifique qui va de soi… Les cas abordés sont pléthoriques, couvrent tout le spectre de l’escroquerie intellectuelle et scientifique… le lecteur peut être troublé ou amusé de voir mis sur le même plan l’astrologue et le physicien peu scrupuleux. Or l’origine de la fraude et la manière dont elle est crédibilisée ne sont pas les mêmes… le profane peut s’y perdre un peu.

Les scientifiques seraient ils des parangons de vertu ? Comment et pourquoi les imposteurs travestissent la vérité en la parfumant de sciences et de techno-science ? C’est à ces questions que répond clairement Michel de Pracontal dans un ouvrage (ici ré-édité) publié, pour la première fois, il y a plus de 20 ans. Dans sa version de 2001, en quelques 332 pages le journaliste scientifique oeuvrant pour le Nouvel Observateur et Mediapart (son blog est totalement recommandable) réalise un manuel de référence pour tout zététicien qui se respecte. Certes, ce manuel abordant Rika Zaraï, l’astrologie, l’homéopathie, l’affaire Baltimore, les oeuvres de moult scientifiques peu vertueux inventeurs de données frelatées tel un Cyril Burt, d’ imposteurs en herbe et de gourous scientistes avides, est parsemé d’humour grinçant, sardonique mais il est avant tout, même avec quelques maladresses, une ode à l’esprit critique utile à tous. Le livre est structuré en manuel avec un exercice en fin de chapitre permettant d’aiguiser son esprit critique et de se détacher de l’autorité scientifique qui va de soi… Les cas abordés sont pléthoriques, couvrent tout le spectre de l’escroquerie intellectuelle et scientifique… le lecteur peut être troublé ou amusé de voir mis sur le même plan l’astrologue et le physicien peu scrupuleux. Or l’origine de la fraude et la manière dont elle est crédibilisée ne sont pas les mêmes… le profane peut s’y perdre un peu.

Voici le quatrième de couverture : « Plus de 50 % des Français croient à la transmission de pensée et à la guérison par magnétiseur, près de la moitié fait confiance à l’astrologie, 35 % aux rêves prémonitoires. De l’horoscope sur Internet au phénomène « X-Files », de la mémoire de l’eau aux « paramédecines », de la réincarnation aux « expériences NDE », la patrie de Descartes se passionne plus que jamais pour l’irrationnel. Le progrès des sciences et des techniques s’accompagne d’un essor des pseudo-sciences et des fraudes scientifiques. Des savants renommés accréditent la téléportation et le voyage dans le temps. Des autodidactes inventifs proposent des théories « alternatives » à celles de Darwin et d’Einstein.

Loin d’être marginale, l’imposture scientifique est devenue une nouvelle norme intellectuelle. Baigné d’ondes positives, planant au-dessus des basses arguties de la raison, l’homme nouveau du xxte siècle goûtera-t-il le vrai bonheur ? Pour s’y préparer, voici l’indispensable manuel du pipeau et de la baliverne. Cet ouvrage vivant et didactique remet (totalement) à jour sa première édition, publiée en 1986. L’honnête citoyen comme l’apprenti charlatan y trouveront tous les conseils utiles, illustrés d’exemples concrets et d’anecdotes captivantes.

Le lecteur s’instruira en s’amusant, et apprendra comment départager le vrai du faux dans une culture surmédiatisée, régie par la dictature du marché et de l’audimat. Quand l’impact du message finit par l’emporter sur son contenu, le réel s’affaiblit. L’univers orwellien de 1984, où le charbon est blanc et où deux et deux font cinq, a cessé d’être une pure fiction. Contre un tel danger, la dernière arme est peut-être l’humour

Michel de Pracontal, 46 ans, est titulaire dune maîtrise de mathématiques et d’un doctorat en sciences de l’information sur la vulgarisation scientifique. Journaliste scientifique depuis vingt-deux ans (depuis 1990 au Nouvel Observateur), il est l’auteur de Les Mystères de la mémoire de l’eau (La Découverte, 1990) et de La Guerre du tabac (Fayard, 1998). » (table des matières).

Ce manuel est à placer entre le « petit cours d’autodéfense intellectuelle » de Normand Baillargeon et « gourous, sorciers et savants » de Henri Broch, deux ouvrages qui feront l’objet de chroniques futures.

Qui sommes nous?

Christophe Audebert [@]

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

Renaud Blervaque [@]

Biologiste moléculaire, chargé d'études génomiques.

Biologiste moléculaire, chargé d'études génomiques.

Gaël Even [@]

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Catégories

- Analyse de données (14)

- Automatisation (5)

- Bioinformatique (27)

- Biologie (56)

- biologie transverse (35)

- Biotechnologie (30)

- Chronique littéraire (8)

- Comparatif (6)

- Diagnostic (8)

- Economie (17)

- Epidemiologie (2)

- Evénement (17)

- Formation (3)

- Gestion de projet (5)

- Grille de calcul (1)

- Intégration (5)

- Logiciels (8)

- Médecine (14)

- politique de la recherche (17)

- Recherche (21)

- Séquençage (70)

- Séquenceur (39)

- Uncategorized (25)

- Workflow (4)

Accès rapide aux articles

- Covid-19 : zoom sur les vaccins

- Comment l’ADN pourrait être le stockage de données du futur

- COVID-19 : la data visualisation au service de la science

- COVID-19 : des explications et un point d’étape au 20 février 2020

- Pour mettre du vin dans son eau

- Des petits trous, toujours des petits trous…

- Qui serait candidat ?

- Un robot pour analyser vos données…

- Monde de dingue(s)

- L’art et la manière de développer une qPCR

- Un MOOC Coursera sur le WGS bactérien

- Chercheurs & enseignants-chercheurs, l’art du multitâche.

- Un jeu de données métagénomiques

- Facteur d’impact

- Microbiote & smart city : juxtaposition de tendances

Accès mensuels

- février 2021 (1)

- décembre 2020 (1)

- février 2020 (2)

- septembre 2019 (1)

- avril 2018 (2)

- décembre 2017 (1)

- novembre 2017 (2)

- juillet 2017 (2)

- juin 2017 (5)

- mai 2017 (4)

- avril 2017 (3)

- mars 2017 (1)

- janvier 2017 (2)

- décembre 2016 (3)

- novembre 2016 (4)

- octobre 2016 (2)

- septembre 2016 (2)

- août 2016 (3)

- juillet 2016 (2)

- juin 2016 (4)

- mai 2016 (3)

- mars 2016 (1)

- novembre 2015 (2)

- avril 2015 (1)

- novembre 2014 (1)

- septembre 2014 (1)

- juillet 2014 (1)

- juin 2014 (1)

- mai 2014 (1)

- avril 2014 (1)

- mars 2014 (1)

- février 2014 (3)

- janvier 2014 (1)

- décembre 2013 (5)

- novembre 2013 (2)

- octobre 2013 (2)

- septembre 2013 (1)

- juillet 2013 (2)

- juin 2013 (2)

- mai 2013 (4)

- avril 2013 (2)

- mars 2013 (1)

- février 2013 (3)

- janvier 2013 (2)

- décembre 2012 (2)

- novembre 2012 (2)

- octobre 2012 (2)

- septembre 2012 (2)

- août 2012 (1)

- juillet 2012 (3)

- juin 2012 (5)

- mai 2012 (5)

- avril 2012 (6)

- mars 2012 (6)

- février 2012 (8)

- janvier 2012 (6)

- décembre 2011 (5)

- novembre 2011 (6)

- octobre 2011 (6)

- septembre 2011 (7)

- août 2011 (5)

- juillet 2011 (8)

Pages