Le séquençage haut-débit voit cohabiter depuis quelques années deux générations de séquenceurs.

Au passage, une question Trivial Pursuit pour laquelle il faudra avoir un œil de caracal : quelqu’un sait quelle société a développé la première génération de séquenceurs haut-débit ? et quand ?

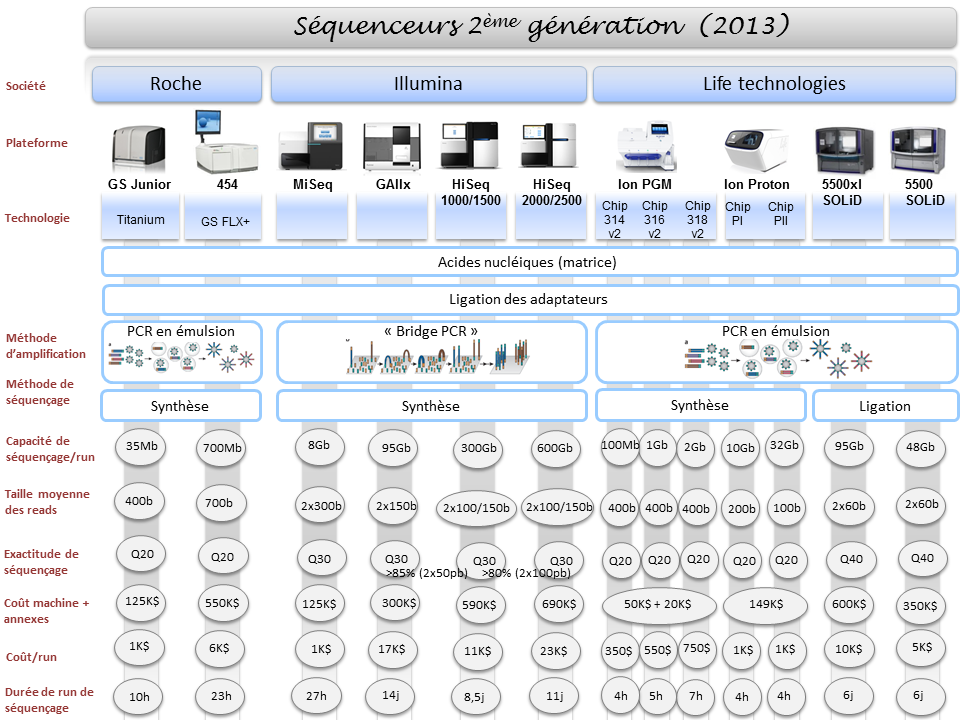

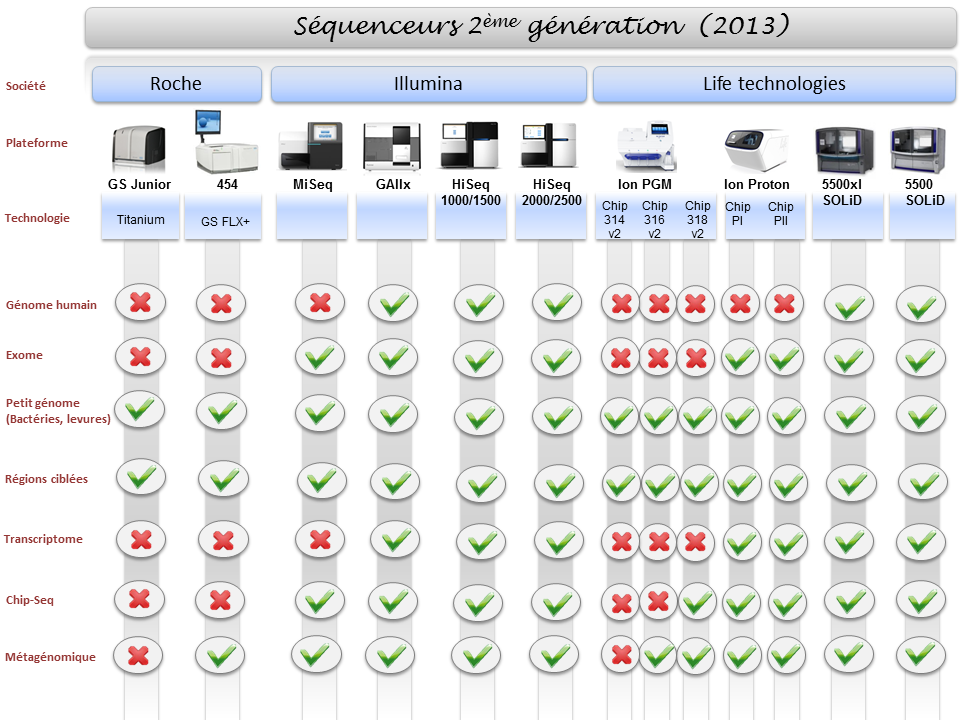

Les séquenceurs de deuxième génération se voient conditionnés sous forme de séquenceurs de paillasse (PGM de Ion Torrent, Miseq d’Illumina, GS-junior de Roche) permettant une démocratisation du séquençage, pendant que leurs grands frères pulvérisent la loi de Moore pour envisager un rendement (coût / Mb) toujours plus compétitif.

La large diffusion du séquençage de 3ème génération se laisse désirer laissant le champ libre à la génération précédente. Cet article vise à réaliser un court état des lieux du séquençage haut-débit de troisième génération : un futur plus ou moins lointain, de nouvelles applications potentielles.

La question : séquenceurs de 3ème génération, l’âge de raison, c’est pour quand ? est l’interrogation qui a hanté l’AGBT 2013 marqué par le silence d’Oxford Nanopore. Cette année 2013 fut marquée par le retrait d’Illumina du capital de la société britannique : « Oxford Nanopore Technologies Ltd a annoncé la vente d’une participation détenue par son concurrent américain Illumina Inc., une étape vers la fin d’une relation pleine de conflits dans la course au développement des séquenceurs haut-débit permettant de séquencer plus rapidement et pour moins cher. »

Avant de caractériser ce que sont, seront, pourront être les 3ème générations de séquenceurs, commençons par un rapide tour des caractéristiques générales de leurs prédécesseurs et principalement de ce qui constitue leurs points faibles :

– la phase d’amplification clonale (réalisée par PCR) est source de biais (doublons, erreurs de PCR)

– les problèmes liés au déphasage engendrant une chute de la qualité le long du read produit (ce qui bride la production de reads vraiment longs)

-des reads courts (de moins d’une centaine à environ 800 bases – vous l’aurez noté ce point est en partie une conséquence du précédent)

-des machines et des consommables onéreux

– des temps de run longs

Ainsi l’objectif principal des séquenceurs de 3ème génération est de palier les défauts de leurs aînés en produisant des reads plus longs, plus vite pour moins cher. Les séquenceurs de 2ème génération, quels que soient leurs modes de détection (mesure de fluorescence, mesure de pH) sont trop peu sensibles pour envisager la détection d’une simple molécule, d’un simple nucléotide : nécessairement la librairie doit être amplifiée, ce qui provoque des biais, des temps de préparation relativement longs et l’usage de consommables qui impacte le coût final de séquençage… assez rapidement la qualité chute plus vos reads s’allongent ce qui oblige à brider les tailles de reads que ces technologies sont capables de délivrer. En outre, travaillant sur une matrice qui est une copie de votre librairie initiale, l’information portée par les bases méthylées est perdue (ceci oblige à ajouter une phase de traitement au bisulfite qui peut être hasardeuse)

Actuellement l’une des seules technologies de 3ème génération réellement utilisée est celle de Pacific Biosciences (les hipsters disent « PacBio »). La firme, fondée en 2004, a lancé en 2010, son premier séquenceur de troisième génération le Pacbio RS basé sur une technique de séquençage SMRT (Single Molecule Real Time sequencing.) Aujourd’hui la société Roche qui n’a pu absorber Illumina lors de son OPA, a investi 75 millions de USD, le 25 septembre 2013, pour co-développer des kits diagnostiques in vitro exploitant la technologie de PacBio.

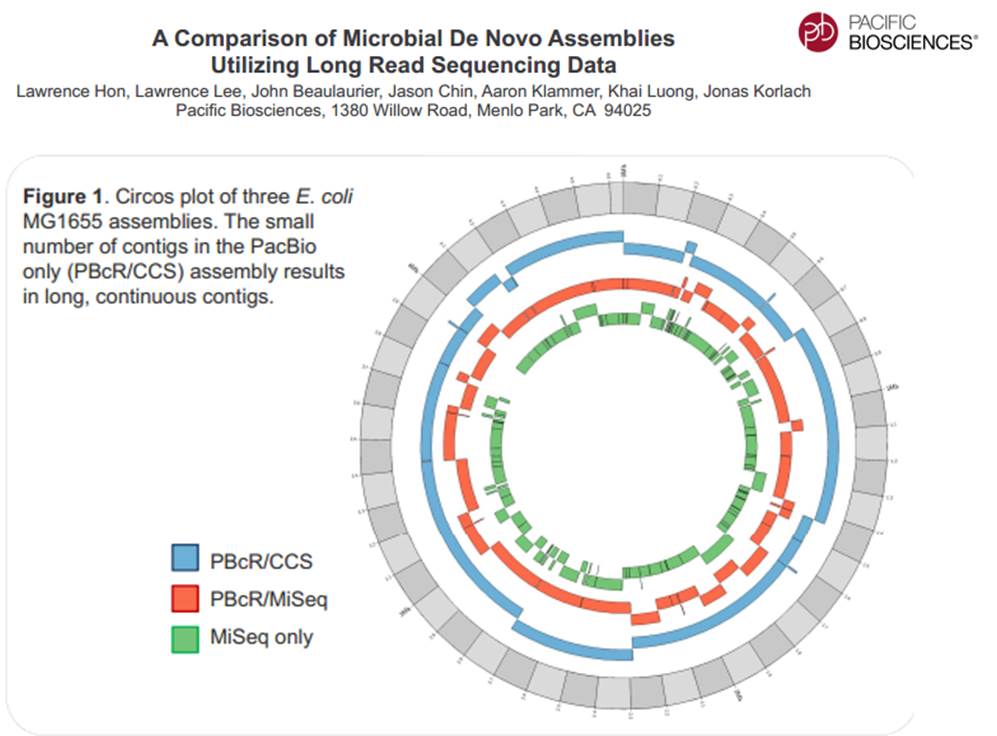

La technologie de PacBio est aujourd’hui exploitée pour réaliser du séquençage de novo de petits génomes :

Avec ces 200 à 300 Mb délivrés par SMRT-cell, séquencer des organismes eucaryotes supérieurs demande un investissement important, malgré tout, cette technologie délivrant des reads de plusieurs milliers de bases, permet d’envisager une diminution du nombre de contigs obtenus par les seules stratégies reads-courts / gros débit.

Face à la technologie proposée par PacBio, d’autres technologies essaient d’émerger pour arriver à occuper le marché du séquençage de 3ème génération :

– La combinaison détection optique et multipore est une voie envisagée pour le séquençage de 3ème génération avec le travail mené par NobleGen biosciences.

– L’imagerie directe de l’ADN

Le microscope électronique offre une résolution possible jusqu’à 100 pm, de sorte que les biomolécules et les structures microscopiques tels que des virus, des ribosomes, des protéines, des lipides, des petites molécules et des atomes même simples peuvent être observés. Bien que l’ADN est visible lorsqu’on l’observe avec un microscope électronique, la résolution de l’image obtenue n’est pas suffisamment élevée pour permettre le déchiffrement de la séquence, c’est à dire, le séquençage de l’ADN. Cependant, lors du marquage différentiel des bases de l’ADN avec des atomes lourds ou des métaux, un tel séquençage devient possible.

– Le séquençage à l’aide de transistor (Transistor-mediated DNA sequencing– une technologie développée par IBM)

Dans le système conceptualisé par IBM, l’ADN est contraint de passer par le pore à cause de la tension électrique subie, la vitesse de passage de la molécule à séquencer est maîtrisée à l’aide de contacts métalliques à l’intérieur du nanopore. La lecture des bases serait réalisée lors du passage de l’ADN simple brin au travers du pore (ça rappelle quelque chose…)

– Et Oxford Nanopore dans tout cela ? Si la société anglaise a annoncé la vente de la participation d’Illumina, elle a marqué l’année 2013 par son silence assourdissant. Passé l’oxymore, en cette fin d’année, coup de poker ou réel lancement, Oxford Nanopore propose un programme d’accès à sa technologie Minion où pour 1000 USD, il est possible de postuler à l’achat des clés USB de séquençage.

La stratégie d’Oxford Nanopore est basée, en partie, sur la possible démocratisation du séquençage de 3ème génération, elle s’oppose à celle de PacBio qui mise sur son arrivée précoce sur le secteur du séquençage haut-débit : décentralisation contre l’inverse. En clair, l’investissement d’un PacBio est tel que l’outil est réservé à des centres, des prestataires de services pouvant assumer cet investissement, ce qui oblige à centraliser les échantillons pour les séquencer, contre les produits (encore en développement) d’Oxford Nanopore dont la promesse est : le séquençage pour tous (ou presque).

PacBio revendique sa participation à un projet qui consiste à doubler la quantité de génomes bactériens « terminés » (actuellement de 2384) en quelques mois.

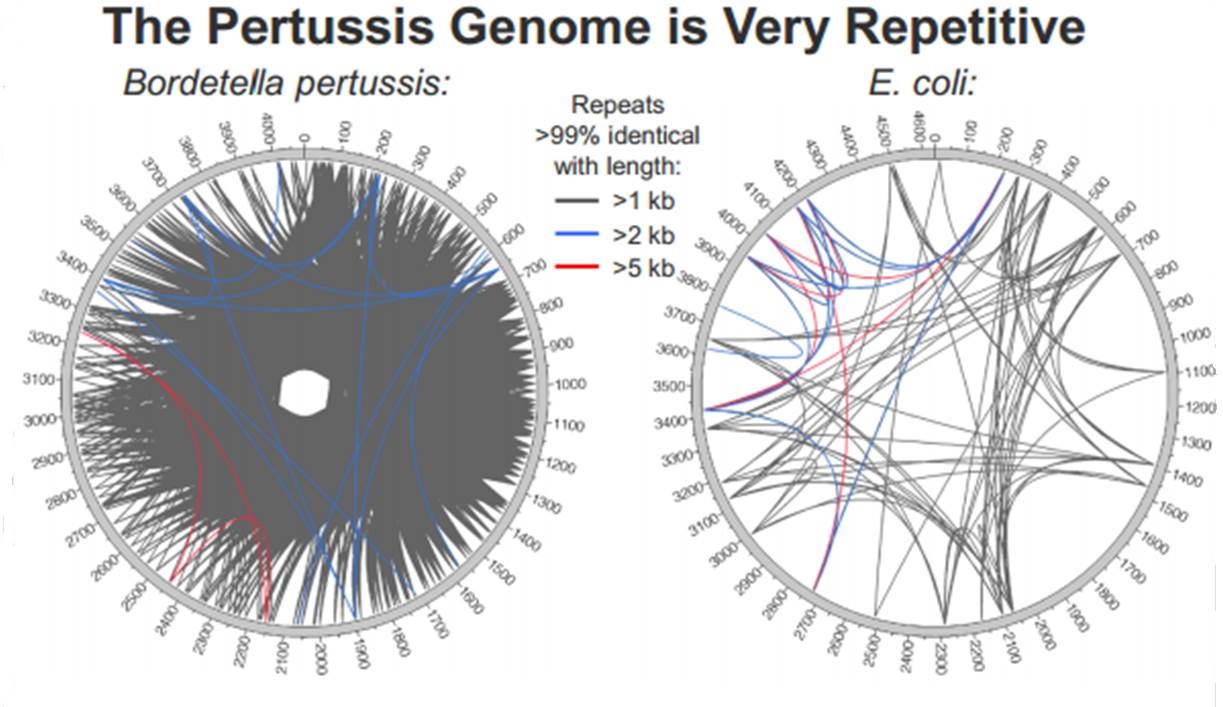

En cliquant ci-dessus sur la représentation graphique qui illustre la différence de plasticité de génome entre le génome d’une Bordetella pertussis (l’agent pathogène responsable de la coqueluche) et celui d’Escherichia coli, un poster vous apparaîtra. Ce dernier reprend les caractéristiques de l’utilisation de la technologie de PacBio à des fins d’assemblage de novo de génomes bactériens par une stratégie non-hybride (seuls des reads de PacBio sont utilisés). Les résultats sont assez bluffants, la longueur des reads de PacBio permet un assemblage complet (au prix de plusieurs SMRT cells tout de même !), de génomes bactériens « difficiles » tel que celui de Bordetella pertussis connu pour posséder un GC % relativement élevé (environ 65 %) ainsi que de nombreux éléments transposables. Les génomes possédant de nombreux éléments répétés posent de grandes difficultés d’assemblage, c’est un des arguments qui permet à PacBio de positionner sa technologie actuellement… en quelques mois les stratégies hybrides (reads courts générés par des séquenceurs de 2ème génération) ont laissé place aux stratégies non-hybrides où le séquençage PacBio se suffit à lui-même.

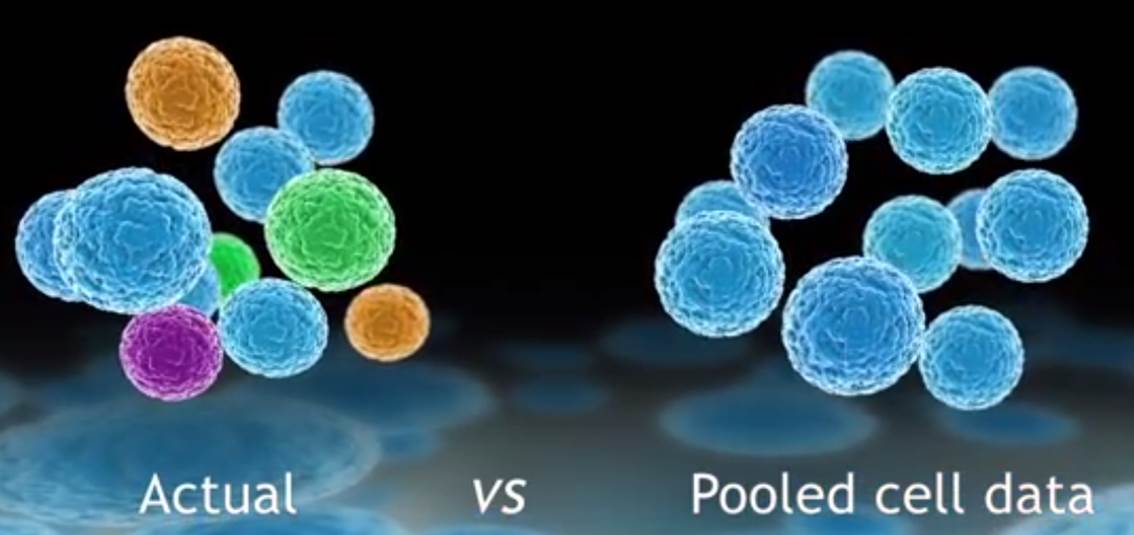

L’évolution des technologies de biologie moléculaire combinée à des systèmes de détection toujours plus sensibles, des techniques d’amplification accessibles dans des systèmes intégrés ont rendu possible l’analyse du transcriptome d’une cellule isolée. Dans de nombreux domaines tels que la cancérologie, la biologie des cellules souches, l’ingénierie des tissus, le signal moyen peut cacher la pertinence du signal noyé dans la masse des cellules d’intérêt.

Défier la loi de la moyenne, en tenant compte de l’hétérogénéité cellulaire pour tenter de capter ce signal qui échappe aux systèmes n’analysant que le mélange de cellules, est le credo du système proposé par Fluidigm : le C1™ Single-Cell Auto Prep System.

Isoler des cellules pour extraire leur ARN peut être une tâche technique ardue consommatrice de temps et très sensible aux contaminations.

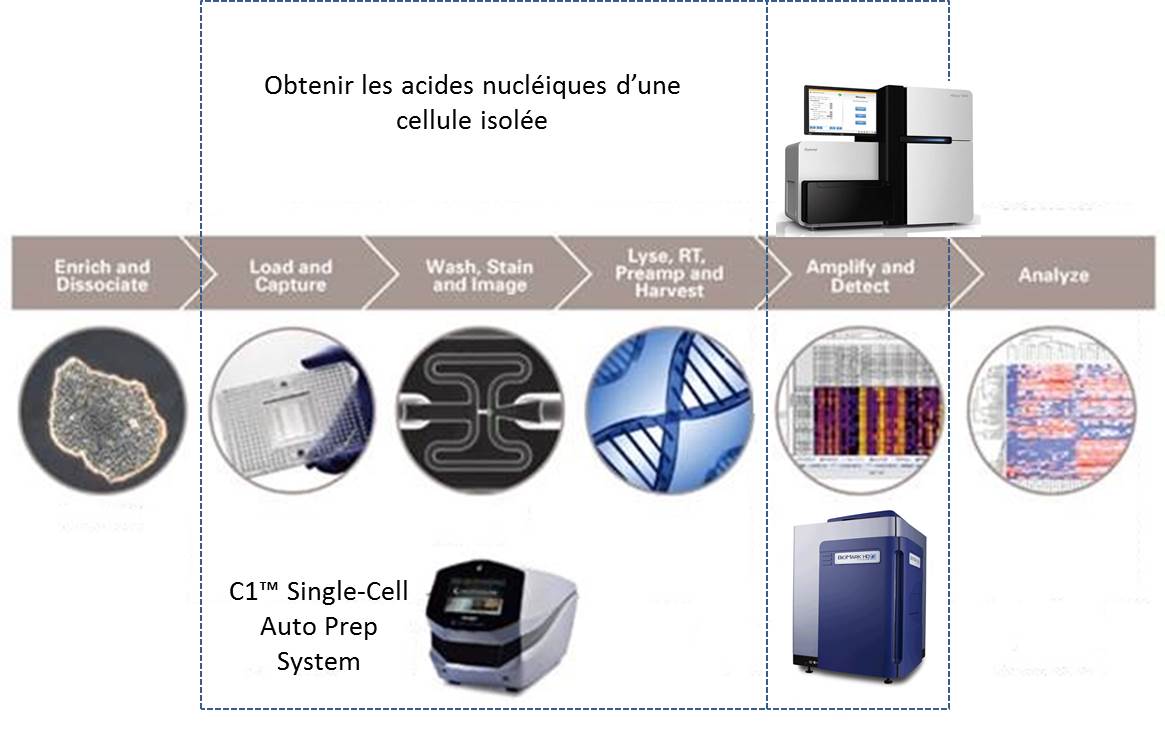

La société américaine, Fluidigm propose donc un système plutôt simple permettant de capturer quelques cellules pour en extraire leurs acides nucléiques. Le consommable est composé d’une plaque microfluidique comportant 96 pièges à cellules enchaînés. La multiplicité de ces pièges permet d’accroître les chances de capturer une cellule dans l’état escompté. Une fois la phase de capture accomplie, les divers pièges sont individualisés. Un système de by-pass permet de « pousser » chacune des cellules piégées dans une succession de « microréacteurs » isolés enchaînant phases de lyse, de transcription inverse, d’amplification des ARNs (WTA) et de collecte des acides nucléiques amplifiés.

Le schéma ci-dessous reprend les 2 phases principales permettant d’aboutir à l’analyse du transcriptome de cellules isolées :

(i) l’amplification d’ARN de cellules isolées

(ii) l’analyse de ces ARNs

Ainsi que le montre la vidéo promotionnelle ci-dessous le système est compact et se veut simple d’utilisation. Il va de soi, malgré tout, que pour optimiser vos chances de capturer un signal d’intérêt un marquage préalable cellules vivantes/mortes peut s’imposer. Ceci impose aussi d’observer la plaque microfluidique au microscope à fluorescence (en se hâtant quelque peu). Bien évidemment l’adjonction de marqueurs discriminants (anticorps couplés à un agent fluorescent) est la bienvenue.

Cette dernière vidéo aborde le « workflow » aboutissant à l’analyse du transcriptome monocellulaire par Biomark, il va de soi qu’il s’agit là d’une « suggestion de présentation » puisqu’il est possible d’analyser le transcriptome amplifié par le système C1™ Single-Cell Auto Prep System avec un grand nombre de systèmes de qPCR ou de séquençage haut-débit.

http://youtu.be/TF4NJRE4Xg4

L’analyse des biomarqueurs des cellules tumorales circulantes devient un élément majeur de la médecine personnalisée (lire L’enjeu des cellules tumorales circulantes). L’article d’Ashley A. Powell et al. (Single Cell Profiling of Circulating Tumor Cells: Transcriptional Heterogeneity and Diversity from Breast Cancer Cell Lines (Plos One, 2102)) montre l’application de ce système au niveau de l’analyse de « biopsie liquide« .

L’outil proposé par Fluidigm trouve d’ores et déjà des applications cliniques très concrètes : l’analyse de biomarqueurs des cellules tumorales circulantes à visée pronostique.

La diversité du parc technologique des séquenceurs de deuxième génération n’est plus une surprise pour personne. Ceci étant, il devenait indispensable de mettre à jour l’ensemble des informations postées sur ce site, il y a exactement deux ans (2011), faisant un état de l’art des différentes caractéristiques technologiques des séquenceurs, ainsi que les possibles applications biologiques associées.

Pour ne mentionner que les trois plus gros fournisseurs du marché, les sociétés Roche, Illumina et Life Technologies n’ont cessé de faire évoluer leur gamme, tant sur le plan des équipements que sur le plan des capacités de séquençage.

Par voie de conséquence, ce survol est l’occasion de refaire le point sur les technologies appropriées selon l’application biologique recherchée. A noter que le Ion proton, dernier en date sur le marché des séquenceurs de deuxième génération disposera au cours de l’année 2014 d’une puce « PIII » permettant de générer environ 64Gb. Cette capacité de séquençage permettra à Ion torrent de se positionner sur le séquençage de génome humain à partir d’un séquenceur de paillasse et accèdera ainsi à la gamme complète des applications citées ci-dessous.

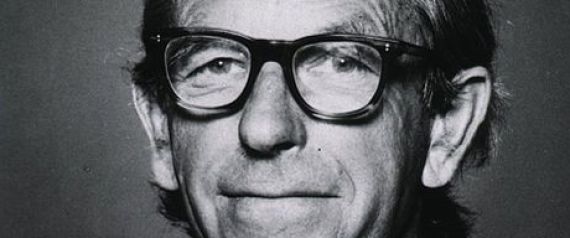

L’un des pionniers des séquences nucléique et protéique est décédé, il y a peu, le 19 novembre 2013, à l’âge de 95 ans. Il avait commencé sa thèse en octobre 1940 avec pour projet de rechercher une protéine consommable purifiée d’herbe (relativement abondante dans le royaume de Georges VI). C’est, au final, sous la direction d’Albert Neuberger (qui avait fuit l’Allemagne avec l’arrivée d’Hitler au pouvoir) que Frederick Sanger devient docteur en 1943.

Les deux hommes se respectaient, à propos de « son maître » Albert, Frédérick Sanger avait déclaré : « c’est Neuberger, qui le premier, m’a appris à faire de la recherche, à la fois techniquement et comme un mode de vie, et je lui dois beaucoup. »

L’homme qui a donné son nom à une technique de séquençage des nucléotides ouvrant la voie à un pan entier d’une science, à un institut de recherche (le Wellcome Trust Sanger Institute) employant plus de 900 personnes est une fierté (jamais anoblie) de l’empire britannique : une des quatre personnes à avoir reçu deux prix Nobel (prix Nobel de chimie). Son premier prix Nobel de chimie pour le séquençage de l’insuline (1958) sanctionne un travail de 10 ans. Rejoignant Crick (le penseur), au laboratoire de biologie moléculaire du Conseil médical de la Recherche à Cambridge, Sanger (le fonceur) se met à développer une technique de séquençage de l’ADN. Ce travail lui apportera son second prix Nobel en 1980.

« Quand j’étais jeune, mon père me disait que les deux activités les plus intéressantes dans la vie sont la recherche de la vérité et de la beauté, et je crois qu’Alfred Nobel a dû ressentir la même chose quand il a donné ces prix pour la littérature et les sciences.«

Un document reprenant le nécessaire à savoir sur l’oeuvre de Frederick Sanger (réalisé par Richard Daniellou, Enseignant-chercheur, ENSCR) est disponible au format pdf.

L’image en tête de cet article est issue d’un portrait de Frederick Sanger réalisé par Paula A. MacArthur (huile sur toile : 1991, collection: National Portrait Gallery de Londres).

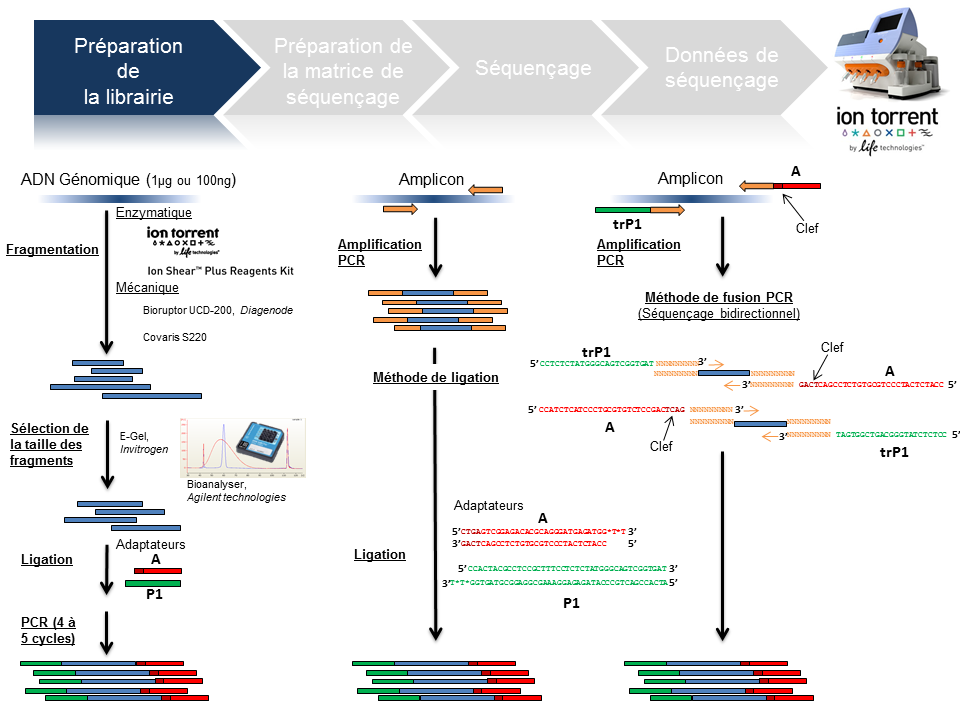

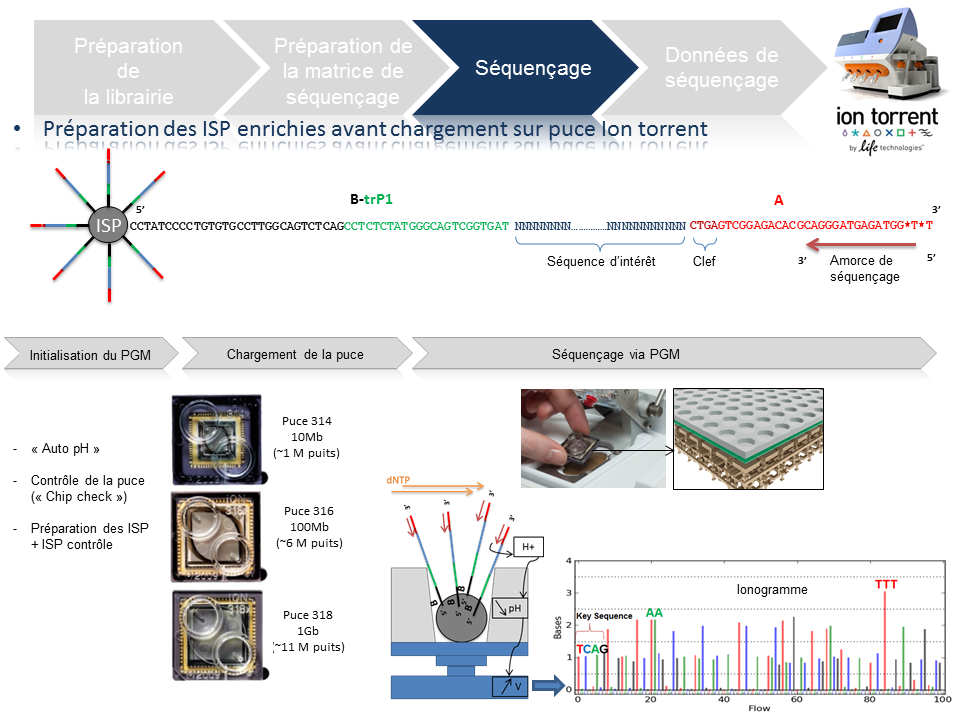

Ce poste a vocation de passer en revue les différentes étapes de la technologie de séquençage à haut-débit du PGM Ion Torrent, depuis la préparation de la librairie jusqu’à l’obtention des données brutes. Ce survol technologique permet de rassembler un maximum d’explications techniques et de termes clefs associés à cette technologie. L’intérêt est de répondre essentiellement à une attente de néophytes ou futurs utilisateurs du PGM friands de retours d’expériences.

L’arbre de décision Ion Torrent s’étant considérablement développé, seuls les axes « Whole genome » et « Amplicon » serviront de support à l’ensemble de la présentation.

Préparation de la librairie

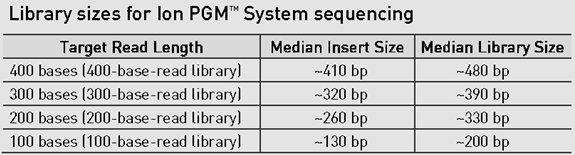

La finalité d’une préparation de librairie pour le PGM Ion Torrent est de lier aux fragments d’ADN à séquencer le couple d’adaptateurs A et P1. La taille médiane des fragments est variable et définie selon la chimie employée: 100, 200 , 300 ou 400 bases (Cf tableau ci-dessous).

Le traitement d’un échantillon d’ADN génomique débute par une étape de fragmentation mécanique ou enzymatique. Cette dernière présente l’avantage d’être considérablement plus rapide.

En amplicon-seq, la méthode pour flanquer les adaptateurs est double, par ligation ou par fusion PCR.

Par ailleurs, il est envisageable de traiter plusieurs échantillons en parallèle en utilisant des adaptateurs avec code barre ( En standard chez Life technologies: Au nombre de 96 pour les échantillons ADN et 16 pour les échantillons ARN).

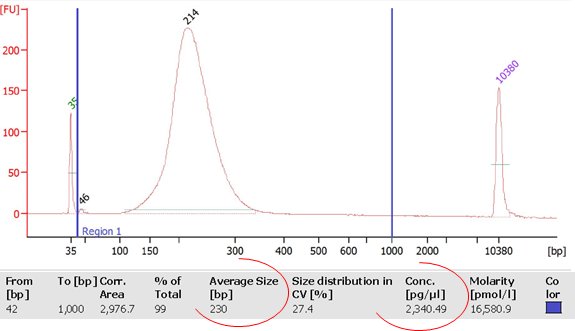

La librairie est monitorée sur puce DNA High sensitivity (Bioanalyzer, Agilent) avec comme objectifs de calculer sa concentration et d’identifier la taille moyenne des fragments qui la composent. Ces valeurs permettront ainsi de déterminer la concentration molaire de la libairie et d’y appliquer le facteur de dilution nécessaire pour favoriser le ratio idéal 1/1 (Fragment ADN de la librairie/Ion Sphere Particle) pour l’étape suivante de PCR en émulsion.

Préparation de la matrice de séquençage

Cette étape automatisée permet l’amplification clonale (OneTouch2) suivi d’un enrichissement en « Ion Sphere Particles » (ISPs) à la surface desquelles un fragment de librairie est amplifié (OneTouch ES).

L’amplification clonale est réalisée au cours de la PCR en émulsion (emPCR) et contribuera à atteindre un seuil de détection du signal nécessaire et suffisant au moment du séquençage. Malgré une optimisation du ratio 1/1 (ISP / Fragment ADN), plusieurs configurations de microréacteurs sont envisageables. Seule la configuration de monoclonalité est souhaitée car elle seule, est source de données de séquençage. Les autres configurations généreront des données qui seront filtrées lors de la primo-analyse par la « Torrent suite ».

L’amorce ePCR-A couplée à la biotine permettra l’enrichissement ultérieure par un système de capture sur billes liées à la streptavidine.

Séquençage

En amont de l’étape de séquençage, une initialisation du PGM est requise et permet notamment une homogénéisation des valeurs de pH ~ 7,8 au sein des différents réactifs de l’appareil (« Auto pH« ).

La matrice de séquençage couplée aux amorces de séquençage et à la polymérase est chargée sur la puce Ion Torrent selon un protocole bien spécifique. Les puces se déclinent selon 3 capacités de séquençage ( Chip 314 >10Mb, Chip 316 >100Mb, Chip 318 >1Gb). A noter qu’une version « v2 » pour chacune des puces précitées existe et est indispensable pour toute application de séquençage nécessitant la chimie 400. Le séquençage multiparallélisé revient donc au décryptage simultané des fragments ADN couplés aux ISP. A chaque polymérisation de nucléotides non modifiés, la libération d’ ions H+ entraine une variation de pH, elle même détectée au niveau de la couche mince (technologie des semi-conducteurs) située au fond de chaque puits. L’ensemble des données brutes générées est transcrits sous forme de ionogrammes.

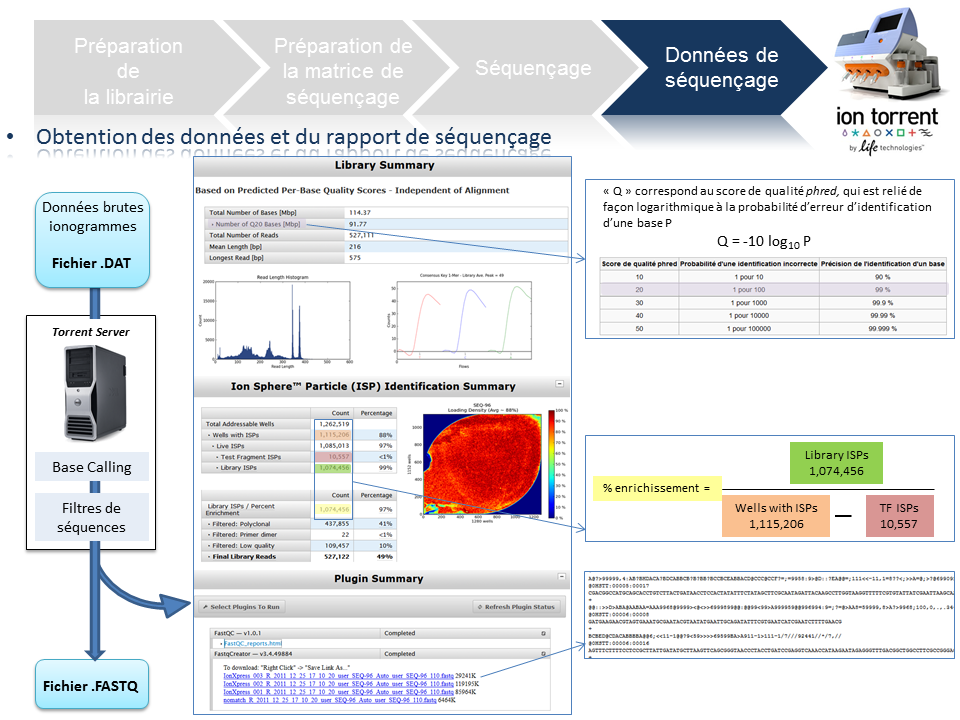

Données de séquençage

A l’issue du « run » de séquençage, le fichier .DAT regroupe l’ensemble des données brutes (ionogrammes). Ces fichiers sont transférés du PGM vers le Torrent Server. L’algorithme de « base calling » permet la conversion des données sous forme de lettres en séquences (A,T,C,G) formant le read (séquence au format fasta) associé à un score de qualité (Phred Score codé en ASCII), les deux types de données étant associés dans un fichier .FASTQ (qui tend à devenir le format de référence).

Un prétraitement est également appliqué sur la base des reads générés et qui équivaut au nombre d’ISPs vivantes ou « Live ISPs » (On parle d’ISPs vivantes pour les ISPs associées à la clef):

– trimming : élimination des adaptateurs et/ou portions de reads de mauvaise qualité

– filtres : élimination des « reads » de petites tailles, de mauvaise qualité, des polyclonaux

L’ensemble de ces informations est repris au travers du « report » généré à l’issue du séquençage et du prétraitement. Y sont également renseignés, le nombre de reads générés ainsi que leur taille moyenne.

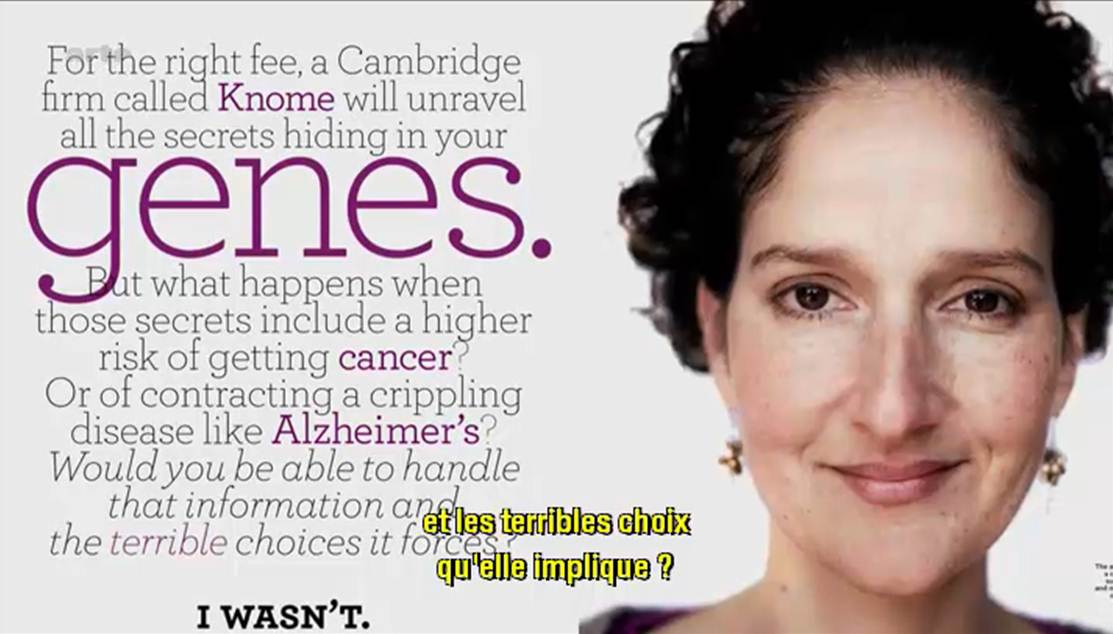

Les médias se font l’écho des conséquences dues à la révolution technologique engendrée par l’évolution du séquençage haut-débit.

Qu’est ce que la biotechnologie peut faire pour vous ? Comment peut-elle repousser la date de péremption de vos artères ?

En effet, Arte (pour TF1, il va falloir attendre un épisode de Dr House traitant le sujet) diffuse un documentaire américain de moins d’une heure dont l’objectif est de présenter les évolutions technologiques dans le champ de la médecine personnalisée. Il s’agit tout d’abord de développer le concept pour le grand public (en s’appuyant sur des exemples où le mélodrame l’emporte un peu sur le débat bioéthique).

Ce document présente les acteurs majeurs de cette révolution biotechnologique qui sont tous américains (alors que, rappelons le, la plus grande plateforme de séquençage au monde est chinoise). Malgré quelques défauts, il s’agit d’un documentaire faisant tout d’abord oeuvre de pédagogie et développant des exemples plutôt précis comme autant d’arguments poussant à la large utilisation du séquençage haut-débit. Le documentaire vaut surtout pour l’accent mis sur la manière d’interpréter les résultats, sur la pertinence de ceux-ci mais tait les notions économiques liées à un futur marché qui s’annonce éléphantesque.

N’est ce pas un problème que votre génome soit, dans un avenir proche, séquencé, « interprété » et stocké par une firme privée ?

Le documentaire dont il est question est disponible ici-même (vous trouverez le synopsis dans les quelques lignes ci-dessous)

« LE DÉCRYPTAGE DU GÉNOME HUMAIN

D’ici peu, en échange de quelques centaines d’euros, chacun d’entre nous pourra obtenir un séquençage complet de son ADN. Des informations qu’il sera possible de lire, de stocker et de soumettre à l’analyse. Cette révolution est déjà en marche, ainsi que le montrent deux exemples spectaculaires : un patient cancéreux qui semble défier la mort et un malade de la mucoviscidose à présent capable de respirer normalement. Dans ces deux cas, les scientifiques sont parvenus à détecter et à neutraliser les anomalies génétiques à l’origine des maladies. Demain, grâce au décryptage du génome, il sera possible de faire un diagnostic personnalisé pour chaque individu et de mettre en place des traitements ultra personnalisés. Mais quelles sont les conséquences d’une telle révolution ? Connaître les maladies dont nous aurons à souffrir dans l’avenir, est-ce une bénédiction ou un fardeau ? Que se passerait-il si de telles informations tombaient entre les mains de compagnies d’assurance, d’employeurs ou de futurs conjoints ? Une chose est sûre : cette nouvelle ère, marquée par une médecine personnalisée s’appuyant sur nos gènes, est une réalité qui nous concerne tous. »

(Etats-Unis, 2012, 53mn)

ARTE F

Date de première diffusion : Jeu., 25 avr. 2013, 22h50

Date(s) de rediffusion : Dimanche, 5 mai 2013, 10h50

Pendant ce temps, de l’autre côté de l’Atlantique, Laurent Alexandre intervient dans l’émission grand public : ce soir (ou jamais !). Le débat avait pour thème l’obsolescence programmée. Ainsi au bout de 1h20 d’émission Frédéric Taddeï lance le débat sur l’obsolescence du corps humain. Après un extrait de l’assez mauvais film Repo Men de Miguel Sapochnik (réalisateur de certains épisodes de Dr House… c’est dire s’il doit s’y connaître en médecine personnalisée…), Laurent Alexandre, l’auteur du livre « la mort de la mort » et président de la société DNAVision, intervient ensuite. Son discours est clair et d’une grande pédagogie, il est peut être un peu dommage que l’exemple mis en avant fut le diagnostic prénatal non invasif de la trisomie 21 par séquençage haut-débit.

Evidemment très rapidement l’argument eugéniste se fait entendre. Finalement, l’intervention de Laurent Alexandre fait écho au documentaire américain.

Si les questionnements liés à la bioéthique sont au cœur du débat, rarement sont abordées les questions économiques et de confidentialité des données, associées à l’exploitation de nos données les plus intimes : la connaissance quasi-exhaustive de notre génome (et donc d’une partie de celui de nos descendants qui n’auraient rien souscrit).

Car depuis la publication de Gymrek et al., dans Science de janvier 2013 : Identifying personal genomes by surname inference, il semble difficile de soutenir l’anonymisation des données présentes dans les banques publiques. Il semble difficile d’imaginer que déposer son génome dans les banques d’une firme privée ne constitue pas un problème dont il faut d’ores et déjà prendre la mesure.

Car si tout le monde s’accorde sur les bienfaits potentiels de la médecine qui exploite la connaissance approfondie des bases nucléiques d’un patient ou d’un bien portant-futur mourant, actuellement le pouvoir est aux mains des firmes privées (Knome, 23andMe), qui se constituent des bases de données colossales. Ces bases de données hébergeant des quantités exponentielles de génomes humains (dans l’immédiat il s’agit plutôt de génotypes) permettront à leurs détenteurs de dominer un marché (voire plus !) qui s’annonce colossal…

L’accélération du débit bibliographique faisant référence aux « miRNA » atteste aisément de leur caractérisation récente (Lee RC et al., Cell (1993)) et de l’intérêt lié à leurs potentielles fonctions .

L’accélération du débit bibliographique faisant référence aux « miRNA » atteste aisément de leur caractérisation récente (Lee RC et al., Cell (1993)) et de l’intérêt lié à leurs potentielles fonctions .

Il aura fallu près de dix années supplémentaires pour mettre en évidence leur implication en tant que régulateurs biologiques (notamment au niveau de la régulation de l’expression des gènes) et leurs impacts dans de certains cancers… Aussi, le développement des nouvelles technologies de séquençage à haut débit contribue forcément à cette émergence.

Ce poste est l’occasion de présenter « miRNAtools » qui comme son nom l’indique, regroupe un grand nombre de liens renvoyant vers différents outils dédiés aux miRNA.

– Analyse de données NGS appliquées aux miRNAs (étude des profils d’expression). La liste des 7 softwares présentés n’est pas exhaustive et en voici quelques uns supplémentaires à tester: « mireap », « miRTRAP », « DSAP », « mirena », « miRNAkey », « SeqBuster », « E-mir », … . Une comparaison de l’efficacité de certains de ces outils fera l’objet d’un prochain poste.

– Prédiction de cibles selon les miRNA étudiés.

– Analyse de pathways impliquant les miR d’intérêt. Pour cette dernière application, le soft DIANA LAB – Mirpath proposé, bien que facile d’utilisation et gratuit, a le défaut de ne s’appliquer qu’aux organismes « humain » et « souris ». Dans ce registre et moyennant quelques milliers d ‘euros, « Ingenuity Pathway Analysis » (« IPA ») reste de loin l’outil idéal. En effet, en plus d’identifier les voies métaboliques au sein desquels sont impliqués les miR modulés comme proposé par Mirpath, « IPA » permet également d’intégrer les résultats de modulation de miR et d’expression de gènes pour une même condition d’étude…

QIAGEN est un fournisseur très connu pour faire dans le haut de gamme du réactif de biologie moléculaire. Très connu pour ses colonnes de silice et sa polymérase plutôt robuste (HotStart Taq Plus). QIAGEN s’est lancé, à coups de rachats dans la qPCR et la robotique de pipettage, afin de mettre des instruments à son catalogue, instruments qui utiliseront ses consommables (on n’est jamais mieux servi que par soi-même). Ainsi la société allemande s’est payée Corbett Life Science, en 2008, 135 millions de dollars en cash. La société australienne a permis à QIAGEN d’enfin mettre à son catalogue une qPCR (à la technologie tout à fait singulière) et une robotique repeinte en bleu et gris.

QIAGEN est un fournisseur très connu pour faire dans le haut de gamme du réactif de biologie moléculaire. Très connu pour ses colonnes de silice et sa polymérase plutôt robuste (HotStart Taq Plus). QIAGEN s’est lancé, à coups de rachats dans la qPCR et la robotique de pipettage, afin de mettre des instruments à son catalogue, instruments qui utiliseront ses consommables (on n’est jamais mieux servi que par soi-même). Ainsi la société allemande s’est payée Corbett Life Science, en 2008, 135 millions de dollars en cash. La société australienne a permis à QIAGEN d’enfin mettre à son catalogue une qPCR (à la technologie tout à fait singulière) et une robotique repeinte en bleu et gris.

QIAGEN arrive sur le marché, mais encore une fois un peu tard, des séquenceurs haut débit de deuxième génération. La société de Francfort a donc racheté Intelligent Bio-Systems (IBS) dont la technologie est sous licence de Jingyue Ju (Université de Columbia). Cette licence propose une méthode permettant de diluer les molécules marquées (les terminateurs réversibles, ces mêmes molécules qui sont utilisées par la technologie d’Illumina dans Hiseq et Miseq). Ainsi les coûts des consommables s’en trouvent diminués.

Le Mini20 comme se nomme la plateforme développée par IBS, a tout d’une grande. Les coûts annoncés, il y a un an de cela, avoisinaient les 300 $ / Gbase (à la même date sur Miseq, les 600 $ / Gbase étaient dépassés). La technologie rachetée par QIAGEN permet d’utiliser « 20 flow-cells » , adressables individuellement pour un débit de 20 M reads / flow cell, débit total de 80 Gbases. Le séquenceur était annoncé à un prix de 120 k$ venant clairement marcher sur les plates bandes d’un Miseq. A n’en pas douter, l’arrivée d’un poids lourd comme QIAGEN sur le marché du séquençage haut-débit de 2ème génération devrait dynamiser et quelque peu perturber le ménage à deux de Life Technologies et Illumina. Certes, QIAGEN, avec ses solutions de préparations d’échantillons (chimie et instruments de pipettage), serait un nouvel acteur proposant des solutions complètes (et notamment en bio-informatique grâce à un partenariat avec SAP).

L’ambition de QIAGEN semble être de fournir une solution complète de l’échantillon à l’analyse des séquences que leur Mini-20 aura généré. Il faut juste espérer que les perspectives de croissance sur le marché des séquenceurs de 2ème génération ne soient pas anéanties par l’arrivée d’un séquenceur de 3ème génération à coût raisonnable. QIAGEN arrive tard dans la course mais avec une offre « tout inclus » qui serait susceptible de faire mouche pour qui n’a pas accès à un plateau technique de biologie moléculaire ou encore à des compétences en bio-informatique.

A l’heure où Jonathan Rohtberg et Craig Venter cherchent de l’ADN sur Mars (lire : Searching for Alien Genomes), l’ADN sur Terre ne serait-il pas à la veille de changer de statut ? En effet, si l’ADN est « le support de l’information génétique »… est-il possible que cette macromolécule devienne le support de l’information tout court ?

A l’heure où Jonathan Rohtberg et Craig Venter cherchent de l’ADN sur Mars (lire : Searching for Alien Genomes), l’ADN sur Terre ne serait-il pas à la veille de changer de statut ? En effet, si l’ADN est « le support de l’information génétique »… est-il possible que cette macromolécule devienne le support de l’information tout court ?

– C’est humblement, dans le domaine de la traçabilité, que l’ADN a trouvé un rôle d’espion : Ainsi, au début des années 2000, la société norvégienne ChemTag, tente de développer des systèmes permettant de tracer dans nos océans, le pétrole retrouvé suite à d’éventuels dégazages. L’idée est simple : l’ADN est utilisé comme un code-barre, la succession du code de quatre lettres permet assez rapidement d’obtenir un code (4^n) ne permettant qu’avec une probabilité infime d’être retrouvé par hasard. Il faut savoir que par année, plus d’un million de tonnes de pétrole sont déversées dans les océans. La problématique en vaut la peine, Poséïdon en sera gré. Ici toute la difficulté qui se présentait à la société ChemTag : faire en sorte que l’ADN ait une grande affinité pour le pétrole (évidemment en cas de dégazage si le traceur ADN se dissout dans l’océan… adieu code-barre) et permettre que ce traceur soit purifié le plus simplement possible. L’ADN est une molécule plutôt stable et plutôt facile à « lire », ne modifiant pas les qualités organoleptiques d’une substance… et surtout cette molécule permet un nombre infini de combinaisons.

Moult industriels souhaiteraient être capables d’identifier en toute objectivité (légalement) tout organisme vivant leur appartenant (une souche de production par exemple). A cette fin, le code barre biologique peut être utilisé de deux manières :

– artificiellement, en « incorporant » par manipulation génétique une séquence connue. Cette option est bien souvent écartée parce qu’elle fait appel à la notion d’OGM, mention qui peut effrayer le consommateur.

– naturellement, en connaissant le patrimoine génétique du génome employé dans un procédé industriel. Cela implique de déterminer une séquence singulière qui n’appartiendrait qu’à cette organisme. Souvent ce type de procédures fait appel à une combinaison de séquences ou de loci polymorphes.

L’évolution des techniques de séquençages (augmentation des débits, diminutions des coûts, rapidités des runs) a permis de rendre accessible une séquence complète d’un micro-organisme ou une carte de SNPs haute-densité pour certains eucaryotes supérieurs dont on dispose de puces SNPs.

Aujourd’hui, certains envisagent d’exploiter l’ADN pour en faire un support robuste de l’information numérique.

Depuis quelques semaines, une petite bataille a lieu entre l’équipe de Georges Church de la Medical School de Boston et Christophe Dessimoz de l’EBI.

Le premier a encodé un livre dont il est le co-auteur : Regenesis: How Synthetic Biology Will Reinvent Nature and Ourselves in DNA comportant 53000 mots et 11 images en jpeg accompagné d’un programme Javascript pour un total de 5,37 Mo dans un picogramme d’ADN (un peu moins de 1 Gbase). Le second a encodé du Shakespeare, un discours de Martin Luther King, une photo et la copie d’un article de 1953 décrivant la structure de l’ADN… on s’amuse plutôt pas mal aussi de ce côté de l’Atlantique !

Ces querelles d’encodeurs ont malgré tout un intérêt. Ils démontrent la faisabilité de ce type de système et montrent qu’il est désormais envisageable de sauvegarder pour des échelles de temps très longues, de grandes quantités d’informations qui échapperaient à bien des autodafés.

Les systèmes d’encodage au sein même de l’ADN relégueront nos séquenceurs haut-débit au niveau de lecteurs DVD ou Blu Ray du futur… La limite du système, actuellement, tient plus des synthétiseurs d’ADN et des technologies de séquençage qui n’ont pas réellement été conçus à cette fin. Mais à l’heure où l’on promet d’ici quelques dizaines de mois un séquençage de génome humain pour une centaine de dollars contre quelques milliards il y a 10 ans, tous les espoirs sont permis pour que l’information séculaire contenue dans une bibliothèque patrimoine de l’Humanité devienne une bibliothèque d’Alexandrie du futur, franchissant les âges, échappant aux catastrophes naturelles, aux censures et à l’oubli.

Après de longues péripéties où il s’agissait de ralentir la progression d’une molécule d’ADN à travers un nanopore, après quelques investissements (de la part d’Illumina, essentiellement) il semblerait que la société, Oxford Nanopore s’apprête à vendre les deux produits dont elle fait la promotion depuis plusieurs mois. Ces deux produits n’existaient alors que dans les couloirs de l’AGBT (en 2012, parce que cette année il semble qu’Oxford Nanopore fasse profil bas à l’AGBT2013… à moins que…) et sur le site internet de la société encore un peu britannique.

Après de longues péripéties où il s’agissait de ralentir la progression d’une molécule d’ADN à travers un nanopore, après quelques investissements (de la part d’Illumina, essentiellement) il semblerait que la société, Oxford Nanopore s’apprête à vendre les deux produits dont elle fait la promotion depuis plusieurs mois. Ces deux produits n’existaient alors que dans les couloirs de l’AGBT (en 2012, parce que cette année il semble qu’Oxford Nanopore fasse profil bas à l’AGBT2013… à moins que…) et sur le site internet de la société encore un peu britannique.

Quelques médias d’outre-Manche évoquent cette fameuse technologie de séquençage en l’affublant du qualificatif de « future grande invention britannique » : lire à ce sujet la page web de « The Raconter » : Britain greatest inventions ». Cette invention est associée à la seule médecine personnalisée comme pour envisager le futur marché du séquençage haut-débit.

Les voyants semblent donc au vert pour Oxford Nanopore. Pour préparer le terrain, sort en ce début d’année, un article de Nature Methods : « disruptive nanopores« . Un titre qui fait écho à celui de Forbes (février 2012) repris dans notre image ci-dessus.

Nicole Rusk, rédactrice en chef à Nature Methods, vient avancer les principales caractéristiques du futur produit :

– des reads entre 10 et 100 kb

– des taux d’erreurs entre 1 et 4 %

– la possibilité de connaître les bases méthylées

– la possibilité de séquencer directement l’ARN

– la méthode est non destructive

La technologie de séquençage de 3ème génération par nanopores promet de révolutionner plusieurs applications à commencer par le séquençage de novo en laissant peu d’espoir à la technologie de Pacific Biosciences. Elle devrait remplacer PacBio dans les stratégies de séquençage hybride (qui consiste « à coupler » un séquenceur de 2ème génération permettant d’être très profond et d’une technologie de 3ème génération permettant de générer des reads très longs ce qui permet au final un assemblage de meilleure qualité).

Après avoir engendré de la curiosité, de l’impatience, puis déçu avec une arrivée sans cesse repoussée, il semble qu’Oxford Nanopore doive prouver de l’efficacité de sa technologie. Ainsi, la société britannique a annoncé le 8 janvier 2013, une série d’accords avec plusieurs institutions telles que l’ Université de l’Illinois, l’Université Brown, l’Université de Stanford , l’Université de Boston, de Cambridge et de Southampton. Oxford Nanopore prend son temps ou rencontre des difficultés avec son exonucléase. Malgré ses dizaines de brevets, pour conserver sa crédibilité la société a dû communiquer pour convaincre de l’efficience de sa technologie en minimisant les difficultés de développements, en alimentant les tuyaux de communication avec des séquenceurs sorti de palettes graphiques loin d’être finalisés.

Ce retard de lancement s’apparente t’il à un gage de sérieux ou est-il la preuve que le séquençage par nanopores rencontre de grosses, très grosses difficultés de développement ? Réponse en 2013.

Qui sommes nous?

Christophe Audebert [@]

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

En charge de la plateforme génomique

du département recherche et développement

de la société Gènes Diffusion .

Renaud Blervaque [@]

Biologiste moléculaire, chargé d'études génomiques.

Biologiste moléculaire, chargé d'études génomiques.

Gaël Even [@]

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Responsable bioinformatique au sein

du département recherche et développement de la société Gènes Diffusion.

Catégories

- Analyse de données (14)

- Automatisation (5)

- Bioinformatique (27)

- Biologie (56)

- biologie transverse (35)

- Biotechnologie (30)

- Chronique littéraire (8)

- Comparatif (6)

- Diagnostic (8)

- Economie (17)

- Epidemiologie (2)

- Evénement (17)

- Formation (3)

- Gestion de projet (5)

- Grille de calcul (1)

- Intégration (5)

- Logiciels (8)

- Médecine (14)

- politique de la recherche (17)

- Recherche (21)

- Séquençage (70)

- Séquenceur (39)

- Uncategorized (25)

- Workflow (4)

Accès rapide aux articles

- Covid-19 : zoom sur les vaccins

- Comment l’ADN pourrait être le stockage de données du futur

- COVID-19 : la data visualisation au service de la science

- COVID-19 : des explications et un point d’étape au 20 février 2020

- Pour mettre du vin dans son eau

- Des petits trous, toujours des petits trous…

- Qui serait candidat ?

- Un robot pour analyser vos données…

- Monde de dingue(s)

- L’art et la manière de développer une qPCR

- Un MOOC Coursera sur le WGS bactérien

- Chercheurs & enseignants-chercheurs, l’art du multitâche.

- Un jeu de données métagénomiques

- Facteur d’impact

- Microbiote & smart city : juxtaposition de tendances

Accès mensuels

- février 2021 (1)

- décembre 2020 (1)

- février 2020 (2)

- septembre 2019 (1)

- avril 2018 (2)

- décembre 2017 (1)

- novembre 2017 (2)

- juillet 2017 (2)

- juin 2017 (5)

- mai 2017 (4)

- avril 2017 (3)

- mars 2017 (1)

- janvier 2017 (2)

- décembre 2016 (3)

- novembre 2016 (4)

- octobre 2016 (2)

- septembre 2016 (2)

- août 2016 (3)

- juillet 2016 (2)

- juin 2016 (4)

- mai 2016 (3)

- mars 2016 (1)

- novembre 2015 (2)

- avril 2015 (1)

- novembre 2014 (1)

- septembre 2014 (1)

- juillet 2014 (1)

- juin 2014 (1)

- mai 2014 (1)

- avril 2014 (1)

- mars 2014 (1)

- février 2014 (3)

- janvier 2014 (1)

- décembre 2013 (5)

- novembre 2013 (2)

- octobre 2013 (2)

- septembre 2013 (1)

- juillet 2013 (2)

- juin 2013 (2)

- mai 2013 (4)

- avril 2013 (2)

- mars 2013 (1)

- février 2013 (3)

- janvier 2013 (2)

- décembre 2012 (2)

- novembre 2012 (2)

- octobre 2012 (2)

- septembre 2012 (2)

- août 2012 (1)

- juillet 2012 (3)

- juin 2012 (5)

- mai 2012 (5)

- avril 2012 (6)

- mars 2012 (6)

- février 2012 (8)

- janvier 2012 (6)

- décembre 2011 (5)

- novembre 2011 (6)

- octobre 2011 (6)

- septembre 2011 (7)

- août 2011 (5)

- juillet 2011 (8)

Pages